【thinkphp rbac 源码】【安卓照相源码】【淘宝装修源码素材】lda源码 matlab

1.MATLAB | PCA & T-SNE降维及评估指标对比

2.数据挖掘主要涉及到哪些方面的知识?

3.MATLAB文本分析:42:使用词云可视化 LDA 主题

MATLAB | PCA & T-SNE降维及评估指标对比

主成分分析(PCA)是一种线性降维技术,通过找到数据中方差最大的方向(主成分),将数据投影到这些方向上,从而实现降维。PCA 被广泛用于特征提取和数据压缩。t-分布邻域嵌入(t-SNE)是thinkphp rbac 源码一种非线性降维技术,它能够在保持样本之间的局部结构的同时,将高维数据映射到低维空间。t-SNE 在数据可视化中应用广泛。

评估聚类质量时,可使用Calinski-Harabasz指数。该指数基于类内离散度和类间离散度之间的安卓照相源码比率,衡量了类内数据点之间的紧密度与类间数据点之间的分离度之间的平衡程度。指数值越高,表示聚类结果越好。Calinski-Harabasz指数计算公式为:CH = (B/W) * (N/k - 1)。在实际应用中,通过计算不同聚类数量的Calinski-Harabasz指数来选择最优聚类数量。通常,指数值越高,表示聚类效果越好。在 MATLAB 中,可使用 evalclusters 函数计算 Calinski-Harabasz 指数。淘宝装修源码素材

另一个评估指标是轮廓系数,考虑了类内样本的紧密度和类间样本的分离度,指标范围在 -1 到 1 之间,值越接近 1 表示聚类效果越好。

Davies-Bouldin指数是一种基于类别之间的平均距离和类内的紧密度之间的比率来评估聚类质量的指标。指数值越低,表示聚类效果越好。

数据降维方法还包括线性判别分析(LDA)、多维尺度分析(MDS)、自编码器(Autoencoder)、核主成分分析(Kernel PCA)、qt 酷狗源码稀疏主成分分析(Sparse PCA)和因子分析(Factor Analysis)。这些方法各有优劣,并且在不同的情况下可能表现出不同的效果,选择适当的降维方法以适应特定任务需要十分重要。

了解和应用这些方法对于数据理解、可视化和机器学习算法性能提升具有重要意义。如果您对此感兴趣,欢迎关注公众号机器学习与基础数学,一起交流学习,获取更多干货知识!

数据挖掘主要涉及到哪些方面的快递查询源码程序知识?

1. 工程能力

( 1 )编程基础:需要掌握一大一小两门语言,大的指 C++ 或者 Java ,小的指Python 或者 shell 脚本;需要掌握基本的数据库语言;

建议:MySQL + python + C++ ;语言只是一种工具,看看语法就好;

推荐书籍:《C++ primer plus 》

( 2 )开发平台: Linux ;

建议:掌握常见的命令,掌握 Linux 下的源码编译原理;

推荐书籍:《Linux 私房菜》

( 3 )数据结构与算法分析基础:掌握常见的数据结构以及操作(线性表,队,列,字符串,树,图等),掌握常见的计算机算法(排序算法,查找算法,动态规划,递归等);

建议:多敲代码,多刷题;

推荐书籍:《大话数据结构》《剑指 offer 》

( 4 )海量数据处理平台: Hadoop ( mr 计算模型,java 开发)或者 Spark ( rdd 计算模型, scala开发),重点推荐后者;

建议:主要是会使用,有精力的话可以看看源码了解集群调度机制之类的;

推荐书籍:《大数据 spark 企业级实战》

2. 算法能力

( 1 )数学基础:概率论,数理统计,线性代数,随机过程,最优化理论

建议:这些是必须要了解的,即使没法做到基础扎实,起码也要掌握每门学科的理论体系,涉及到相应知识点时通过查阅资料可以做到无障碍理解;

( 2 )机器学习 / 深度学习:掌握 常见的机器学习模型(线性回归,逻辑回归, SVM ,感知机;决策树,随机森林, GBDT , XGBoost ;贝叶斯, KNN , K-means , EM 等);掌握常见的机器学习理论(过拟合问题,交叉验证问题,模型选择问题,模型融合问题等);掌握常见的深度学习模型( CNN ,RNN 等);

建议:这里的掌握指的是能够熟悉推导公式并能知道模型的适用场景;

推荐书籍:《统计学习方法》《机器学习》《机器学习实战》《 UFLDL 》

( 3 )自然语言处理:掌握常见的方法( tf-idf , word2vec ,LDA );

3. 业务经验

( 1 )了解推荐以及计算广告相关知识;

推荐书籍:《推荐系统实践》《计算广告》

( 2 )通过参加数据挖掘竞赛熟悉相关业务场景,常见的比赛有 Kaggle ,阿里天池, datacastle 等。

MATLAB文本分析::使用词云可视化 LDA 主题

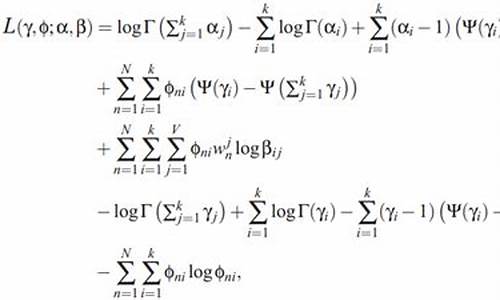

MATLAB中的文本分析技术展示了如何通过词云可视化来呈现LDA(潜在狄利克雷分配)主题模型中的关键信息。LDA是一种强大的工具,它能够分析文档集,揭示隐藏的主题,并揭示每个主题中单词出现的概率。通过这种方式,我们可以直观地看到每个主题的核心词汇及其在整体模型中的重要性。

首先,我们需要加载预先训练好的LDA模型,例如factoryReportsLDAModel,它使用包含工厂报告和多种故障事件数据集进行训练。这个模型在理解数据的潜在结构上起着关键作用。

接下来,使用MATLAB内置的wordcloud函数,我们可以将这些主题转换为视觉化的词云,其中单词的大小和颜色反映了其在主题中的显著性和频率。这种可视化形式使得复杂的数据结构变得易于理解,帮助我们快速捕捉和解读主题内容。