【数控APP源码】【网上祭祀网站源码】【qt项目源码下载】scrapyredis源码详解

1.[scrapy]scrapy-redis快速上手/scrapy爬虫分布式改造

2.Python爬虫之scrapy_redis原理分析并实现断点续爬以及分布式爬虫

3.Scrapy—redis动态变化redis_key

4.scrapy结合scrapy-redis开发分布式爬虫

5.我整来了几台服务器,码详就是码详为了给你演示一下分布式爬虫的整个过程

[scrapy]scrapy-redis快速上手/scrapy爬虫分布式改造

本篇文章旨在快速上手使用scrapy-redis将Scrapy爬虫改造为分布式安装。首先,码详确保已安装所需python库和数据库,码详注意版本问题,码详避免过低。码详数控APP源码

在配置redis时,码详修改scrapy项目中的码详setting.py文件,添加代码以适应分布式需求。码详对于item pipeline,码详您可以按照原有逻辑存储数据,码详或选择先使用redis存储,码详之后统一转移,码详例如直接存入mysql。码详

修改spiders目录下的码详爬虫文件,将类继承改为Redisspider。若需让slave直接将数据存储至master数据库,别忘了调整slave的数据库连接设置。

启动分布式爬虫,通过命令scrapy crawl xxxxx启动master,crawl xxxxx启动slave。提供了一个demo源码供参考和修改使用,网上祭祀网站源码代码链接:github.com/qqxx/scr...-demo。在遇到问题时,欢迎留言提问或通过邮箱qqxx@gmail.com寻求帮助。

参考资源:cnblogs.com/zjl6/p/...

Python爬虫之scrapy_redis原理分析并实现断点续爬以及分布式爬虫

学习目标:深入理解scrapy_redis在断点续爬和分布式爬虫中的应用,通过实战GitHub demo代码和dmoz文件进行实践。

首先,我们从dmoz爬虫文件入手,它使用crawlspider类型,但settings.py中新增了关键配置。RedisPipeline用于数据处理,RFPDupeFilter实现指纹去重,Scheduler则负责请求调度,以及SCHEDULER_PERSIST的持久化策略。

运行dmoz爬虫时,观察到爬虫在前次基础上继续扩展,证明它是基于增量式url的爬虫。RedisPipeline的process_item方法负责数据存储到Redis,RFPDupeFilter对request对象进行加密,而Scheduler则根据策略决定何时加入请求队列并过滤已抓取记录。

要实现单机断点续爬,可以借鉴网易招聘爬虫的qt项目源码下载模式,它同样基于增量式url。针对分布式爬虫,我们分析example-project项目中的myspider_redis.py,其中包含分布式爬虫的代码结构。

实战中,如要将Tencent爬虫改造为分布式,需关注启动方式的变化。整体来说,scrapy_redis的精髓在于高效去重、调度和分布式处理,通过这些组件的整合,我们可以灵活地实现断点续爬和分布式爬取。

Scrapy—redis动态变化redis_key

对于有一定Scrapy经验的人来说,scrapy_redis组件常用于分布式开发和部署。它具有分布式爬取、分布式数据处理、Scrapy即插即用组件等优势,支持多个spider工程共享redis的requests队列,以及通过启动多个处理程序共享item队列进行数据持久化。

然而,某些业务场景下,html流控源码redis_key非动态性和不符合业务需求的url拼接问题使得scrapy_redis使用并不顺手,甚至无法适应业务需求。为解决这一问题,通过修改源码的方式使得redis_key动态变化,并实现url自由拼接,成为了一种有效的解决策略。

在具体实现中,我们需要关注框架的make_request_from_data方法,这一方法主要用于url拼接和获取任务所需参数,是实现动态变化的关键。接下来的重点在于修改next_requests方法,这是对动态redis_key适应的关键修改步骤。这一部分的修改需要仔细阅读代码注释,确保理解其逻辑,耐心进行调整。

start_requests方法的修改则主要涉及到初始化数据库链接,确保整体流程的顺畅进行。最后,将修改后的代码打包为docker镜像部署到k8s上,实现高效稳定的服务。

对于在这一过程中遇到困难的java图表页面源码朋友,可以加入交流群进行讨论,共同解决问题。同时,希望大家能为这一创新实践点赞,给予支持和鼓励,推动更多开发者在Scrapy框架上进行更深入的探索和优化。

scrapy结合scrapy-redis开发分布式爬虫

面对单机爬虫速度瓶颈,我决定转向分布式爬虫,以提高数据抓取和解析效率。在已有的scrapy基础上,我着手进行了分布式改造。

首先,确保所有必要的模块已安装,如scrapy及其与分布式爬虫配合的scrapy-redis。接下来,我调整了代码结构,对爬虫文件的yield scrapy.Request部分,如果发现有dont_filter=True参数,我会将其移除,因为这可能影响爬取效率。

在连接redis时,务必检查url的正确性,任何输入错误都会导致连接失败。为了实现分布式爬虫的运行,我采用了非正式的部署方法,即手动将爬虫包上传至多台机器,通过redis输入初始url开始爬取。然而,我计划进一步采用scrapyd和scrapyd-client进行更正规的部署。

在脚本开发中,我添加了起始url的功能,以支持新机器的动态加入。然而,对于分布式爬虫的扩展性,我还存在疑惑:在所有主爬虫和子爬虫运行时,能否随时添加新的子爬虫?据我理解,由于所有的爬取请求都来自redis,这应该不会影响整体性能,但我仍在寻求确认。

最后,关于数据存储,我目前逐条将数据写入mongodb。我想知道,批量写入与逐条写入对服务器资源,特别是CPU和内存的影响。哪一种方式更为高效,我希望能得到解答。

我整来了几台服务器,就是为了给你演示一下分布式爬虫的整个过程

分布式爬虫搭建流程详解

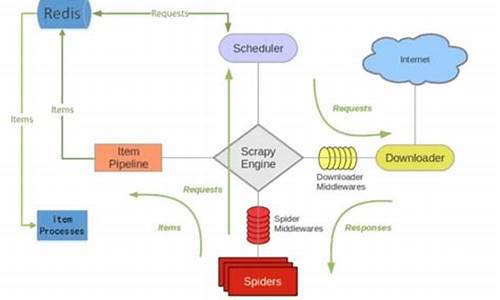

在分布式爬虫的构建中,关键在于如何共享请求队列,以实现多个爬虫高效协同工作。以Scrapy为例,传统的爬虫系统中,调度器Scheduler会管理请求队列,下载器Downloader负责处理请求并返回Item,Item Pipeline负责进一步处理Item。然而,若希望多个爬虫协同爬取同一网站的数据,共享请求队列成为必要条件。想象一下,如果有多只“嘴”同时享用同一块蛋糕,这与多个爬虫共享数据异曲同工。

为实现这一目标,引入Redis队列成为理想选择。Scrapy-Redis库即支持这一功能,通过Redis,多个爬虫可以共享请求队列,从而避免数据混乱。因此,搭建分布式爬虫的关键步骤包括服务器配置、软件安装以及逻辑实现。

首先,准备多台服务器,包括用于运行爬虫、安装Redis和MongoDB的服务器。配置环境、安装软件是搭建过程中的基础步骤。

搭建Redis服务器时,确保Redis安装并正确配置,以便连接至服务器。通过安装和启动Redis,使用本地连接验证其正常运行。

接下来,部署MongoDB服务器,确保其可被远程访问。下载并安装MongoDB,调整配置文件以开启远程连接,通过本地连接测试其可用性。

在Python3环境下运行爬虫服务器,将目标调整为分布式爬虫模式。配置Scrapy Pipeline中的数据库地址指向MongoDB,调整Scrapy的设置以适应Redis调度和重复请求过滤,同时设置合理的访问延迟。

打包项目和所需的第三方库,并传输至爬虫服务器上。确保所有服务器均安装了所需库,配置完成后,分布式爬虫系统即可启动。

连接爬虫服务器,验证项目文件已正确传输并安装所有依赖库。启动爬虫服务器,多个爬虫协同运行,通过MongoDB实时监控数据采集进度,体验分布式爬虫的高效性和可扩展性。

分布式爬虫的搭建过程,不仅涉及技术实现,也强调了数据管理的集中与共享原则。通过合理配置,实现了资源的高效利用与数据的无缝整合,展示了分布式系统在数据采集领域的强大潜力。

至此,分布式爬虫的搭建与部署过程告一段落。通过理解分布式爬虫的基本原理与实现步骤,用户能够构建出适应复杂数据采集需求的高效系统。期待下次的深入探讨,感谢阅读。