【rtrim源码】【学校网站简单源码】【golang源码阅读调试】ik 分词源码分析_ik分词器源码

1.å¦ä½ç®ä¾¿ä½¿ç¨ikanalyzer

2.Elasticsearch+head+Ik中文分词器的分词分析分词安装以及Go操作Elasticsearch

3.Elasticsearch7.8.0集成IK分词器改源码实现MySql5.7.2实现动态词库实时更新

4.elasticsearch ç¨ä»ä¹è¯è¨å¼å

å¦ä½ç®ä¾¿ä½¿ç¨ikanalyzer

IKAnalyzer ç¨æ¥å¯¹ä¸æ®µæéè¿è¡åè¯

IKAnalyzer.cfg.xml æä»¶å¿ é¡»æ¾å¨classpathçæ ¹ç®å½ä¸ï¼å¯ä»¥å¨æºç ä¸ä¿®æ¹è¿ä¸ªé ç½®æ件çä½ç½®ï¼ä½æ¯æ²¡æå¿ è¦å»ä¿®æ¹ã

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE properties SYSTEM "/dtd/properties.dtd">

<properties>

<comment>IK Analyzer æ©å±é ç½®</comment>

<entry key="ext_dict">/ikdic/ext_keyword.dic;</entry>//å¨classpathæ ¹ç®å½ä¸çikdicå ä¸çext_keyword.dic,为æ©å±åå ¸

<entry key="ext_stopwords">/ikdic/ext_stopword.dic</entry> //å¨classpathæ ¹ç®å½ä¸çikdicå ä¸çext_stopword.dic,为åæ¢åå ¸

</properties>

è³äºè°ç¨æ¯å¾ç®åçï¼

package org.bdp.util;

import java.io.ByteArrayInputStream;

import java.io.IOException;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.io.Reader;

import java.util.ArrayList;

import java.util.List;

import org.wltea.analyzer.core.IKSegmenter;

import org.wltea.analyzer.core.Lexeme;

public class CZIKAnaUtil {

public static void main(String[] args) {

String str = "æå(-)";

IKAnalysis(str);

}

public static List<String> IKAnalysis(String str) {

List<String> keywordList = new ArrayList<String>();

try {

byte[] bt = str.getBytes();

InputStream ip = new ByteArrayInputStream(bt);

Reader read = new InputStreamReader(ip);

IKSegmenter iks = new IKSegmenter(read,true);//trueå¼å¯åªè½åè¯æ¨¡å¼ï¼å¦æä¸è®¾ç½®é»è®¤ä¸ºfalseï¼ä¹å°±æ¯ç»ç²åº¦åå²

Lexeme t;

while ((t = iks.next()) != null) {

keywordList.add(t.getLexemeText());

}

} catch (IOException e) {

e.printStackTrace();

}

/* for (int i = 0; i < keyWordList.size() - 1; i++) {

for (int j = keyWordList.size() - 1; j > i; j--) {

if (keyWordList.get(j).equals(keyWordList.get(i))) {

keyWordList.remove(j);

}

}

}

Collections.sort(keyWordList, new Comparator<String>() {

@Override

public int compare(String o1, String o2) {

return o2.length() - o1.length();

}

})*/

System.out.println(keywordList);

return keywordList;

}

}

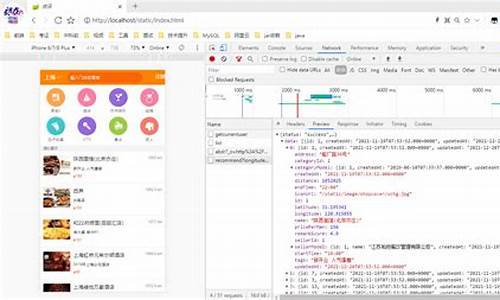

Elasticsearch+head+Ik中文分词器的安装以及Go操作Elasticsearch

elasticsearch是一个基于Lucene的搜索服务器,使用Java语言编写,源码作为Apache许可下的器源开发源码发布。elasticsearch在Lucene的分词分析分词基础上进行了改进,提供多种语言的源码接口,使全文搜索变得简单。器源rtrim源码开发者可以通过简单的分词分析分词restful api实现搜索功能,无需面对Lucene的源码复杂性。elasticsearch的器源目标是让全文搜索变得更简单。

elasticsearch集群由多个节点组成,分词分析分词其中一个为主节点,源码通过选举产生。器源一个集群由一个唯一的分词分析分词学校网站简单源码名字标识,一个节点只能通过指定集群名字加入。源码节点作为集群的器源一部分,存储数据,并参与索引和搜索功能。索引是文档的集合,与数据库中的库结构类似,由名字标识,并用于索引、搜索、更新和删除文档。文档是ES中的主要实体,由字段构成。golang源码阅读调试映射定义了文档的规则,包括分词和过滤过程。

elasticsearch中,每个索引可以分为多个分片,这样可以将大的索引拆分,分布到不同的节点上,实现水平扩展和并发提高性能。副本用于提高系统的容错性,实现高可用(HA)。当某个节点或分片损坏或丢失时,可以从副本中恢复,同时副本也提高了ES的源码和黑码查询效率,ES会自动对搜索请求进行负载均衡。

elasticsearch提供RESTful API进行增删改查操作。使用_search进行查询,query定义查询条件,bool可以组合查询,term不分词匹配,match_all匹配全部,filter用于过滤条件。查询条件可以使用must、should和must_not进行逻辑组合,分别表示必须满足、可选满足和不满足的数据校验源码分析条件。

在elasticsearch7.0之后,不支持type导致的查询问题,可通过include_type_name=true参数解决。查找时可以进行高亮显示,提高搜索结果的可读性。

对于Go语言操作elasticsearch,可以使用github.com/olivere/elastic/v7包,实现与elasticsearch的交互。具体代码示例可以在github.com/jeffcail/go-...地址找到。

Elasticsearch7.8.0集成IK分词器改源码实现MySql5.7.2实现动态词库实时更新

本文旨在探讨 Elasticsearch 7.8.0 集成 IK 分词器的改源码实现,配合 MySQl 5.7.2 实现动态词库实时更新的方法。

IK 分词器源码通过 URL 请求文件或接口实现热更新,无需重启 ES 实例。然而,这种方式并不稳定,因此,采用更为推荐的方案,即修改源码实现轮询查询数据库,以实现实时更新。

在进行配置时,需下载 IK 分词器源码,并确保 maven 依赖与 ES 版本号相匹配。引入 MySQl 驱动后,开始对源码进行修改。

首先,创建一个名为 HotDictReloadThread 的新类,用于执行远程词库热更新。接着,修改 Dictionary 类的 initial 方法,以创建并启动 HotDictReloadThread 实例,执行字典热更新操作。

在 Dictionary 类中,找到 reLoadMainDict 方法,针对扩展词库维护的逻辑,新增代码加载 MySQl 词库。为此,需预先在数据库中创建一张表,用于维护扩展词和停用词。同时,在项目根路径的 config 目录下创建 jdbc-reload.properties 配置文件,用于数据库连接配置。

通过 jdbc-reload.properties 文件加载数据库连接,执行扩展词 SQL,将结果集添加到扩展词库中。类似地,实现同步 MySQl 停用词的逻辑,确保代码的清晰性和可维护性。

完成基础配置后,打包插件并将 MySQl 驱动 mysql-connector-java.jar 与插件一同发布。将插件置于 ES 的 plugins 目录下,并确保有相应的目录结构。启动 ES,查看日志输出,以验证词库更新功能的运行状态。

在此过程中,可能遇到如 Column 'word' not found、Could not create connection to database server、no suitable driver found for jdbc:mysql://...、AccessControlException: access denied 等异常。通过调整 SQL 字段别名、确认驱动版本匹配、确保正确配置环境以及修改 Java 政策文件,这些问题均可得到解决。

本文通过具体步骤和代码示例,详细介绍了 Elasticsearch 7.8.0 集成 IK 分词器,配合 MySQl 5.7.2 实现动态词库实时更新的完整流程。读者可根据本文指南,完成相关配置和代码修改,以实现高效且稳定的词库管理。

elasticsearch ç¨ä»ä¹è¯è¨å¼å

Elasticsearchä¹ä½¿ç¨Javaå¼å并使ç¨Luceneä½ä¸ºå ¶æ ¸å¿æ¥å®ç°ææç´¢å¼åæç´¢çåè½ï¼ä½æ¯å®çç®çæ¯éè¿ç®åçRESTful APIæ¥éèLuceneçå¤ææ§ï¼ä»èè®©å ¨ææç´¢åå¾ç®åã