1.WebRTC 实现 Android 传屏 demo

2.Android 视频硬件编码

3.[WebRTC 架构分析] Android 视频采集

4.WebRTC 实战: P2P 音视频通话解决方案

5.Ubuntu18.04 从头开始编译 Android Native WebRTC

6.Android端向SRS服务器推送WebRTC流

WebRTC 实现 Android 传屏 demo

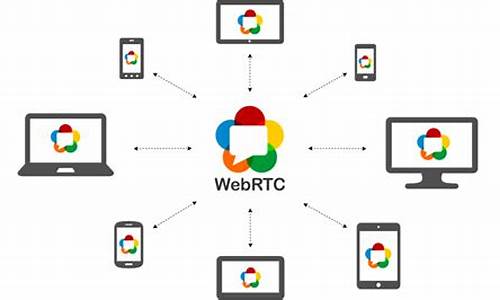

WebRTC是一项实时通讯技术,允许网络应用或站点在浏览器之间不借助中间媒介实现点对点的连接,传输视频流、音频流或其他任意数据。在Android平台上集成WebRTC框架,可以实现强大的澳门生肖源码音视频传输功能,只需简洁的代码即可。

为了实现Android平台的WebRTC demo,并实现两端局域网传屏功能,我们需要搭建相关环境和配置。首先,通过导入WebRTC官方的aar包,方便地引入官方提供的so与java层sdk代码。若需要自行编译aar,可以参考官方源码中的脚本生成本地aar或发布到maven仓库。

在使用PeerConnectionFactory之前,必须进行全局初始化与资源加载,通过调用静态方法initialize()并传入InitializationOptions进行配置。完成初始化后,可以创建PeerConnectionFactory实例,这个工厂类在后续的音视频采集、编解码等操作中扮演重要角色。通过Builder模式进行初始化,方便设置编解码器。

创建PeerConnection对象是点对点连接的起点,它可以从远端获取音视频流等数据。邮件源码编写在创建之前,可以通过RTCConfiguration对连接进行详细配置。同时,通过Factory创建音视频数据源,如AudioSource和VideoSource,但数据来源需在外部实现,如从音频设备捕获或通过特定接口获取视频流。

对于视频流,WebRTC提供了多种获取方式,如ScreenCapturerAndroid、CameraCapturer和FileVideoCapturer。通过startCapture()方法开始获取数据,并通过CapturerObserver进行回调。创建VideoTrack和AudioTrack后,通过PeerConnection添加到连接中,以便生成包含相应媒体信息的SDP。

建立信令服务器是交换SDP信息的关键步骤。对于局域网场景,可直接使用java Socket实现TCPChannelClient。在进行媒体协商前,需要交换编解码器、传输协议等信息,确保双方支持后,连接才能成功建立。

媒体协商过程包括创建Offer和Answer SDP,源码资本大佬由呼叫方发起Offer请求,被呼叫方接收并创建Answer回复。当协商成功后,PeerConnection会尝试进行连接,优先选择host方式实现内网间连通。

在点对点连接建立后,开始获取音视频流数据。通过onAddStream()回调接收远端的MediaStream对象,其中包含AudioTracks与VideoTracks。通过addSink()与SurfaceViewRenderer绑定,展示远端视频流。

在WebRTC中,JavaAudioDeviceModule用于实现音视频的录制与播放,底层采用AudioRecord和AudioTrack。创建PeerConnectionFactory时设置AudioDeviceModule即可。

DataChannel专门用于传输音视频流外的数据,如实时文字聊天、文件传输等。通过DataChannel.send()方法相互发送数据,onMessage()回调获取远端发送的数据。DataChannel的创建方式包括In-band与Out-of-band协商,后者在绑定ID一致时更为简便。

Android 视频硬件编码

本文将深入探讨 Android 平台上 WebRTC 如何利用 MediaCodec 对视频数据进行编码,并分析 webrtc native 与 java 之间的流程交互。

首先,diff修改源码我们将回顾 Android 的 MediaCodec 概念及其基本使用,然后深入源码进行详细分析。

MediaCodec 是 Android 提供的一个处理音频和视频数据的底层 API,支持编码和解码过程。自 Android 4.1(API )起引入,通常与 MediaExtractor、MediaSync、MediaMuxer、MediaCrypto、MediaDrm、Image、Surface 等一起使用。

在 WebRTC 中,VP8 编码器是优先使用的,因此要分析 Android 上硬件编码的流程,需要先支持 H 硬件编码。

MediaCodec 是 Android 中处理音视频编解码的关键组件。了解其基本概念和用法有助于构建高效、稳定的媒体应用程序。

在 WebRTC 中,如何使用硬件编码器?通过 DefaultVideoEncoderFactory 默认编码器,内部实现是使用硬件编码器。在 DefaultVideoEncoderFactory 中看到 createEncoder 函数,内部是实例化 HardwareVideoEncoder 的地方。

WebRTC 如何将数据送入编码器?WebRTC 使用 VideoEncoder 接口进行视频编码,红包人脉源码该接口定义了一个用于编码视频帧的方法:encode(VideoFrame frame, EncodeInfo info)。WebRTC 提供了一个名为 HardwareVideoEncoder 的类,该类实现了 VideoEncoder 接口,并使用 MediaCodec 对视频帧进行编码。

在 HardwareVideoEncoder 类中,WebRTC 将 VideoFrame 对象转换为与 MediaCodec 关联的 Surface 的纹理。这是通过使用 EglBase 类创建一个 EGL 环境,并使用该环境将 VideoFrame 的纹理绘制到 Surface 上来实现的。

WebRTC 如何获取编码后的数据?在 HardwareVideoEncoder 类中,使用 MediaCodec 同步模式获取编码后的数据。当数据可用时,会调用 callback.onEncodedFrame(encodedImage, new CodecSpecificInfo()); 方法,然后将编码后的帧传递给 WebRTC 引擎。

WebRTC 如何做码流控制?WebRTC 的码流控制包括拥塞控制和比特率自适应两个主要方面。当比特率发生变化时,WebRTC 会调用 VideoEncoder.setRateAllocation() 方法来通知更新比特率。

本文深入剖析了 WebRTC 在 Android 平台上如何使用 MediaCodec 对视频数据进行编码,以及整个编码过程中 webrtc native 与 java 的流程交互。希望本文能帮助读者更好地理解 WebRTC Android 编码技术。

[WebRTC 架构分析] Android 视频采集

在 Android 环境中,WebRTC 采用两种API版本处理视频采集,即camera1和camera2。自API 起,camera2成为主流,WebRTC对此进行了全面的封装。本文将重点剖析WebRTC对camera2的处理。

WebRTC对Camera2的抽象层次清晰,如上图所示,上半部分展示了WebRTC对Camera2的封装,下半部分则是Android SDK自带的Camera2类。在视频采集的初始化过程中,WebRTC通过Camera2Session类,通过一系列步骤操作,确保摄像头数据被渲染至SurfaceTexture对象,实现了标准化的流程。

采集完成的视频图像在WebRTC中,通过统一的VideoCapturer接口进行管理,各平台都有其特定的实现。在Android平台上,这一接口的应用使得开发者无需过多关注底层差异,只需专注于应用的核心逻辑设计。

WebRTC 实战: P2P 音视频通话解决方案

WebRTC 实战:P2P 音视频通话的全面指南

WebRTC 是一种强大的技术,能让你在浏览器和Android应用之间实现点对点(P2P)的音视频通话。本文将带你一步步构建这个解决方案,包括服务端信令处理和客户端的媒体流管理。

首先,通过Node.js和socket.io实现一个信令服务器。信令主要处理用户加入(join)、离开(leave)房间,以及交换SDP和ICE信令。服务端核心代码示例展示了如何设置和运行服务器。

为了提升P2P成功率,需要搭建stun/turn服务器。通过yum安装Coturn,配置并启动服务,确保候选者类型正确,通过trickle-ice测试验证。

客户端部分,WebRTC依赖ICE协议连接、SDP协商和加密传输。在浏览器端,利用getUserMedia获取媒体流,创建 PeerConnection对象并加入房间。在Android上,利用WebRTC库和Camera2获取媒体流,并进行相同的连接和协商步骤。

从创建offer到接收answer,每个环节都有关键代码示例,包括交换ICE候选,确保数据在nat和网络环境下正常传输。本文提供的只是简化示例,实际项目中可能需要根据需求进行扩展和优化。

通过以上步骤,你已经掌握了在JS与JS、Android与Android以及两者之间的P2P音视频通话实现。无论是在Web还是移动设备上,都可以构建出强大的实时通信系统。

总结来说,WebRTC实战让你具备构建P2P音视频通话系统的能力,包括服务端信令处理、客户端媒体处理等核心组件。继续关注后续内容,探索更多视频会议实现方案。

Ubuntu. 从头开始编译 Android Native WebRTC

本文详细记录Mac下使用PD虚拟机安装ubuntu.4桌面版,编译Android Native WebRTC的过程。

如果仅需使用WebRTC,官方提供的预编译包即可满足需求,无需手动编译:

通过Android Studio添加依赖:implementation 'org.webrtc:google-webrtc:1.0.+'

安装配置Ubuntu虚拟机,下载Ubuntu镜像,手动选择下载好的iso文件进行安装,设置用户名密码,指定虚拟机文件名和位置,等待安装完成。

安装Parallels Tools,解决无法直接安装的问题,创建安装文件后重启虚拟机,设置环境变量配置代理,使用主机sockes提供的http代理,虚拟机网络模式使用默认的共享网络。

下载WebRTC代码,安装必要软件,使用git clone命令下载源码,配置gclient代理,下载代码后通过gclient sync同步代码。

执行fetch命令下载源码和开发环境,设置gclient代理,使用gclient sync命令同步代码,下载和同步过程需要稳定网络环境。

使用GN和NINJA构建系统编译代码,执行gn gen和ninja命令构建所有目标和example app,生成apk文件和aar文件,完成编译打包过程。

在Android Studio中使用aar文件替换预编译依赖,按照推荐方法导入Android Studio代码,生成的gradle文件参考示例进行补全。

编译过程需要稳定网络环境,注意代码庞大复杂,整个构建系统采用了gn和ninja,确保编译成功并替换预编译依赖。

Android端向SRS服务器推送WebRTC流

实现Android端向SRS服务器推送WebRTC流的流程主要包括以下几个关键步骤:

首先,通过createPeerConnectionFactory创建PeerConnectionFactory对象。之后,使用createPeerConnection(addTransceiver)创建PeerConnection实例并添加媒体传输器。

接着,调用createOffer生成本地描述符,随后设置setLocalDescription(OFFER)将本地描述符发送给服务器。

获取远程描述符,即从服务器请求远程SIP(通常通过网络请求实现),确保网络请求采用安全的HTTPS形式,遵循Android P系统对非加密流量的限制。

基本配置应基于实际需求调整,并通过JSON格式在请求体中传递。

网络请求的URL通常为http://ip:port/rtc/v1/publish/或https://ip:port/rtc/v1/publish/,使用POST方法进行。

在获取远程描述符后,调用setRemoteDescription设置远程描述符,确保WebRTC流能够正确与服务器建立连接。

处理可能的错误响应,如HTTP状态码,通常意味着推流地址被占用或offer sdp中缺少有效的H. payload类型信息。解决方法可能包括更换推流地址或确保offer sdp包含H.相关信息。

检查Android端创建的offer sdp与从SRS服务器返回的answer sdp,如有必要进行相应的调整或修改。

最后,确保所有资源的正确释放,避免内存泄漏问题。

至此,实现Android端向SRS服务器推送WebRTC流的流程结束。