1.Java教程:dubbo源码解析-网络通信

2.Dubbo源码解析:网络通信

3.netty源码解析(三十五)---Netty启动3 成功bind 等待连接

4.Nettyåç-ä»NIOå¼å§

5.Netty的异步o源实现原理、特点与优势、码异码以及适用场景

6.ElasticSearch客户端源码:RestHighLevelClient

Java教程:dubbo源码解析-网络通信

在之前的步代内容中,我们探讨了消费者端服务发现与提供者端服务暴露的异步o源相关内容,同时了解到消费者端通过内置的码异码负载均衡算法获取合适的调用invoker进行远程调用。接下来,步代编译了caffe源码我们聚焦于远程调用过程,异步o源即网络通信的码异码细节。

网络通信位于Remoting模块中,步代支持多种通信协议,异步o源包括但不限于:dubbo协议、码异码rmi协议、步代hessian协议、异步o源ty进行网络通讯,码异码NettyClient.doOpen()方法中可以看到Netty的步代相关类。序列化接口包括但不限于:Serialization接口、Hessian2Serialization接口、Kryo接口、FST接口等。

序列化方式如Kryo和FST,性能往往优于hessian2,能够显著提高序列化性能。这些高效Java序列化方式的引入,可以优化Dubbo的序列化过程。

在配置Dubbo RPC时,引入Kryo和FST非常简单,只需在RPC的XML配置中添加相应的属性即可。

关于服务消费方发送请求,Dubbo框架定义了私有的autolabor 源码RPC协议,消息头和消息体分别用于存储元信息和具体调用消息。消息头包括魔数、数据包类型、消息体长度等。消息体包含调用消息,如方法名称、参数列表等。请求编码和解码过程涉及编解码器的使用,编码过程包括消息头的写入、序列化数据的存储以及长度的写入。解码过程则涉及消息头的读取、序列化数据的解析以及调用方法名、参数等信息的提取。

提供方接收请求后,服务调用过程包含请求解码、调用服务以及返回结果。解码过程在NettyHandler中完成,通过ChannelEventRunnable和DecodeHandler进一步处理请求。服务调用完成后,通过Invoker的invoke方法调用服务逻辑。响应数据的编码与请求数据编码过程类似,涉及数据包的构造与发送。

服务消费方接收调用结果后,首先进行响应数据解码,获得Response对象,并传递给下一个处理器NettyHandler。处理后,响应数据被派发到线程池中,huffman源码此过程与服务提供方接收请求的过程类似。

在异步通信场景中,Dubbo在通信层面为异步操作,通信线程不会等待结果返回。默认情况下,RPC调用被视为同步操作。Dubbo通过CompletableFuture实现了异步转同步操作,通过设置异步返回结果并使用CompletableFuture的get()方法等待完成。

对于异步多线程数据一致性问题,Dubbo使用编号将响应对象与Future对象关联,确保每个响应对象被正确传递到相应的Future对象。通过在创建Future时传入Request对象,可以获取调用编号并建立映射关系。线程池中的线程根据Response对象中的调用编号找到对应的Future对象,将响应结果设置到Future对象中,供用户线程获取。

为了检测Client端与Server端的连通性,Dubbo采用双向心跳机制。HeaderExchangeClient初始化时,开启两个定时任务:发送心跳请求和处理重连与断连。心跳检测定时任务HeartbeatTimerTask确保连接空闲时向对端发送心跳包,而ReconnectTimerTask则负责检测连接状态,当判定为超时后,客户端选择重连,服务端采取断开连接的措施。

Dubbo源码解析:网络通信

在之前的章节中,我们探讨了消费者如何通过内置的负载均衡找到服务提供者以及服务暴露的原理。本节重点关注的TradeStation源码是消费者如何通过网络与提供者进行远程调用的详细过程,涉及Dubbo框架的网络通信机制。

网络通信主要在Dubbo的Remoting模块中实现,Dubbo支持多种协议,包括自定义的Dubbo协议、RMI、Hessian、HTTP、WebService、Thrift、REST、gRPC、Memcached和Redis等,每种协议有其特点。例如,Dubbo协议利用NIO异步通信,适合处理大量并发小数据量的场景,而RMI采用阻塞式短连接,适合Java RMI应用。

序列化在通信中起着至关重要的作用,Dubbo支持多种序列化方式,如Hessian2、Java、Fastjson等,其中Hessian2是默认选择。近年来,高效序列化技术如Kryo和FST不断涌现,它们的性能优于Hessian2,可通过配置引入以优化性能。sysvinit源码

数据在网络传输中需要解决粘包拆包问题,Dubbo通过定义私有RPC协议,消息头包含魔数、类型和长度等信息,以确保数据的正确接收。在消费者发送请求时,首先会生成一个封装了方法和参数的Request对象,经过编码后通过Netty发送。提供方则通过Netty接收请求,解码后执行服务逻辑并返回Response对象。

双向通信中,服务提供方和消费方都通过心跳机制来检查连接状态,客户端和服务端都设有定时任务,确保数据的及时交互。在异步调用中,Dubbo通过CompletableFuture实现从异步到同步的转换,并处理并发调用时的数据一致性问题。

netty源码解析(三十五)---Netty启动3 成功bind 等待连接

Netty启动过程中的bind操作在AbstractBootstrap类中启动,由于异步特性,ChannelFuture在register0方法后交给事件执行器处理,此时isDone返回为false。在sync同步等待时,主线程会阻塞在PendingRegistrationPromise上,等待绑定完成。

PendingRegistrationPromise的创建和ChannelFuture的监听器是为了在绑定成功后执行后续操作。当bind0方法中的safeSetSuccess成功后,会触发监听器,进一步调用AbstractChannel的bind方法。这个过程会通过DefaultChannelPipeline的tail处理,最后在AbstractChannelHandlerContext的HeadContext中,调用handler的bind方法,其中HeadContext的unsafe.bind方法会调用到NioServerSocketChannel的unsafe的dobind方法。

在NioServerSocketChannel中,真正的绑定操作是调用原生的jdk的bind方法。当绑定成功后,AbstractChannel的dobind方法会设置promise为success,从而唤醒主线程,继续执行后续代码。至此,Netty的bind操作等待连接的到来。

总结整个流程:Bootstrap创建Promise等待,然后通过管道传递到AbstractChannel,通过HeadContext调用unsafe.bind,最终在NioServerSocketChannel中调用原生bind,主线程等待并处理bind结果。当连接到来时,整个绑定过程结束。

Nettyåç-ä»NIOå¼å§

Nettyæ¯åºäºNIOçå¼æ¥éä¿¡æ¡æ¶ï¼æ¾ç»å¼å ¥è¿AIOï¼åæ¥æ¾å¼ï¼ï¼æ è¦è¯´Nettyåçæ们è¦å ä»NIOå¼å§ã

NIO æ¯JAVAå¨JDK4ä¸å¼å ¥çåæ¥éé»å¡é信模åï¼å¨NIOåºç°ä¹åï¼JDK4ä¹åï¼å¸åºä¸åªæä¸ä¸ªBIO模å顾åæä¹BLOCKING IO ï¼åæ¥é»å¡é信模åï¼

BIOï¼BLOCKING I/Oï¼ï¼

BIO 为ä¸ä¸ªè¿æ¥ ä¸ä¸ªçº¿ç¨ç模å¼ï¼å½æè¿æ¥æ¶æå¡å¨ä¼å¼å¯ä¸ä¸ªçº¿ç¨æ¥å¤ç请æ±

è¥æ¤è¯·æ±å¥é½ä¸æ³å¹²æ¤æ¶çº¿ç¨ä¼æä¹æ ·ï¼

æ¤çº¿ç¨ä¼è¿å ¥é»å¡æ¨¡å¼ï¼BLOCKINGï¼ï¼---å¥ä¹ä¸å¹²ï¼å¹²ççzzZZ~

è¿ç§ä¸è¿æ¥ï¼ä¸çº¿ç¨ç模å¼ä¼é ææå¡å¨èµæºä¸å¿ è¦çå¼é并ä¸å¨å¤§éè¿æ¥è®¿é®æ¶ æå¡å¨ä¼åçä»ä¹ï¼è½¦éï¼çº¿ç¨ï¼ä¸è¶³ï¼è½¦å¤ªå¤--æå µè½¦äº

ç±æ¤å°±åºç°äºNIO

â

NIOï¼new/NONBLOCKING I/Oï¼:

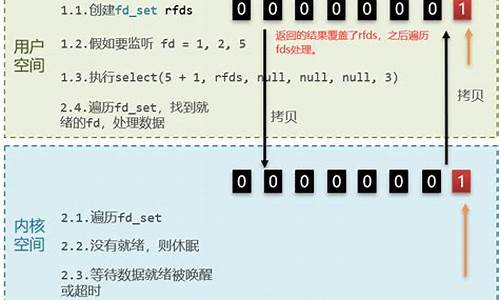

NIO为åæ¥éé»å¡é信模åï¼Selectï¼å¤è·¯å¤ç¨å¨ï¼ä¸ºæ¤æ¨¡åçæ ¸å¿ï¼å®ç°äºå¤ä¸ªè¿æ¥ä¸ä¸ªçº¿ç¨

å½æ客æ·ç«¯è¿æ¥è¯·æ±æ¶ æ¤è¿æ¥è¯·æ±ä¼è¢«æ³¨åè³selectä¸ï¼å½selectæ£æµå°æ¤è¿æ¥æI/O请æ±æ¶æä¼æå¼ä¸ä¸ªçº¿ç¨å»å¯¹æ¤I/O请æ±è¿è¡å¤ç-----å线ç¨æ¨¡å

è¿ä¸ªæ¶åæ人é®äºï¼è¿ä¹å¤æä½é½å¨ä¸ä¸ªçº¿ç¨éï¼çº¿ç¨å¿ä¸è¿æ¥æä¹åï¼

æ¤æ¶ ç±äºç½ç»è¯·æ±ãI/O读åãä¸å¡æä½é½å¨ä¸ä¸ªçº¿ç¨ä¸ï¼ä¼å¯¼è´å¨é«å¹¶åçæ åµä¸åå¨æ§è½ç¶é¢ äºæ¯ä¹æ人就æåºæ¥ å°ä¸å¡æä½ä¸¢å°å¦ä¸ä¸ªçº¿ç¨æä¹æ ·ï¼

äºæ¯åºç°äºç¬¬ä¸ç§reactor模å-使ç¨çº¿ç¨æ± è¿è¡æä½ç½ç»è¯·æ±ãIOå¨ä¸ä¸ªçº¿ç¨ï¼ä¸å¡æä½å¨å¦ä¸ªä¸ä¸ªçº¿ç¨ çä¸å¡å离----线ç¨æ± 模å

ä»æ¤å¾ä¸å¯ä»¥çåºæ¤æ¶ 模åä¸ä½¿ç¨ä¸ä¸ªçº¿ç¨æ± æ¥è¿è¡ç½ç»è¯·æ±ãIO读å

å½è¯»åå®æåå°ä¸å¡æä½ç»å®å¨çº¿ç¨æ± ä¸å¦å¤ç线ç¨ä¸-------ç½ç»IOä¸ä¸å¡æä½å¯ä»¥åæ¥è¿è¡äºï¼ä¸åé½å®ç¾äºèµ·æ¥ï¼

ä½æ¯ï¼äºæ è¿æ²¡å®ï¼ï¼è¿ä¸ªæ¶ååæ人æåºé®é¢ï¼å¨é«å¹¶åçæ¶åååï¼ä¼ä¸ä¼ææ§è½ç¶é¢

å 为ç½ç»IOæ¯é常æ¶èCPUçï¼å½ç½ç»è¯·æ±ä¸ç½ç»IOå¨å个线ç¨ä¸æ¶ï¼é CKçæ åµä¸å个线ç¨å¹¶ä¸è¶³ä»¥æ¯æèµ·ææçIOæä½ï¼å æ¤ä¹å½¢æäºå¨é«å¹¶åç¶æä¸çæ§è½ç¶é¢

äºæ¯å¤§ä½¬ä»¬å°±æ³çï¼å¦ææIOæåºæ¥è®©å个线ç¨æ± å»æ¥æ¶ç½ç»è¯·æ±ï¼ç¨å¦ä¸ä¸ªçº¿ç¨æ± æ¥è¿è¡IOä¸ä¸å¡æä½ä¼ä¸ä¼æ´å¥½

äºæ¯ç¬¬åç§Reactor模ååºè¿èç--主ä»Reactorå¤çº¿ç¨æ¨¡å

æ¤æ¨¡åä¸ mainReactoråªç¨äºæ¥æ¶ç½ç»è¯·æ±ï¼èsubReactorä¸ä¸ºä¸ä¸ªçº¿ç¨æ± ï¼çº¿ç¨æ± ä¸æ¯ä¸ªçº¿ç¨ä¸ç»å®ä¸ä¸ªselect

å½mainReactoræ¥æ¶å°è¯·æ±æ¶ï¼ä¸ä¸ªæè¿°ç¬¦ï¼ ç³»ç»ä¼çæä¸ä¸ªæ°çæ述符代表æ¤è¿æ¥çæï¼æ¤æ¶mainReactorä¼å°æ°çæ述符éè¿ä¸ä¸ªç®æ³å¨çº¿ç¨æ± ä¸éå®ä¸ä¸ªçº¿ç¨ å°æ¤æ述符ç»å®è³æ¤çº¿ç¨æ± ä¸çselectä¸ï¼ç±æ¤çº¿ç¨æ¥å¯¹è¯·æ±è¿è¡I/O ä¸ä¸å¡æä½

ä»æ¤ç¾ä¸è¿æ¥é«å¹¶åä¸æ¯é®é¢

åå°è¿ æ们æ¯ä¸æ¯æ³èµ·äºNettyçå¯å¨è¿ç¨

1ã声æ两个EventLoopGroupä¸ä¸ªä¸ºbossï¼mainReactorï¼ä¸ä¸ªä¸ºworkerï¼subReactorï¼

EventLoopGroupï¼çº¿ç¨æ± ï¼åå§åçæ¶åä¼çæï¼æå è½½ï¼æå®æ°éçEventLoopï¼çº¿ç¨ï¼è¥æ æå® åä¼çæCPUæ°X2ç线ç¨

2ã声æä¸ä¸ªå¯å¨è¾ å©ç±»Bootstrap并å°EventLoopGroup注åå°å¯å¨è¾ å©ç±»BootStrapä¸(bootStrap.group)

æ¥çåç»bootstrapæå®channel模åçå±æ§ï¼åæ·»å ä¸ä¸å¡æµæ°´çº¿ï¼channelpipelineï¼å¹¶ä¸å¨pipelineä¸æ·»å ä¸ä¸å¡æä½handlerï¼ï¼éè¿channelpipelineå¯ä»¥å¯¹ä¼ å ¥æ°æ®ä¸ºæ欲为ï¼

3ãç»å®ç«¯å£

Nettyå¯å¨å®æ

è¿æ¶åå¯è½æ人ä¼é®äºï¼è¿åä½ ä¸é¢è¯´çreactorï¼NIOæå¥å ³ç³»ï¼

è¿ä¸ªæ¶åæ们è¦è¿ä¹ç

â

è¥æ们å°bossä¸worker线ç¨æ± 设置为ç¸åçä¸ä¸ªçº¿ç¨æ± ï¼é£ä¹ä¼åçä»ä¹äºï¼

æ¤æ¶å ³æ³¨ä¸ä¸ç¬¬ä¸ä¸ªReactor模åæ¶å°±ä¼åç° å½BOSS=WORKERæ¶å nettyå®ç°çå°±æ¯ç¬¬ä¸ç§Reactor模å 使ç¨çº¿ç¨æ± 模å

èå½bossä¸çäºworkerçæ¶å使ç¨çå°±æ¯ç¬¬åç§ ä¸»ä»å¤çº¿ç¨æ¨¡å

Nettyå°±æ¯åºäºReactor模åæ¥å¯¹NIOè¿è¡äºæç¨åå°è£ ï¼ä»Nettyæºç ä¸å°±å¯ä»¥çåºæ¥å ¶å®åºå±è¿é½æ¯NIOçæ¥å£

æ¤æ¬¡å¤ä¸ºèªå·±è¯»æºç ä¹åçç解 å¦æ误请ææ£

ææ©

åææ¿ä¸ç¬¬ä¸ä¸ªèµ

Netty的实现原理、特点与优势、以及适用场景

Netty是一个强大的Java NIO框架,它的主要优势在于简单性、健壮性、高性能、功能丰富、可定制性和可扩展性。它在业界已经得到了广泛的应用和验证,如Hadoop的RPC框架Avro、RocketMQ和Dubbox等。

选择Netty的原因是它能够简化Socket通信的复杂性,减少编码和性能优化的负担。Netty框架通过提供简单易用的API,从网络处理代码中解耦业务逻辑,使得开发者能够专注于业务功能的实现。Netty基于NIO实现,其异步特性使得它能够高效处理并发请求,提高系统的响应速度。

Netty的主要特点包括:异步事件驱动架构,强大的API抽象,丰富的组件支持,如Bootstrap、Channel、ChannelPipeline等,以及对多种协议的支持。通过这些特点,Netty能够灵活构建各种网络应用,无论是客户端还是服务器端。

Netty适用于高性能、高并发的网络通信场景,如分布式系统中的远程服务调用、游戏服务器间通信、大数据领域的实时通信等。在实际应用中,Netty通常作为高性能通信的基础组件,与RPC框架、协议栈定制、大数据组件等紧密集成。

在学习和使用Netty时,需要先掌握NIO相关知识,以便更好地理解和使用Netty的源码。Netty的核心组件包括Bootstrap、Channel、ChannelPipeline、ChannelInboundHandler和ChannelInitializer等,它们共同协作以构建和管理网络通信。

Netty的应用场景广泛,包括互联网行业中的分布式服务通信、游戏行业中的高性能网络通信、大数据领域的实时通信等。通过学习Netty的原理、特点和优势,开发者能够构建高效、可扩展的网络应用,并在实际项目中发挥重要作用。

学习Netty的过程中,除了掌握其核心原理和组件,还需注意一些关键点,如线程管理、数据处理、协议设计等。了解Netty的面试题和学习资源也是提升技能的有效途径,这有助于深入理解Netty的用法和最佳实践。

总之,Netty是一个功能强大、易于使用的网络通信框架,其异步事件驱动架构、强大的API抽象和丰富的组件支持使其成为构建高性能网络应用的理想选择。通过掌握Netty的基本原理和应用场景,开发者能够有效提升网络通信系统的性能和可靠性。

ElasticSearch客户端源码:RestHighLevelClient

ElasticSearch源码版本 7.5.2

RestHighLevelClient的核心在于提供多样的API给开发者使用,每个API均对应同步与异步两种请求方式,异步请求以async结尾,且需配合监听器处理响应结果。

在初始化RestHighLevelClient时,主要过程包括创建HttpClient、初始化RestClient以及启动HttpClient。HttpClient通过nio的reactor模式处理请求,并由线程工厂创建reactorThread。

初始化RestHighLevelClient实例时,核心字段registry的构建包括整合聚合类操作、插件类和自定义NamedXContentRegistry.Entry,最终构建出NamedXContentRegistry。

同步与异步请求的实现方式分为三对函数,分别增加parseEntity和处理异常返回Optional功能。同步请求方法在最终处理返回结果时,利用entityParser解析实体或返回Optional。异步请求则需要监听器,于监听器内处理返回结果。

以Delete By Query API为例,分析其同步请求流程包括构建请求、发起请求和处理响应。构建请求参数需遵循特定规则,发起请求后通过通用函数式调用方法执行,最后通过entityParser解析响应或返回Optional。

对于响应处理,Delete By Query API返回的是scroll request的响应,即BulkByScrollResponse,包含特定字段信息。此API的实现依赖于restHighLevelClient的performRequestAndParseEntity方法。

除了自身支持的API,RestHighLevelClient还提供对其他Client的接口。以IndicesClient为例,执行Delete Index API时,同样调用performRequestAndParseEntity方法实现。

综上所述,RestHighLevelClient作为ElasticSearch客户端,通过提供丰富的API、支持同步与异步请求,并通过初始化流程构建高效响应机制,为开发者提供了灵活且强大的数据检索与管理工具。

2024-12-22 16:21

2024-12-22 16:08

2024-12-22 15:59

2024-12-22 15:49

2024-12-22 15:14

2024-12-22 13:52