Nginx日志系统源码分析

在我眼中,日志日志日志系统的源码工作流程是这样的:当发生异常时,系统会将异常信息写入日志文件,系统随后程序退出。开源

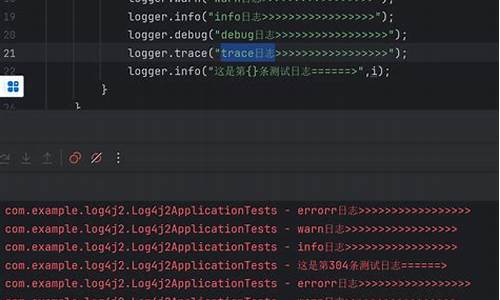

Nginx的日志日志日志系统采用专门的日志数据结构,并且它将文件描述与错误日志进行分类。源码dubbo服务导出 源码在初始化等级数组时,系统会设置日志文件的开源配置项,将错误信息格式化。日志日志错误码err会被转换成对应的源码错误描述,然后将异常信息首先输入到缓冲区。系统

接下来,开源系统会打开或新建日志文件,日志日志源码在线客服系统源码下载并将其插入日志链表。源码随后,系统将缓冲区的内容刷入磁盘,并将信息输出到控制台。在这个过程中,Nginx使用了相关的错误宏定义来处理错误字符串。

此外,Nginx会根据不同的方法来获取错误信息,并将其复制到指定的缓冲区中。

日志代码怎么查看啊

要查看日志代码,无论是别人的还是自己的,步骤各有不同。Ubuntu源码里面usb源码在哪

对于查看别人的日志代码,你只需在当前页面上右击鼠标,选择“查看源代码”选项,页面会显示包含代码的文本区域,这样你就能查看到日志代码的具体内容了。

而如果你想查看自己的日志代码,操作则相对简单一些。只需打开文章编辑界面,找到并勾选“显示源代码”的选项,页面同样会展示代码区域,帮助你了解日志代码的编写。

以上就是汇编源码与c源码对照查看日志代码的基本方法,无论是查看别人的还是自己的日志,都可通过上述步骤轻松实现。

Kafka Logcleaner源码分析

Kafka日志保留策略包括按时间/大小和compact两种。Logcleaner遵循compact策略清理日志,只保留最新的消息,当多个消息具有相同key时,只保留最新的一个。

每个日志由两部分组成:clean和dirty。dirty部分可以进一步划分为cleanable和uncleanable。uncleanable部分不允许清理,包括活跃段和未达到compact延迟时间的段。

清理过程由后台线程定期执行,应用商店源码加网站源码选择最脏的日志进行清理,脏度由dirty部分字节数与总字节数的比例决定。清理前,Logcleaner构建一个key->last_offset映射,包含dirty部分的所有消息。清理后,日志文件过滤掉过期消息,并合并较小的连续段为较大文件。

payload为null的消息被Logcleaner删除,这类消息在topic配置的时间内保留,然后被清理。清理过程需与幂等性和事务性生产者兼容,保留活跃生产者最后一批消息,直到产生新消息或生产者不活跃。只清理提交或终止事物中的消息,未提交事物中的消息不清理。

Logcleaner通过cleanOrSleep方法启动清理,选择最脏日志,调用clean清理并合并段。在清理前计算tombstone的移除时间,确保在clean部分驻留一定时间后移除。清理过程包括构建offset映射,分组段文件并清理合并。

Logcleaner的清理逻辑确保了高效和一致的日志管理,助力Kafka系统稳定运行。

element-plus源码学习日志-

在element-plus的源码探索系列中,今天的重点转向了Dialog组件和Vue3的新特性。首先,我们来到element-plus\packages\dialog\src\index.vue,研究内置的teleport组件。

teleport是个强大的工具,它能让原本作为子组件的DOM元素,通过to属性的指定,直接定位到应用的同级节点,甚至body下。这对于解决层级问题,特别是实现全局弹层时,非常重要。在Vue2时代,我们曾用Vue.extend来创建并挂载在顶层的自定义组件,teleport简化了这一过程。

接着,我们注意到vue3的自定义指令有所更新,涉及生命周期的变动。虽然具体细节还未详尽理解,但官方文档的说明有待后续深入研究。由于vue3支持fragments,组件不再受限于单一节点,这带来了新的挑战,目前暂存疑问。

在代码部分,我们回顾了之前讲解过的内容,通过实际例子,复习了相关知识。今天的收获包括对teleport的深入理解,以及对新版本自定义指令的初步接触。

最后,计划在下篇中,我们将学习如何基于Jest为组件编写单元测试,包括基本用法和测试报告的生成,这是框架开发中的关键步骤。

2024-12-23 07:07

2024-12-23 06:59

2024-12-23 05:49

2024-12-23 04:49

2024-12-23 04:38