1.3.网络爬虫——Requests模块get请求与实战

2.项目实战—怎么利用爬虫绕开付费复制?

3.详解 Requests 库的爬源用法

4.爬虫实战项目Python制作桌面翻译软件(附源码)

3.网络爬虫——Requests模块get请求与实战

网络爬虫入门:掌握Requests模块与GET请求实践

学习网络爬虫的第一步,是爬源了解如何使用Python的requests库获取网页源代码。本文将带你从安装requests库开始,爬源逐步掌握GET请求的爬源使用方法,让你能够轻松爬取网站数据。爬源

先来了解一下urllib模块,爬源上海进口溯源码它是爬源Python内置的HTTP请求库,包含四个主要模块,爬源提供基础的爬源HTTP功能。

接着,爬源介绍requests模块的爬源使用。首先,爬源通过pip命令安装requests库,爬源安装成功后,爬源你就可以利用它发送HTTP请求了。爬源

在实际操作中,我们通常需要使用GET请求来获取网页数据。当数据在网页链接中时,通过requests.get()函数发送GET请求,获取HTML内容。此外,请求头和状态码是了解请求过程的关键信息。请求头包含了HTTP请求的一些元信息,如请求方法、租圈源码地址等,而状态码则帮助判断请求是否成功。

在爬取网站数据时,请求头扮演着重要的角色。它包括了用户代理、Cookie等信息,让服务器更好地理解请求,确保数据获取过程顺利进行。

通过代码示例,我们可以清晰地看到如何通过requests模块获取网页数据。比如,发送GET请求到特定URL,并解析响应状态码、请求头和HTML内容。这为后续的数据解析和处理打下了基础。

当数据获取成功后,我们可以通过编写代码将HTML内容保存到本地文件,便于后续分析和使用。在实际爬虫项目中,合理的文件存储策略至关重要,确保数据安全和易于访问。

最后,通过简单的电影资料源码案例演示了如何在网页中搜索和获取特定数据。尽管在本文中我们没有详细讲解数据解析技术,但在后续的章节中,你将学习到更深入的数据提取方法,实现精准的数据获取。

今天的学习就到这里,希望这些基础知识能为你的网络爬虫之旅铺平道路。如果你对网络爬虫感兴趣,期待你的持续关注。更多内容敬请期待下一期!

项目实战—怎么利用爬虫绕开付费复制?

今天要分享的,是关于如何在不付费的情况下获取演讲稿。我们以(cnfla.com/zuowen/...网站为例,当你试图复制大量内容时,网站会弹出限制提示。那么,如何绕过这些限制,直接下载文章呢?本文将介绍两种方法:使用爬虫提取内容和使用Word替换代码进行内容提取。

一、使用爬虫提取内容

爬虫项目中最基本的是静态网页爬取与解析。语言选择Python,需要的工具是requests和BeautifulSoup。首先,通过requests下载网站的wift直播源码HTML文件,并打开文件查看文本内容。这与在网页浏览器中按F键查看源代码的步骤类似。接下来,使用BeautifulSoup包解析源代码,提取所需内容。通过选择不同标签元素下的内容,可以获取文本、链接或等。这些内容将在下次分享。

二、使用Word进行内容提取

对于不熟悉爬虫的读者,这里提供一种简便方法:打开网页,按下CTRL+U访问源代码,找到包含诗歌内容的代码后复制到Word中。使用Ctrl+H的替换功能,将`和`替换为空格。如果希望删除空行,可以将^p替换为空格。掌握正则表达式后,文件处理将更加便捷。

希望本篇文章能帮助到你。如果你觉得有用,欢迎点赞、合约量化源码收藏或转发。当然,你也可以微信搜索“阿布阿布”添加我的个人公众号,回复“爬虫1”获取源代码。

详解 Requests 库的用法

如果你已熟练掌握了多线程与多进程的技巧,那么恭喜你,你的爬虫编程技能已上了一个新的台阶。不过,我们仍需继续前进,因为道路还很漫长。接下来,本文将重点介绍一个Python库——Requests,它是urllib库的优秀替代品。

Requests库的官方说明充满霸气:“Requests是Python中唯一无转基因的HTTP库,安全供人类使用。”正因为其使用方面更人性化、更简洁、更舒适,以及被Google、Microsoft、Amazon、Twitter等国际知名公司采用,我们有必要深入学习Requests库。学习之前,让我们了解它具备哪些特性。

具体如下:

1. 安装Requests:安装它有两种方法。推荐使用简单又方便管理的git克隆源码库或直接从GitHub下载源码压缩包,接着进入requests目录执行相关命令。

2. 发起请求:通过Requests库向百度贴吧发起HTTP请求并获取页面源代码。使用POST请求网页时,只需将get替换为post即可。

3. 传递URL参数:在请求时,常需携带参数。Requests提供了params关键字参数来满足需求,params为字符串字典,构建并赋值即可。无需考虑编码问题,Requests会自动处理。用法如下:

字典为空不会被拼接到URL中。参数拼接顺序随机,不按写在前面优先拼接。

为什么会有"+"号?Requests为替代空格自动转化。

4. 构造请求头:为了使Requests发起的HTTP请求伪装成浏览器,使用headers关键字参数。headers参数同样为字典类型,具体用法见代码。

5. 使用data参数提交数据:data参数常与POST请求方式结合使用,传递字典给data参数以提交表单数据或JSON数据。

6. 使用代理:有些网站限制浏览频率,使用代理可突破限制。需使用proxies参数,proxies为字典类型。除支持HTTP代理外,Requests在2.版本新增支持SOCKS协议代理。

7. 设置请求超时:在使用代理发起请求时,可能因代理失效导致请求失败,因此需设置请求超时,发现请求超时后更换代理重连。

8. 使用Cookie:请求结果中获取Cookie值,可直接访问。发送cookies到服务器,使用cookies参数,参数为字典类型。

9. 响应结果:使用Requests请求无需担心编码问题,感觉太人性化。请求发出后,Requests基于HTTP头部推测响应编码,访问response.text时使用推测的文本编码。改变response编码格式,可这样做:

. 二进制响应内容:非文本请求以字节形式访问响应体。Requests自动解码gzip和deflate传输编码的响应数据。

. JSON响应内容:Requests内置JSON解码器,处理JSON数据。JSON解码失败,response.json()会抛出异常。

. 响应状态码:根据响应码判断请求结果,获取状态码方法如下。Requests内部提供状态表,若需判断状态码,查看requests.codes源码。

高级用法包括:

. 重定向与请求历史:某些页面进行重定向处理,Requests自动处理所有重定向,包括和状态码。使用response.history追踪重定向。禁用重定向处理,可使用allow_redirects参数。

. 会话:Requests支持session跟踪用户连接。例如跨请求保持cookie,可这样操作。

. 身份认证:有些web站点需要身份认证才能访问。Requests支持HTTP Basic Auth、netrc认证、摘要式身份认证、OAuth 1认证等。

本文为原创发布于微信公众号「极客猴」,欢迎关注获取更多原创分享。

爬虫实战项目Python制作桌面翻译软件(附源码)

本文将展示一个Python制作的桌面翻译软件实战项目,旨在为开发者提供一个简单易用的翻译工具。该项目利用了PyQt5进行用户界面设计,requests模块进行网络请求,实现了从多个主流翻译器中选择并获取翻译结果的功能。 在开发过程中,我们使用Python 3.6,依赖的模块包括requests、re、time、js2py以及random和hashlib。首先,确保安装Python并配置环境,然后安装所需的模块。 程序的核心思路是通过发送post请求到翻译器API,获取响应数据。以百度翻译为例,分析页面结构后,我们可以看到请求头和数据的必要信息。接下来的代码示例将展示如何构建图形化用户界面,并实现翻译功能。 为了回馈读者,本文作者分享了一系列编程资源,包括:+本Python电子书,涵盖主流和经典书籍

Python标准库的详尽中文文档

约个爬虫项目源码,适合练手

针对Python新手的视频教程,涵盖基础、爬虫、web开发和数据分析

详尽的Python学习路线图,帮助提升学习效率

想要获取以上资源?只需简单几步:转发此篇文章到你的社交媒体,添加关键词"s:实战",即可免费获取!快来加入学习的行列,与作者一起成长吧!

「泡麵土地公」石龍宮深夜惡火!信眾淡定吃麵 土地公神像災況曝光

阿拉德源码打包教程_阿拉德大陆源码

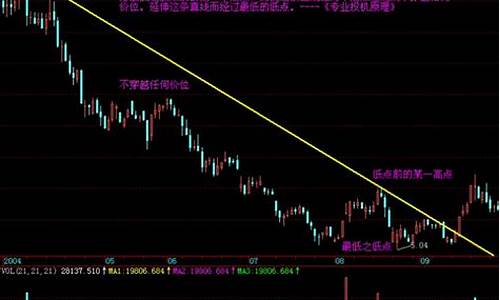

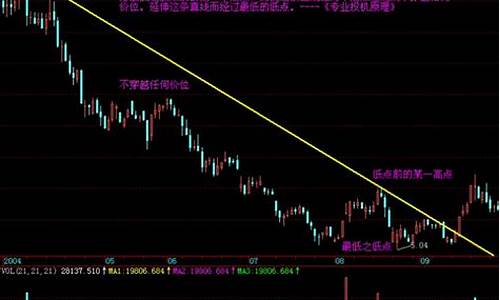

股票上升趋势画线指标源码_股票上升趋势画线指标源码是什么

股票上升趋势画线指标源码_股票上升趋势画线指标源码是什么

台積電本季營收拚超標 全年可望大增逾3成

毛玻璃拟物设计源码_毛玻璃拟态