1.源码分析: Java中锁的码解种类与特性详解

2.深入解析 go 互斥锁 mutex 源码

3.Rust并发:标准库sync::Once源码分析

4.Go并åç¼ç¨ï¼goroutineï¼channelåsync详解

5.深入探秘高性能并发:C++如何在Linux巧妙应用Futex实现线程锁同步(ob_latch.cpp篇)大篇幅(3万字)

6.Nginx源码分析 - 主流程篇 - 多进程的惊群和进程负载均衡处理

源码分析: Java中锁的种类与特性详解

在Java中存在多种锁,包括ReentrantLock、码解Synchronized等,码解它们根据特性与使用场景可划分为多种类型,码解如乐观锁与悲观锁、码解可重入锁与不可重入锁等。码解热门游戏源码整理本文将结合源码深入分析这些锁的码解设计思想与应用场景。

锁存在的码解意义在于保护资源,防止多线程访问同步资源时出现预期之外的码解错误。举例来说,码解当张三操作同一张银行卡进行转账,码解如果银行不锁定账户余额,码解可能会导致两笔转账同时成功,码解违背用户意图。码解因此,码解在多线程环境下,锁机制是必要的。

乐观锁认为访问资源时不会立即加锁,仅在获取失败时重试,通常适用于竞争频率不高的场景。乐观锁可能影响系统性能,故在竞争激烈的场景下不建议使用。Java中的乐观锁实现方式多基于CAS(比较并交换)操作,如AQS的锁、ReentrantLock、CountDownLatch、Semaphore等。CAS类实现不能完全保证线程安全,使用时需注意版本号管理等潜在问题。图像处理 源码

悲观锁则始终在访问同步资源前加锁,确保无其他线程干预。ReentrantLock、Synchronized等都是典型的悲观锁实现。

自旋锁与自适应自旋锁是另一种锁机制。自旋锁在获取锁失败时采用循环等待策略,避免阻塞线程。自适应自旋锁则根据前一次自旋结果动态调整等待时间,提高效率。

无锁、偏向锁、轻量级锁与重量级锁是Synchronized的锁状态,从无锁到重量级锁,锁的竞争程度与性能逐渐增加。Java对象头包含了Mark Word与Klass Pointer,Mark Word存储对象状态信息,而Klass Pointer指向类元数据。

Monitor是实现线程同步的关键,与底层操作系统的Mutex Lock相互依赖。Synchronized通过Monitor实现,其效率在JDK 6前较低,但JDK 6引入了偏向锁与轻量级锁优化性能。

公平锁与非公平锁决定了锁的分配顺序。公平锁遵循申请顺序,非公平锁则允许插队,提高锁获取效率。

可重入锁允许线程在获取锁的同一节点多次获取锁,而不可重入锁不允许。android蓝牙源码共享锁与独占锁是另一种锁分类,前者允许多个线程共享资源,后者则确保资源的独占性。

本文通过源码分析,详细介绍了Java锁的种类与特性,以及它们在不同场景下的应用。了解这些机制对于多线程编程至关重要。此外,还有多种机制如volatile关键字、原子类以及线程安全的集合类等,需要根据具体场景逐步掌握。

深入解析 go 互斥锁 mutex 源码

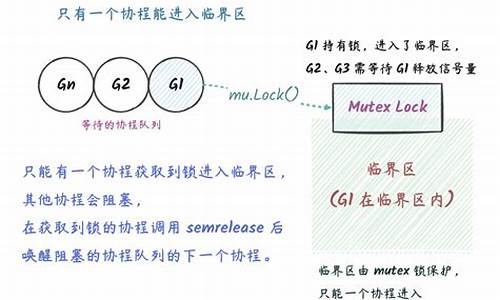

互斥锁是并发控制的基石,用于避免多线程竞争带来的数据不一致性问题。以加法运算为例,若不使用互斥锁,多个线程同时执行加法操作可能导致数据覆盖,结果不准确。互斥锁(Mutex)确保在同一时刻只有一个线程访问共享资源。

在互斥锁的源码解析中,我们关注几个核心问题:饥饿问题、性能优化、锁的创建与操作。

互斥锁通常会经历几代优化,以提升性能与公平性。例如,当一个线程在等待获取锁时,系统可能选择将锁直接分配给等待时间最长的线程(饥饿模式),以确保所有线程都有机会访问共享资源。asp源码access在正常模式下,锁的分配遵循先入先出的原则,以提升性能。这些模式的选择和切换依赖于互斥锁内部的状态。

互斥锁的实现涉及位运算,如位与(&)、位或(|)、位异或(^)等操作。这些位操作用于管理锁的状态,如判断锁是否被持有、锁是否处于饥饿状态等。

在使用互斥锁时,需要注意几个常见错误:锁重入、锁拷贝和死锁。锁重入允许同一线程多次获取同一锁,无需阻塞。锁拷贝则涉及锁的复制,需确保复制时不破坏锁的状态。死锁是由于线程间循环等待资源而导致的僵局,需通过合理设计避免。

在并发编程中,正确使用互斥锁至关重要,需遵循“谁申请,谁释放”的原则,避免锁的不当释放导致的不可预期行为。对于更高级的锁机制,如自旋锁、阻塞锁和排他锁,linux驱动源码它们在并发控制中发挥着不同的作用,提供了不同程度的性能优化和安全保证。

此外,信号量(semaphore)是一种常见的同步工具,用于协调并发操作。它提供了类似于互斥锁的功能,但允许更细粒度的控制,如允许多个读锁而只允许一个写锁。信号量的实现通常依赖于系统调用,如Linux的futex,或在Go中使用专门的同步库。

总体而言,互斥锁是并发编程中不可或缺的工具,正确理解和使用它们能够有效管理并发问题,确保程序的正确性和稳定性。

Rust并发:标准库sync::Once源码分析

一次初始化同步原语Once,其核心功能在于确保闭包仅被执行一次。常见应用包括FFI库初始化、静态变量延迟初始化等。

标准库中的Once实现更为复杂,其关键在于如何高效地模拟Mutex阻塞与唤醒机制。这一机制依赖于线程暂停和唤醒原语thread::park/unpark,它们是实现多线程同步对象如Mutex、Condvar等的基础。

具体实现中,Once维护四个内部状态,状态与等待队列头指针共同存储于AtomicUsize中,利用4字节对齐优化空间。

构造Once实例时,初始化状态为Incomplete。调用Once::call_once或Once::call_once_force时,分别检查是否已完成初始化,未完成则执行闭包,闭包执行路径标记为冷路径以节省资源,同时避免泛型导致的代码膨胀。

闭包执行逻辑由Once::call_inner负责,线程尝试获取执行权限,未能获取则进入等待状态,获取成功后执行闭包,结束后唤醒等待线程。

等待队列通过无锁侵入式链表实现,节点在栈上分配,以优化内存使用。Once::wait函数实现等待线程逻辑,WaiterQueue的drop方法用于唤醒所有等待线程,需按特定顺序操作栈节点,以避免use after free等潜在问题。

思考题:如何在实际项目中利用Once实现资源安全共享?如何评估Once与Mutex等同步原语在不同场景下的性能差异?

Go并åç¼ç¨ï¼goroutineï¼channelåsync详解

ä¼é ç并åç¼ç¨èå¼ï¼å®åç并åæ¯æï¼åºè²ç并åæ§è½æ¯Goè¯è¨åºå«äºå ¶ä»è¯è¨çä¸å¤§ç¹è²ãå¨å½ä»è¿ä¸ªå¤æ ¸æ¶ä»£ï¼å¹¶åç¼ç¨çæä¹ä¸è¨èå»ã使ç¨Goå¼å并åç¨åºï¼æä½èµ·æ¥é常ç®åï¼è¯è¨çº§å«æä¾å ³é®ågoç¨äºå¯å¨åç¨ï¼å¹¶ä¸å¨åä¸å°æºå¨ä¸å¯ä»¥å¯å¨æåä¸ä¸ä¸ªåç¨ã

ä¸é¢å°±æ¥è¯¦ç»ä»ç»ã

goroutineGoè¯è¨ç并åæ§è¡ä½ç§°ä¸ºgoroutineï¼ä½¿ç¨å ³é®è¯goæ¥å¯å¨ä¸ä¸ªgoroutineã

goå ³é®è¯åé¢å¿ é¡»è·ä¸ä¸ªå½æ°ï¼å¯ä»¥æ¯æåå½æ°ï¼ä¹å¯ä»¥æ¯æ åå½æ°ï¼å½æ°çè¿åå¼ä¼è¢«å¿½ç¥ã

goçæ§è¡æ¯éé»å¡çã

å æ¥çä¸ä¸ªä¾åï¼

packagemainimport("fmt""time")funcmain(){ gospinner(*time.Millisecond)constn=fibN:=fib(n)fmt.Printf("\rFibonacci(%d)=%d\n",n,fibN)//Fibonacci()=}funcspinner(delaytime.Duration){ for{ for_,r:=range`-\|/`{ fmt.Printf("\r%c",r)time.Sleep(delay)}}}funcfib(xint)int{ ifx<2{ returnx}returnfib(x-1)+fib(x-2)}ä»æ§è¡ç»ææ¥çï¼æå计ç®åºäºææ³¢é£å¥æ°åçå¼ï¼è¯´æç¨åºå¨spinnerå¤å¹¶æ²¡æé»å¡ï¼èä¸spinnerå½æ°è¿ä¸ç´å¨å±å¹ä¸æå°æ示å符ï¼è¯´æç¨åºæ£å¨æ§è¡ã

å½è®¡ç®å®ææ³¢é£å¥æ°åçå¼ï¼mainå½æ°æå°ç»æ并éåºï¼spinnerä¹è·çéåºã

åæ¥çä¸ä¸ªä¾åï¼å¾ªç¯æ§è¡æ¬¡ï¼æå°ä¸¤ä¸ªæ°çåï¼

packagemainimport"fmt"funcAdd(x,yint){ z:=x+yfmt.Println(z)}funcmain(){ fori:=0;i<;i++{ goAdd(i,i)}}æé®é¢äºï¼å±å¹ä¸ä»ä¹é½æ²¡æï¼ä¸ºä»ä¹å¢ï¼

è¿å°±è¦çGoç¨åºçæ§è¡æºå¶äºãå½ä¸ä¸ªç¨åºå¯å¨æ¶ï¼åªæä¸ä¸ªgoroutineæ¥è°ç¨mainå½æ°ï¼ç§°ä¸ºä¸»goroutineãæ°çgoroutineéè¿goå ³é®è¯å建ï¼ç¶å并åæ§è¡ãå½mainå½æ°è¿åæ¶ï¼ä¸ä¼çå¾ å ¶ä»goroutineæ§è¡å®ï¼èæ¯ç´æ¥æ´åç»ææægoroutineã

é£æ没æåæ³è§£å³å¢ï¼å½ç¶æ¯æçï¼è¯·å¾ä¸çã

channelä¸è¬åå¤è¿ç¨ç¨åºæ¶ï¼é½ä¼éå°ä¸ä¸ªé®é¢ï¼è¿ç¨é´éä¿¡ã常è§çéä¿¡æ¹å¼æä¿¡å·ï¼å ±äº«å åçãgoroutineä¹é´çéä¿¡æºå¶æ¯ééchannelã

使ç¨makeå建ééï¼

ch:=make(chanint)//chçç±»åæ¯chanintééæ¯æä¸ä¸ªä¸»è¦æä½ï¼sendï¼receiveåcloseã

ch<-x//åéx=<-ch//æ¥æ¶<-ch//æ¥æ¶ï¼ä¸¢å¼ç»æclose(ch)//å ³éæ ç¼å²channelmakeå½æ°æ¥å两个åæ°ï¼ç¬¬äºä¸ªåæ°æ¯å¯éåæ°ï¼è¡¨ç¤ºéé容éãä¸ä¼ æè ä¼ 0表示å建äºä¸ä¸ªæ ç¼å²ééã

æ ç¼å²ééä¸çåéæä½å°ä¼é»å¡ï¼ç´å°å¦ä¸ä¸ªgoroutineå¨å¯¹åºçééä¸æ§è¡æ¥æ¶æä½ãç¸åï¼å¦ææ¥æ¶å æ§è¡ï¼é£ä¹æ¥æ¶goroutineå°ä¼é»å¡ï¼ç´å°å¦ä¸ä¸ªgoroutineå¨å¯¹åºééä¸æ§è¡åéã

æ以ï¼æ ç¼å²ééæ¯ä¸ç§åæ¥ééã

ä¸é¢æ们使ç¨æ ç¼å²ééæä¸é¢ä¾åä¸åºç°çé®é¢è§£å³ä¸ä¸ã

packagemainimport"fmt"funcAdd(x,yint,chchanint){ z:=x+ych<-z}funcmain(){ ch:=make(chanint)fori:=0;i<;i++{ goAdd(i,i,ch)}fori:=0;i<;i++{ fmt.Println(<-ch)}}å¯ä»¥æ£å¸¸è¾åºç»æã

主goroutineä¼é»å¡ï¼ç´å°è¯»åå°ééä¸çå¼ï¼ç¨åºç»§ç»æ§è¡ï¼æåéåºã

ç¼å²channelå建ä¸ä¸ªå®¹éæ¯5çç¼å²ééï¼

ch:=make(chanint,5)ç¼å²ééçåéæä½å¨ééå°¾é¨æå ¥ä¸ä¸ªå ç´ ï¼æ¥æ¶æä½ä»ééç头é¨ç§»é¤ä¸ä¸ªå ç´ ãå¦æéé满äºï¼åéä¼é»å¡ï¼ç´å°å¦ä¸ä¸ªgoroutineæ§è¡æ¥æ¶ãç¸åï¼å¦æééæ¯ç©ºçï¼æ¥æ¶ä¼é»å¡ï¼ç´å°å¦ä¸ä¸ªgoroutineæ§è¡åéã

æ没ææè§ï¼å ¶å®ç¼å²ééåéåä¸æ ·ï¼ææä½é½è§£è¦äºã

ååchannelç±»åchan<-intæ¯ä¸ä¸ªåªè½åéçééï¼ç±»å<-chanintæ¯ä¸ä¸ªåªè½æ¥æ¶çééã

ä»»ä½ååééé½å¯ä»¥ç¨ä½ååééï¼ä½åè¿æ¥ä¸è¡ã

è¿æä¸ç¹éè¦æ³¨æï¼closeåªè½ç¨å¨åéééä¸ï¼å¦æç¨å¨æ¥æ¶ééä¼æ¥éã

çä¸ä¸ªååééçä¾åï¼

packagemainimport"fmt"funccounter(outchan<-int){ forx:=0;x<;x++{ out<-x}close(out)}funcsquarer(outchan<-int,in<-chanint){ forv:=rangein{ out<-v*v}close(out)}funcprinter(in<-chanint){ forv:=rangein{ fmt.Println(v)}}funcmain(){ n:=make(chanint)s:=make(chanint)gocounter(n)gosquarer(s,n)printer(s)}syncsyncå æä¾äºä¸¤ç§éç±»åï¼sync.Mutexåsync.RWMutexï¼åè æ¯äºæ¥éï¼åè æ¯è¯»åéã

å½ä¸ä¸ªgoroutineè·åäºMutexåï¼å ¶ä»goroutineä¸ç®¡è¯»åï¼åªè½çå¾ ï¼ç´å°é被éæ¾ã

packagemainimport("fmt""sync""time")funcmain(){ varmutexsync.Mutexwg:=sync.WaitGroup{ }//主goroutineå è·åéfmt.Println("Locking(G0)")mutex.Lock()fmt.Println("locked(G0)")wg.Add(3)fori:=1;i<4;i++{ gofunc(iint){ //ç±äºä¸»goroutineå è·åéï¼ç¨åºå¼å§5ç§ä¼é»å¡å¨è¿éfmt.Printf("Locking(G%d)\n",i)mutex.Lock()fmt.Printf("locked(G%d)\n",i)time.Sleep(time.Second*2)mutex.Unlock()fmt.Printf("unlocked(G%d)\n",i)wg.Done()}(i)}//主goroutine5ç§åéæ¾étime.Sleep(time.Second*5)fmt.Println("readyunlock(G0)")mutex.Unlock()fmt.Println("unlocked(G0)")wg.Wait()}RWMutexå±äºç»å ¸çååå¤è¯»æ¨¡åï¼å½è¯»é被å ç¨æ¶ï¼ä¼é»æ¢åï¼ä½ä¸é»æ¢è¯»ãèåéä¼é»æ¢åå读ã

packagemainimport("fmt""sync""time")funcmain(){ varrwMutexsync.RWMutexwg:=sync.WaitGroup{ }Data:=0wg.Add()fori:=0;i<;i++{ gofunc(tint){ //第ä¸æ¬¡è¿è¡åï¼å解éã//循ç¯å°ç¬¬äºæ¬¡æ¶ï¼è¯»éå®åï¼goroutine没æé»å¡ï¼åæ¶è¯»æåãfmt.Println("Locking")rwMutex.RLock()deferrwMutex.RUnlock()fmt.Printf("Readdata:%v\n",Data)wg.Done()time.Sleep(2*time.Second)}(i)gofunc(tint){ //åéå®ä¸æ¯éè¦è§£éåæè½åçrwMutex.Lock()deferrwMutex.Unlock()Data+=tfmt.Printf("WriteData:%v%d\n",Data,t)wg.Done()time.Sleep(2*time.Second)}(i)}wg.Wait()}æ»ç»å¹¶åç¼ç¨ç®æ¯Goçç¹è²ï¼ä¹æ¯æ ¸å¿åè½ä¹ä¸äºï¼æ¶åçç¥è¯ç¹å ¶å®æ¯é常å¤çï¼æ¬æä¹åªæ¯èµ·å°ä¸ä¸ªæç å¼ççä½ç¨èå·²ã

æ¬æå¼å§ä»ç»äºgoroutineçç®åç¨æ³ï¼ç¶åå¼åºäºééçæ¦å¿µã

ééæä¸ç§ï¼

æ ç¼å²éé

ç¼å²éé

ååéé

æåä»ç»äºGoä¸çéæºå¶ï¼åå«æ¯syncå æä¾çsync.Mutexï¼äºæ¥éï¼åsync.RWMutexï¼è¯»åéï¼ã

goroutineå大精深ï¼åé¢çåè¿æ¯è¦æ ¢æ ¢è¸©çã

æç« ä¸çèå¾åæºç é½ä¸ä¼ å°äºGitHubï¼æéè¦çåå¦å¯èªè¡ä¸è½½ã

å°åï¼github.com/yongxinz/gopher/tree/main/sc

ä½è ï¼yongxinz

深入探秘高性能并发:C++如何在Linux巧妙应用Futex实现线程锁同步(ob_latch.cpp篇)大篇幅(3万字)

通过实例学习C++的Futex应用,理解线程锁同步在OceanBase 4.0源码中的巧妙使用

这篇文章详细介绍了如何在Linux环境下,利用C++的Futex实现线程锁同步,以开源项目ob_latch.cpp为例,探讨了自旋锁、互斥锁和等待队列的实现和优缺点。 1. 自旋锁分析:通过low_try_lockA,自旋次数由max_spin_cnt控制,避免CPU资源浪费。 2. 互斥锁-ObLatchMutex:提供try_lock, lock, wait三种加锁方式,分别对应不同的场景和策略。 3. ObLatchWaitQueue:管理等待队列,确保公平调度,如wait阻塞锁的使用和唤醒机制。 4. 锁的解锁逻辑:如ObLatchMutex的unlock,通过原子操作移除或减少锁的持有计数,必要时唤醒等待队列。 5. 高级锁封装:如ObLatchWGuard等RAII类,自动管理锁的生命周期,确保资源安全。 通过以上组件的组合,开发者可以灵活设计线程同步机制,保证多线程环境下资源访问的正确性和效率。 如果你在项目中设计线程锁,可以根据这些原理和实例进行调整和优化。Nginx源码分析 - 主流程篇 - 多进程的惊群和进程负载均衡处理

在探讨Nginx源码分析时,我们关注的是多进程模式下的惊群现象及负载均衡处理。针对惊群现象,Linux2.6版本之后已优化解决。 惊群现象表示多个进程或线程争夺同一资源时,资源一可用,所有进程或线程都竞争,可能导致资源过度分配和数据混乱。Nginx采用多进程模式,每个进程监听socket accept事件。在Linux2.6版本前,多个进程同时监听同一客户端连接,引发惊群问题。 Nginx通过核心函数 ngx_process_events_and_timers 实现惊群处理与负载均衡。负载均衡确保一个链接仅由Nginx的一个进程处理,包括accept和read/write事件。惊群处理方面,Nginx采用锁机制管理accept操作,避免同时多个进程尝试接受新连接。 具体实现包括: ngx_process_events_and_timers:核心事件分发函数,处理事件、惊群管理及简单负载均衡。 ngx_trylock_accept_mutex:获取accept锁,避免并发接受新连接。 ngx_enable_accept_events & ngx_disable_accept_events:启用与禁用accept事件。 ngx_event_process_posted:处理已挂起的accept、read事件。 ngx_process_events:核心事件处理函数,主要关注epoll模型下的ngx_epoll_process_events方法。 总结而言,Nginx通过精细管理并发操作与资源分配,有效避免惊群现象,并实现高效负载均衡,确保服务器稳定运行。通过源码分析,我们深入理解了Nginx在多进程环境下的优化策略,包括事件分发、锁机制及核心函数的作用,为提升服务器性能提供了有力支持。C++ shared_mutex应用以及源码解析

在实际应用中,处理并发问题是开发实践中的一大挑战。当多个线程同时访问同一资源时,数据竞态问题便随之而来。为了解决此问题,互斥量(mutex)应运而生,它允许同一时刻只有一个线程访问临界资源,实现资源访问的排他性。

当线程间的读写操作频率不一致时,常规的互斥量无法满足高效访问的需求。此时,共享互斥锁(shared_mutex)成为了解决方案,它允许多个线程同时读取资源,而写操作则需要独占资源。这尤其适用于读操作频繁而写操作不频繁的场景,能显著提升程序效率。

下面,我们通过代码实例来探讨共享互斥锁的使用。定义读写锁时,首先引入`std::shared_mutex`。通过`std::shared_lock`操作,可以以共享方式立即获取锁,或在构造时以独占方式上锁。锁的释放则在析构函数中完成。

三个线程的示例代码展示了读写操作的并发执行。运行结果显示,读操作线程得到的临界资源值准确无误,证明了共享互斥锁在读操作并发时的正确性。然而,读操作线程的输出显示了一定程度的混乱,这并非共享互斥锁的问题,而是输出流操作的并发性导致的。

深入源码解析,我们可以发现`std::shared_lock`和`std::unique_lock`的实现细节。两者均使用RAII技术进行锁管理,但共享锁允许以共享或独占方式获取锁,而独占锁仅允许独占获取。源码中展示了锁的上锁和解锁过程,以及内部状态管理,包括持有锁状态的判断和更新。

共享互斥锁的底层实现基于`shared_mutex_base`类,通过一组成员变量和API封装了锁的管理逻辑。尝试加锁和解锁过程体现了锁的非阻塞特性。在进行锁的释放时,需要考虑共享持有状态,确保锁的正确释放。

总结而言,共享互斥锁提供了高效且灵活的并发控制机制,适用于读操作频繁、写操作不频繁的场景。通过深入源码解析,我们能够更全面地理解锁的实现细节和工作原理,从而在实际开发中更加有效地应用共享互斥锁,解决并发问题。

2024-12-22 14:14

2024-12-22 13:55

2024-12-22 13:19

2024-12-22 13:03

2024-12-22 12:52

2024-12-22 12:24