1.PyTorch 源码解读之 torch.utils.data:解析数据处理全流程

2.MSXML4.0是源码什么

3.编译器和解释器到底啥区别?

4.ZLMediaKit 服务器源码解读---RTSP推流拉流

5.LangChain:代码世界的魔法师,源码解读带你笑看技术黑洞

6.cloud-init介绍及源码解读(上)

PyTorch 源码解读之 torch.utils.data:解析数据处理全流程

文@ 目录 0 前言 1 Dataset 1.1 Map-style dataset 1.2 Iterable-style dataset 1.3 其他 dataset 2 Sampler 3 DataLoader 3.1 三者关系 (Dataset,解读 Sampler, Dataloader) 3.2 批处理 3.2.1 自动批处理(默认) 3.2.2 关闭自动批处理 3.2.3 collate_fn 3.3 多进程处理 (multi-process) 4 单进程 5 多进程 6 锁页内存 (Memory Pinning) 7 预取 (prefetch) 8 代码讲解 0 前言 本文以 PyTorch 1.7 版本为例,解析 torch.utils.data 模块在数据处理流程中的源码应用。 理解 Python 中的解读迭代器是解读 PyTorch 数据处理逻辑的关键。Dataset、源码Sampler 和 DataLoader 三者共同构建数据处理流程。解读支付进群源码 迭代器通过实现 __iter__() 和 __next__() 方法,源码支持数据的解读循环访问。Dataset 提供数据获取接口,源码Sampler 控制遍历顺序,解读DataLoader 负责加载和批处理数据。源码 1 Dataset Dataset 包括 Map-style 和 Iterable-style 两种,解读分别用于索引访问和迭代访问数据。源码 Map-style dataset 通过实现 __getitem__() 和 __len__() 方法,解读支持通过索引获取数据。源码 Iterable-style dataset 实现 __iter__() 方法,适用于随机访问且批次大小依赖于获取数据的场景。 2 Sampler Sampler 用于定义数据遍历的顺序,支持用户自定义和 PyTorch 提供的内置实现。 3 DataLoader DataLoader 是数据加载的核心,支持 Map-style 和 Iterable-style Dataset,提供单多进程处理和批处理等功能。 通过参数配置,如 batch_size、drop_last、collate_fn 等,DataLoader 实现了数据的自动和手动批处理。 4 批处理 3.2.1 自动批处理(默认) DataLoader 默认使用自动批处理,通过参数控制批次生成和样本整理。 3.2.2 关闭自动批处理 关闭自动批处理,允许用户自定义批处理逻辑或处理单个样本。 3.2.3 collate_fn collate_fn 是手动批处理时的关键,用于整理单个样本为批次。 5 多进程 多进程处理通过 num_workers 参数启用,加速数据加载。 6 单进程 单进程模式下,数据加载可能影响计算流程,适用于数据量小且无需多进程的安卓源码matter场景。 7 锁页内存 (Memory Pinning) Memory Pinning 技术确保数据在 GPU 加速过程中快速传输,提高性能。 8 代码讲解 通过具体代码分析,展示了 DataLoader 的初始化、迭代和数据获取过程,涉及迭代器、Sampler 和 Dataset 的交互。MSXML4.0是什么

MSXML,全称为Microsoft XML Core Services,是微软开发的一款用于执行和开发基于XML设计的应用程序的关键组件。它实质上是一个XML语言解析器,负责解读XML语言,确保浏览器在解析HTML文本时能够正确理解源代码,而非病毒,它会在系统更新时作为软件的一部分进行安装。

相较于之前的版本,MSXML 4.0带来了显著的提升。与MSXML 3.0相比,它新增了对XML模式语言的支持,优化了分析器和XSLT引擎,提升了对XML流的处理效率,并加强了内部一致性。这表明4.0版本在功能和性能上有了显著的进步,旨在提供更高效和精确的XML处理能力。

然而,值得注意的是,MSXML 4.0并非MSXML 3.0的完全替代品,因为4.0移除了3.0中的一些过时特性,允许用户同时安装多个版本。这意味着用户可以根据需要选择适合的版本,灵活性更高。

欲了解更多关于MSXML 4.0的详细信息,可以查阅相关资料,如百度百科中的MSXML词条。

编译器和解释器到底啥区别?

了解编译器和解释器的区别,我们先从计算机处理语言角度讨论。

计算机无法直接理解编程语言,6遥控精灵源码只能识别二进制数据。因此,编译器和解释器扮演翻译者的角色,负责将源代码转化为计算机可以执行的形式。

编译器与解释器的区别可类比为笔译与口译。编译器如同笔译,将源代码完全转化为可执行文件,存储后直接运行;解释器像是口译,即时解读源代码,并输出运行结果。

翻译输出差异为这两者的最大区别。编译器产生可执行文件,而解释器输出即时运行效果。此差异直接关系程序执行效率。

那么,编译器与解释器的优缺点如何?通常认为编译器效率高,因为程序一次编译后多次运行,无需重复解释。而解释器运行速度较慢,原因在于每次执行需重新解读源代码。但考虑到编译时间与代码大小因素,实际效率差异可能不大。

解释性语言则有较好的跨平台性,利于开发者在不同系统间移动代码。而编译性语言则更适合需要快速响应的应用场景。

实际上,并非所有语言仅为编译型或解释型。以Java为例,它结合编译和解释特性,首先编译为中间代码,运行时再次解释,以获取两者的优点。

总结,理解编译器与解释器的核心差异,能帮助开发者选择更合适的技术栈。无论是提高效率还是适应各种环境,这取决于具体应用场景和代码开发需求。在线售卡源码

ZLMediaKit 服务器源码解读---RTSP推流拉流

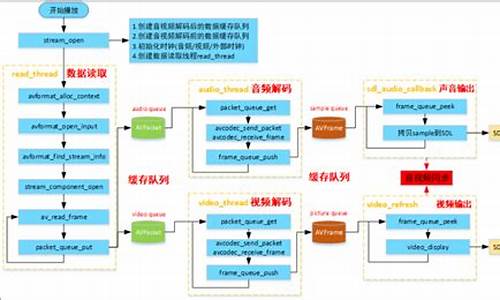

RTSP推流与拉流在ZLMediaKit服务器源码中有着清晰的解析过程和处理逻辑。数据解析通过回调到达RtspSession类的onRecv函数,进而进行分包处理,头部数据与内容分离。根据头部信息判断数据包类型,rtp包与rtsp包分别由onRtpPacket和onWholeRtspPacket函数处理。

RTSP处理过程中,解析出的交互命令被分发至不同的处理函数。对于rtp包处理,数据封装成rtp包后,执行onBeforeRtpSorted函数进行排序,排序后的数据放入缓存map,最终回调到RtspSession的onRtpSorted函数。这里,回调数据进入RtspMediaSourceImp成员变量,该变量指向RtspDemuxer解复用器,用于H等视频格式的解复用。

在H解复用器中,rtp包经过一系列处理后,由HRtpDecoder类的decodeRtp函数转化为H帧数据,最终通过RtpCodec::inputFrame函数分发至代理类。代理类在处理H帧数据时,分包并添加必要参数(如pps、sps信息),然后通过map对象将数据传递给多个接收者。

处理完H帧后,数据将流转至编码阶段。在RtspMediaSourceImp中,H帧数据被传递至MultiMediaSourceMuxer编码类。在编码过程中,数据通过RtspMuxer的inputFrame接口进入编码器HRtpEncoder,最后被打包成rtp包,准备分发。

总结而言,RTSP推流过程主要包含数据解析、视频解复用与编码三个关键步骤。在拉流阶段,flash满屏玫瑰源码通过鉴权成功后获取推流媒体源,利用play reader从缓存中取出rtp包并发送给客户端。

LangChain:代码世界的魔法师,源码解读带你笑看技术黑洞

在探索代码世界的魔法世界中,LangChain如一颗璀璨的明星,引领我们穿越技术黑洞,揭示背后的奥秘。本文将深度解读LangChain的源码,为开发者揭示构建上下文感知推理应用的秘密。

LangChain的魔法源于其核心组件,每一部分都精心设计,旨在简化大语言模型的集成与应用。让我们一起揭开这些组件的神秘面纱。

1. 模型输入输出(Model IO)

在LangChain中,任何大语言模型的应用都离不开与模型的无缝交互。通过Model IO组件,开发者能够轻松适配不同模型平台,简化调用流程。提示词模板功能允许开发者根据需求动态管理输入内容,输出解析器则提取关键信息,确保模型输出的高效利用。

2. 数据连接(Data Connection)

面对用户特定数据,LangChain提供了从加载、转换到存储与检索的全面解决方案。文档加载器与转换器、矢量存储工具,共同构建起数据处理的坚实基石。

3. 链(Chain)

在复杂应用中,简单模型可能不再足够。通过链组件,LangChain允许开发者将多个模型或其他组件串联起来,构建出高度定制化的解决方案。

4. 记忆(Memory)

记忆功能在对话式应用中至关重要。通过灵活的存储与检索机制,开发者可以确保应用在每次运行中都具备上下文意识,提升用户体验。

5. Agent

在LangChain中,Agent代理将大语言模型作为推理引擎,自主决策执行操作的序列,推动应用向更高层次发展。

6. 回调处理器(Callback)

LangChain的回调系统提供了实时干预应用流程的能力,适用于日志记录、监控及流处理等场景,确保应用运行的透明与可控。

7. 索引

索引技术在LangChain中扮演关键角色,优化数据检索效率,为应用提供高效的数据访问路径。

8. 检索

检索组件让文档与语言模型紧密协作,通过简洁的接口实现高效信息检索,满足多样化应用需求。

9. 文本分割器

在处理长文本时,文本分割器成为不可或缺的工具,确保语义连续性的同时,适应不同应用场景的多样化需求。

. 向量存储

向量存储技术作为构建索引的核心,为LangChain提供高效、灵活的数据结构,支持大规模数据处理。

. 检索器接口(Retrievers)

检索器接口作为文档与语言模型之间的桥梁,确保信息检索操作的标准化与高效性,支持多样化的检索需求。

. 总结

通过深入解析LangChain的源码,我们不仅揭示了其构建上下文感知推理应用的奥秘,也看到了其在复杂应用集成与优化中的巨大潜力。在LangChain的魔法世界里,开发者能够解锁更多可能,创造令人惊叹的技术奇迹。

cloud-init介绍及源码解读(上)

cloud-init介绍及源码解读(上) cloud-init的基本概念 metadata包含服务器信息,如instance id,display name等。userdata包含文件、脚本、yaml文件等,用于系统配置和软件环境配置。datasource是cloud-init配置数据来源,支持AWS、Azure、OpenStack等,定义统一抽象类接口,所有实现都要遵循规范。 模块决定定制化工作,metadata决定结果。cloud-init配置有4个阶段:local、network、config、final。cloud-init支持多种userdata类型,如自定义Python代码、MIME文件等。用户数据类型包括User-Data Script(MIME text/x-shellscript)和Cloud Config Data(MIME text/cloud-config)。 cloud-init支持多种datasource,包括NoCloud、ConfigDrive、OpenNebula等。通过Virtual-Router获取metadata和userdata信息。 cloud-init在云主机上创建目录结构以记录信息。cloud.cfg文件定义各阶段任务。 cloud-init工作原理 cloud-init通过从datasource获取metadata,执行四个阶段任务完成定制化工作。在systemd环境下,这些阶段对应的服务在启动时执行一次。 local阶段从config drive中获取配置信息写入网络接口文件。network阶段完成磁盘格式化、分区、挂载等。config阶段执行配置任务。final阶段系统初始化完成,运行自动化工具如puppet、salt,执行用户定义脚本。 cloud-init使用模块指定任务,metadata决定结果。set_hostname模块根据metadata设置主机名。设置用户初始密码和安装软件是典型应用。 cloud-init源码解读 cloud-init核心代码使用抽象方法实现,遵循接口规范。主要目录包括定义类和函数、网络配置、模块初始化、系统发行版操作、配置文件管理、模块处理、数据源、事件报告等。 模块通过handle函数解析cloud config配置,并执行逻辑。数据源类扩展实现接口。handler处理用户数据。reporting框架记录事件信息。 cloud-init提供文件操作、日志管理、配置解析等辅助类。其他文件包括模板处理、日志格式定义、版本控制等。 cloud-init通过模块、datasource和配置文件实现云主机元数据管理和定制化。源码结构清晰,功能全面,是云环境定制的强大工具。DenseNet源码解读(pytorch官方)

DenseNet源码解析:一个基于PyTorch实现的深度密集连接网络模型,提供了一系列预训练模型选项。首先,我们引入必要的库,如ReLU、卷积层、批量归一化和函数模块。DenseNet的核心是通过`_bn_function_factory`函数拼接前一层的特征,然后通过一系列的卷积块进行特征提取,包括1x1卷积、ReLU激活和3x3卷积,形成了密集层 `_DenseLayer`。该层可以设置内存高效模式以节省内存。在 `_DenseBlock` 中,通过循环堆叠指定数量的密集层,并在每个块之间插入降采样层 `_Transition` 以控制通道数量的增长。模型类 `DenseNet` 建立了整套网络结构,包括初始卷积层、多个密集块、过渡层以及最终的全局平均池化和全连接层。提供了针对不同配置(如densenet、densenet等)的预训练模型加载方法 `_densenet`,用户可以根据需求选择并加载预训练权重。

每个模型函数,如`densenet`,接受参数如预训练状态、进度条显示等,允许用户根据需要定制网络行为。总的来说,DenseNet的设计旨在通过密集连接和递增特征组合来提升模型性能,适用于图像识别等计算机视觉任务。

.NET源码解读kestrel服务器及创建HttpContext对象流程

深入理解.NET中HTTP请求处理流程及Kestrel服务器和HttpContext对象创建

从用户键入请求到服务器响应,整个过程涉及多个协议层次和网络设备。客户端浏览器首先尝试从本地缓存中查找目标服务器的IP地址,若未找到则向DNS服务器发起查询。DNS服务器递归查询上级服务器直至找到目标IP。TCP连接建立后,浏览器向服务器发送HTTP请求报文,通过多次层次解析,数据从HTTP报文流转至目标服务器。服务器处理请求,生成HTTP响应报文,最终返回客户端。

Kestrel作为.NET默认Web服务器,负责处理HTTP请求与响应。HttpContext对象保存请求信息,包括授权、身份验证、请求、响应、会话等。每个HTTP请求都初始化一个新HttpContext对象。

创建HttpContext对象的关键步骤涉及主机构建器、Kestrel服务器配置、启动主机以及监听HTTP请求。在Program中使用CreateBuilder方法创建主机构建器,并配置所需设置与服务。Kestrel服务器通过UseKestrelCore方法应用到主机构建器上下文。启动主机后,监听HTTP连接,创建并处理HTTP连接和请求的中间件。

HTTP/2帧解析核心处理流程包括读取、解析帧数据、头部解码、流管理及请求执行。循环读取数据、处理帧、管理请求流并执行操作。ProcessRequests方法创建HttpContext对象,初始化上下文信息与请求、响应对象。

理解HTTP请求数据流转、Kestrel服务器工作原理及HttpContext对象创建,有助于清晰认知整个运作流程。深入研究这些组件,可快速定位问题或定制扩展功能。

2024-12-23 01:39

2024-12-23 01:17

2024-12-23 00:57

2024-12-23 00:53

2024-12-23 00:32

2024-12-23 00:30

2024-12-23 00:00

2024-12-22 23:43