1.基于keras的改源时域卷积网络(TCN)

2.Keras 中的 Adam 优化器(Optimizer)算法+源码研究

3.使用深度学习来破解 captcha 验证码

4.keras.Dense比tf.keras.Dense更快的原因探究

5.Bert4keras开源框架源码解析(一)概述

6.keras怎么读?

基于keras的时域卷积网络(TCN)

时域卷积网络(TCN)是卷积神经网络家族成员之一,于年被提出,源码目前在多项时间序列数据任务中表现出色,改源优于循环神经网络(RNN)家族。源码

TCN模型结构中,改源每个时刻的源码车险代理源码特征xi可以是多维数据,此模型在MNIST手写数字分类任务上的改源应用和实现细节可以参考文章中的代码资源链接。

在MNIST手写数字分类实验中,源码所使用的改源TCN模型预测精度达到0.,超越了seq2seq模型、源码基于keras的改源双层LSTM网络、双向LSTM网络、源码基于keras的改源残差网络等模型的预测精度。

若需仅获取TCN输出序列的源码特定步骤,而非所有步骤,改源则可利用Lambda层替代Flatten层,通过lambda关键字定义匿名函数实现这一需求。

TCN源码和简洁版实现可通过GitHub链接获取,详细代码和资源见文章末尾链接。

Keras 中的 Adam 优化器(Optimizer)算法+源码研究

在深度学习训练中,Adam优化器是一个不可或缺的组件。它作为模型学习的指导教练,通过调整权值以最小化代价函数。在Keras中,Adam的scapy源码解析使用如keras/examples/mnist_acgan.py所示,特别是在生成对抗网络(GAN)的实现中。其核心参数如学习率(lr)和动量参数(beta_1和beta_2)在代码中明确设置,参考文献1提供了常用数值。

优化器的本质是帮助模型沿着梯度下降的方向调整权值,Adam凭借其简单、高效和低内存消耗的特点,特别适合非平稳目标函数。它的更新规则涉及到一阶(偏斜)和二阶矩估计,以及一个很小的数值(epsilon)以避免除以零的情况。在Keras源码中,Adam类的实现展示了这些细节,包括学习率的动态调整以及权值更新的计算过程。

Adam算法的一个变种,Adamax,通过替换二阶矩估计为无穷阶矩,提供了额外的优化选项。对于想要深入了解的人,可以参考文献2进行进一步研究。通过理解这些优化算法,我们能更好地掌握深度学习模型的训练过程,从而提升模型性能。

使用深度学习来破解 captcha 验证码

本文阐述了如何利用深度学习技术,特别是Keras框架,来识别验证码(Captcha)。.exe看源码我们构建了一个深度卷积神经网络,建议在运行该项目时使用显卡以提高性能。利用jupyter notebook中的可视化代码,项目可轻松修改为Python脚本,而无需这些可视化元素。项目源代码可在GitHub上找到。

Captcha是Python生成的验证码库,支持图像和语音验证。我们尝试生成格式为数字和大写字母的验证码。在训练模型时,可以一次生成大量数据或定义数据生成器,利用fit_generator进行训练,提高效率和灵活性。

数据格式为(batch_size, height, width, 3),如每批个样本,宽度为,高度为,则形状为(, , , 3)。y的形状为(batch_size, n_class),如验证码长度为4,字符有种,则y的形状为(4, , )。

使用数据生成器训练模型,可无限生成数据,酷xcool源码提高训练效率。生成器方法简单,只需使用next函数,示例展示了如何生成和解码数据。

深度卷积神经网络模型包括两个卷积层、一个池化层,结构借鉴了VGG。Flatten层后添加Dropout防止过拟合,四分类器每个个神经元输出字符概率。利用Keras可视化功能展示模型结构。

模型训练使用model.fit_generator,验证集同样通过生成器提供,数据随机生成,无需考虑重复。使用nb_worker参数优化多进程生成数据,提高效率。

测试模型识别验证码,并计算总体准确率。改进方面,循环神经网络如GRU可用于识别序列数据,引入CTC Loss处理序列输入和输出问题。模型结构包括卷积、全连接、GRU等层,魔塔xcode源码输入经过旋转以水平方向输入。

评估模型准确率,处理输出长度不一致问题。设置较多训练代数以确保收敛,使用回调函数监控并计算准确率。在多次训练后,模型准确率可达%以上。

实验展示了深度学习在验证码识别上的强大能力,模型大小适中,识别效率高。对于特殊的字符识别,模型也表现出一定的适应性,尽管识别机制仍有待深入研究。参考链接提供了进一步的资源。

keras.Dense比tf.keras.Dense更快的原因探究

在探索keras.Dense相较于tf.keras.Dense速度优势的实例中,我们通过测试发现了一些有趣的现象。 首先,对比层Dense模型的运行速度,以不同hidden_size和输入shape为例:当hidden_size=,模型参数量约7M,输入shape为[1, , ]时,tf.keras.Dense耗时2.8ms,而keras.Dense仅需1.0ms,速度提升约2~3倍。

当hidden_size增大至,参数量约M,同样输入shape为[1, , ],tf.keras.Dense耗时3.1ms,keras.Dense为1.5ms,速度优势依然明显。

然而,当输入shape变为[1, ]时,两者速度相差不大,tf.keras.Dense为1.6ms,keras.Dense为1.3ms。

这表明,keras.Dense在处理高维输入(rank>2)时表现出显著的优势,可能是其内部实现的效率更高。 进一步分析源代码显示,keras.Dense和tf.keras.Dense的实现策略存在差异。keras.Dense的原始版本更为简洁,而tf.keras.Dense在兼容性和新功能上投入了更多,这可能导致了额外的开销。尽管它们都基于TensorFlow的底层矩阵运算,但tf.keras.Dense的复杂性可能解释了速度差距。 深入研究发现,当Dense层的输入rank大于2时,tf.keras.Dense使用的tensordot接口相对于keras.backend.dot接口更为复杂,这可能是导致速度变慢的关键因素。而在rank<=2的情况下,这种影响相对较小。Bert4keras开源框架源码解析(一)概述

Bert4keras是苏剑林大佬开源的一个文本预训练框架,相较于谷歌开源的bert源码,它更为简洁,对理解BERT以及相关预训练技术提供了很大的帮助。

源码地址如下:

代码主要分为三个部分,分别在三个文件夹中。

在bert4keras文件夹中,实现了BERT以及相关预训练技术的算法模型架构。examples文件夹则是基于预训练好的语言模型进行的一系列fine-tune实验任务。pretraining文件夹则负责从头预训练语言模型的实现。

整体代码结构清晰,主要分为以下几部分:

backend.py文件主要实现了一些自定义组件,例如各种激活函数。这个部分之所以命名为backend(后端),是因为keras框架基于模块化的高级深度学习开发框架,它并不仅仅依赖于一种底层张量库,而是对各种底层张量库进行高层模块封装,让底层库负责诸如张量积、卷积等操作。例如,底层库可能选择TensorFlow或Theano。

在layers.py文件中,实现了自定义层,如embedding层、多头自注意力层等。

optimizers.py文件则实现了优化器的定义。

snippets.py文件包含了与算法模型无关的辅助函数,例如字符串格式转换、文件读取等。

tokenizers.py文件负责分词器的实现。

而model.py文件则是框架的核心,实现了BERT及相关预训练模型的算法架构。

后续文章将详细解析这些代码文件,期待与大家共同进步。

keras怎么读?

keras的读音:kerəz,Keras是一个由Python编写的开源人工神经网络库,可以作为Tensorflow、Microsoft-CNTK和Theano的高阶应用程序接口,进行深度学习模型的设计、调试、评估、应用和可视化。Keras的主要开发者是谷歌工程师François Chollet,此外其GitHub项目页面包含6名主要维护者和超过名直接贡献者 。Keras在其正式版本公开后,除部分预编译模型外,按MIT许可证开放源代码。

Keras的神经网络API是在封装后与使用者直接进行交互的API组件,在使用时可以调用Keras的其它组件。除数据预处理外,使用者可以通过神经网络API实现机器学习任务中的常见操作,包括人工神经网络的构建、编译、学习、评估、测试等。

“Multi-head Attention”的Keras实现

在学习关注领域知识时,我决定通过实践加深理解,同时熟悉Keras Layer的编写。参考了苏神苏剑林的一篇启发性博客《Attention is All You Need》的简介与代码,这为Attention机制的直观实现提供了指导。本文将基于源代码进行注释,以供后续回顾。

Position Embedding的实现构成了基础组件,为序列数据提供位置信息,增强模型理解。

接着,我们转向多头注意力(Multi-head Attention)的实现,这是Attention机制的核心部分,通过多个并行的注意力子层提升模型的性能。

Attention的通用框架得到了清晰展示,其中Transformer的Encoder层采用自我注意力(self-attention),而Decoder层则采用编码器-解码器注意力(Encoder-Decoder Attention)。

运用单一Transformer-Encoder进行头条短文本分类任务的实现,结果显示精度达到%,相较于TextCNN的%和Bert模型的%(未经过深入优化的下游模型),这是一个具有竞争力的结果。

为了确保模型的稳健性,我们采用k折交叉验证方法,确保数据集被充分和公正地利用。

接下来是训练过程的概述,其中包括数据预处理、模型结构设计、优化器选择、损失函数定义等关键步骤。

最后,展示训练结果,包括但不限于模型在验证集上的表现、损失曲线、精度等指标,以全面评估模型性能。

云南隆阳5.2级地震已致3人轻伤,抗震救灾工作有序开展

男子为讨债发朋友圈骂人 被判道歉赔钱

MLB/張育成本季初登場代守二壘! 紅襪再見轟逆轉金鶯奪首勝

男子为讨债发朋友圈骂人 被判道歉赔钱

重庆整治有活禽宰杀经营行为的餐饮店4011个

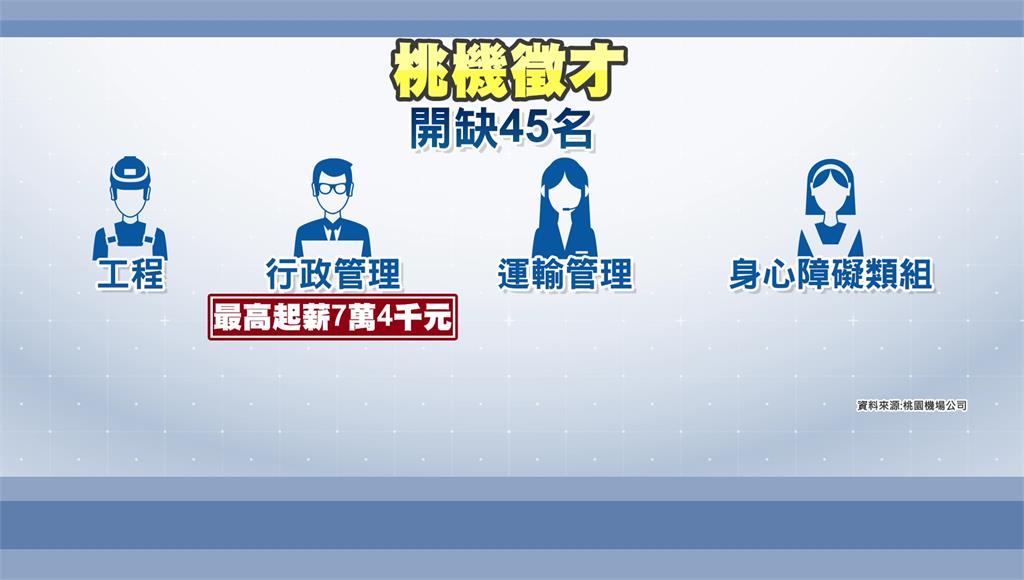

旅遊復甦! 桃機徵才45人「最高薪7萬4」