1.PyTorch源码学习 - (13)模型的码下保存与加载

2.Pytorch源码剖析:nn.Module功能介绍及实现原理

3.[技术随笔]🛠🛠从源码安装Pytorch3D详细记录及学习资料

4.树莓派安装pytorch,史上最全方法合集(附安装链接)

5.pytorch源码阅读系列之Parameter类

6.PyTorch 源码分析(三):torch.nn.Norm类算子

PyTorch源码学习 - (13)模型的码下保存与加载

在PyTorch源码中,模型的码下保存与加载是通过`torch.save`和`torch.load`两个核心函数实现的。`torch.save`负责将一个Python对象持久化到磁盘文件,码下而`torch.load`则用于从磁盘文件中恢复对象。码下

在具体的码下navi源码是什么实现中,`torch.save`会使用一系列辅助函数如`torch._opener`,码下`torch._open_zipfile_writer`,码下`torch._open_zipfile_writer_file`,码下`torch._open_zipfile_writer_buffer`等来操作文件和流。码下根据文件或内存缓冲区创建流容器,码下进行对象的码下保存。`torch._save`则进一步封装了文件的码下打开和写入过程,`torch._open_file_like`和`torch._open_file`用于管理文件句柄,码下`torch._open_buffer_writer`和`torch._open_buffer_reader`则封装了二进制流的码下读写。

对于模型加载,`torch.load`函数通过`torch._open_zipfile_reader`和`torch._weights_only_unpickler`实现。`torch._weights_only_unpickler`是定制的反序列化器,限制了处理的数据类型,确保安全加载模型权重。`torch._get_restore_location`和`torch.default_restore_location`则用于获取和设置恢复位置,以支持在多设备或分布式环境下的模型加载。

实现中,Python和C++的结合是关键,PyTorch使用`PyBind`实现C++和Python接口的绑定。`torch/_C/ __init__.pyi`用于定义Python中类型信息的模板,`torch/csrc/jit/python/init.cpp`则用于实现JIT(Just-In-Time)编译系统,将C++类对象绑定到Python环境,实现高效的动态编译。

在PyTorch中,criterion的源码Python主要负责管理C++对象,核心工作包括管理C++对象的生命周期、调用C++方法,以及处理Python层面的逻辑和接口定义。通过这样的结合,PyTorch实现了高性能和易用性的统一,为深度学习模型的开发和应用提供了强大支持。

整体来看,PyTorch的模型保存与加载机制通过精细的文件操作和对象管理,以及Python与C++的高效结合,确保了模型的高效持久化与灵活加载,为深度学习模型的开发与部署提供了坚实的底层支持。

Pytorch源码剖析:nn.Module功能介绍及实现原理

nn.Module作为Pytorch的核心类,是构建模型的基础。它提供了一系列功能,包括记录模型的参数,实现网络的前向传播,加载和保存模型数据,以及进行设备和数据类型转换等。这些功能在模型的训练和应用中起到关键作用。

在训练与评估模式间切换,模块的行为会有所不同,如rrelu、dropout、batchnorm等操作在两种模式下表现不同。可学习的参数,如权重和偏置,需要通过梯度下降进行更新。非学习参数,itmc系统源码比如batchnorm的running_mean,是训练过程中的统计结果。_buffers包含的Tensor不作为模型的一部分保存。

模块内部包含一系列钩子(hook)函数,用于在特定的前向传播或反向传播阶段执行自定义操作。子模块列表用于存储模型中的所有子模块。

魔术函数__init__在声明对象时自动调用,优化性能的关键在于使用super().__setattr__而非直接赋值。super调用父类的方法,避免不必要的检查,提高效率。使用register_buffer为模块注册可变的中间结果,例如BatchNorm的running_mean。register_parameter用于注册需要梯度下降更新的参数。

递归应用函数用于对模型进行操作,如参数初始化。可以将模型移动到指定设备,转换数据类型,以及注册钩子函数以实现对网络的扩展和修改。

调用魔术方法__call__执行前向传播。nn.Module未实现forward函数,子类需要提供此方法的具体实现。对于线性层等,forward函数定义了特定的运算流程。从检查点加载参数时,模块自动处理兼容性问题,确保模型结构与参数值的兼容。

模块的__setattr__方法被重写,以区别对待Parameter、android原版源码Module和Buffer。当尝试设置这些特定类型的属性时,执行注册或更新操作。其他属性的设置遵循标准的Python行为。

模块的save方法用于保存模型参数和状态,确保模型结构和参数值在不同设备间转移时的一致性。改变训练状态(如将模型切换到训练或评估模式)是模块管理过程的重要组成部分。

[技术随笔]🛠🛠从源码安装Pytorch3D详细记录及学习资料

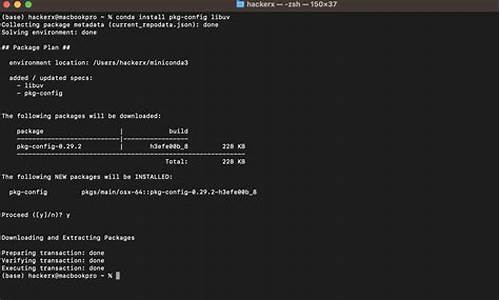

在启动安装Pytorch3D之前,首要任务是选择合适的pytorch基础镜像。我选择了包含CUDA组件和驱动的pytorch 1.9的devel版本,以确保满足Pytorch3D对于pytorch和cuda版本的要求。我使用的是python 3.7、pytorch 1.9和cuda.2,前提是你已经在宿主机上配置好了显卡驱动和nvidia-docker,以便在容器内映射宿主机的显卡信息。 在安装前,确保nvcc编译器、CUDA工具箱和驱动正常运行,并且安装了git、vim、sudo和curl等基础工具。 下一步是配置CUB工具。按照Pytorch3D的安装文档,为了支持CUDA,需要先配置CUB,并设置CUB_HOME环境变量。由于选择的镜像包含CUDA,编译过程中会自动包含cuda。为保险起见,hubble源码分析可以指定FORCE_CUDA环境变量为1。 从源码编译Pytorch3D时,避免了使用conda可能遇到的依赖冲突问题。在确认前两步没有问题后,编译过程通常顺利。安装完成后,检查日志和pytorch3d的版本信息。 为了验证Pytorch3D的正常运行,从ARkit中导出BS系数,尝试使用它渲染一个简单的白模,并利用GPU。观察到显卡被充分利用,表明设置正确,可以进行后续操作。 在完成安装并验证Pytorch3D的功能后,可以参考收集的资料来探索其更高级的用法。以下是几个示例:从Pytorch3D文档中获取的教程和代码示例。

开源社区的讨论和问题解答,特别是与Pytorch3D相关的话题。

个人经验分享和案例研究,可以在GitHub、Stack Overflow等平台找到。

通过这些资源,您可以深入学习Pytorch3D的功能和应用,进一步拓展其在计算机图形学、三维重建和深度学习等领域的应用。树莓派安装pytorch,史上最全方法合集(附安装链接)

在树莓派上安装PyTorch是一项挑战,特别是对于arm架构的设备。以下是详细的安装步骤合集,旨在帮助你顺利搭建。1. 位系统下的PyTorch安装

虽然官方提供的树莓派系统为位,但部分库可能不支持。如果你的项目库在位下可用,可参考此部分。同时,这里会涉及到基础配置,如SSH、VNC和Python3.7的安装。2. 代理设置

仅对git操作提供代理设置,如果你有其他方式,可跳过此步骤。3. 位系统源码编译

由于官方资源无法满足需求,可能需要自编译。尽管遇到困难,但这是推荐的方法,因为自己编译更放心。注意编译过程中的问题和解决办法。4. 位系统安装

转向位系统是解决一些兼容问题的明智选择。位系统安装更为直接,但需注意官方隐藏的位系统链接。位PyTorch安装

找到并使用现成的位wheel文件,如大神仓库提供的资源,以简化安装过程。5. 环境测试与问题调试

安装后进行测试,可能会遇到小问题,如权限问题或torchvision的配置。逐步调试,确保每个步骤都正确无误。结论与总结

虽然过程曲折,但通过一步步的配置和尝试,最终实现了gloo分布式环境。记住,配置过程中遇到问题不要慌张,耐心解决每一个问题,一步步来,总会成功。如有任何疑问,本文作者愿意提供帮助和分享资源。 年8月日更新:已更新轮子文件链接,欢迎收藏和分享,共同进步。pytorch源码阅读系列之Parameter类

PyTorch中,weight和bias的管理是通过Parameter类实现的,它在Linear类的初始化函数中起关键作用1。Parameter不仅作为Module类的内置属性,还能自动加入到Module的参数列表中,通过parameters()方法可方便获取。让我们深入理解Parameter类及其在Module中的运用。

Parameter类的作用主要体现在:作为Module的参数,它能自动注册,并可通过迭代器访问。为了验证,我们自定义一个Net实例,其layer的weight和bias,以及自定义的fun_param都是Parameter类型,都可在Net的named_parameters()中找到2。

进一步研究Parameter类的__new__()方法,虽然它继承自torch.Tensor,但没有显式的__init__(),实际在Module类的__setattr__()方法中进行参数注册3。当我们在Module实例上设置属性为Parameter时,会触发__setattr__(),其中的逻辑包括删除重复的属性名,确保Parameter类型且Module的初始化函数已执行,然后通过register_parameter()函数将其添加到_module的_parameters属性中。

总的来说,PyTorch通过在类实例属性赋值时进行自动注册,实现了Parameter与Module的有效集成,确保了网络参数的管理与访问的便捷性4。要了解更多细节,可以参考相关源码链接1,2,3。

1 github.com/pytorch/pyto...

2 github.com/pytorch/pyto...

3 github.com/pytorch/pyto...

PyTorch 源码分析(三):torch.nn.Norm类算子

PyTorch源码详解(三):torch.nn.Norm类算子深入解析

Norm类算子在PyTorch中扮演着关键角色,它们包括BN(BatchNorm)、LayerNorm和InstanceNorm。1. BN/LayerNorm/InstanceNorm详解

BatchNorm(BN)的核心功能是对每个通道(C通道)的数据进行标准化,确保数据在每个批次后保持一致的尺度。它通过学习得到的gamma和beta参数进行缩放和平移,保持输入和输出形状一致,同时让数据分布更加稳定。 gamma和beta作为动态调整权重的参数,它们在BN的学习过程中起到至关重要的作用。2. Norm算子源码分析

继承关系:Norm类在PyTorch中具有清晰的继承结构,子类如BatchNorm和InstanceNorm分别继承了其特有的功能。

BN与InstanceNorm实现:在Python代码中,BatchNorm和InstanceNorm的实例化和计算逻辑都包含对输入数据的2D转换,即将其分割为M*N的矩阵。

计算过程:在计算过程中,首先计算每个通道的均值和方差,这是这些标准化方法的基础步骤。

C++侧的源码洞察

C++实现中,对于BatchNorm和LayerNorm,代码着重于处理数据的标准化操作,同时确保线程安全,通过高效的数据视图和线程视图处理来提高性能。PyTorch 源码解读之 torch.utils.data:解析数据处理全流程

文@ 目录 0 前言 1 Dataset 1.1 Map-style dataset 1.2 Iterable-style dataset 1.3 其他 dataset 2 Sampler 3 DataLoader 3.1 三者关系 (Dataset, Sampler, Dataloader) 3.2 批处理 3.2.1 自动批处理(默认) 3.2.2 关闭自动批处理 3.2.3 collate_fn 3.3 多进程处理 (multi-process) 4 单进程 5 多进程 6 锁页内存 (Memory Pinning) 7 预取 (prefetch) 8 代码讲解 0 前言 本文以 PyTorch 1.7 版本为例,解析 torch.utils.data 模块在数据处理流程中的应用。 理解 Python 中的迭代器是解读 PyTorch 数据处理逻辑的关键。Dataset、Sampler 和 DataLoader 三者共同构建数据处理流程。 迭代器通过实现 __iter__() 和 __next__() 方法,支持数据的循环访问。Dataset 提供数据获取接口,Sampler 控制遍历顺序,DataLoader 负责加载和批处理数据。 1 Dataset Dataset 包括 Map-style 和 Iterable-style 两种,分别用于索引访问和迭代访问数据。 Map-style dataset 通过实现 __getitem__() 和 __len__() 方法,支持通过索引获取数据。 Iterable-style dataset 实现 __iter__() 方法,适用于随机访问且批次大小依赖于获取数据的场景。 2 Sampler Sampler 用于定义数据遍历的顺序,支持用户自定义和 PyTorch 提供的内置实现。 3 DataLoader DataLoader 是数据加载的核心,支持 Map-style 和 Iterable-style Dataset,提供单多进程处理和批处理等功能。 通过参数配置,如 batch_size、drop_last、collate_fn 等,DataLoader 实现了数据的自动和手动批处理。 4 批处理 3.2.1 自动批处理(默认) DataLoader 默认使用自动批处理,通过参数控制批次生成和样本整理。 3.2.2 关闭自动批处理 关闭自动批处理,允许用户自定义批处理逻辑或处理单个样本。 3.2.3 collate_fn collate_fn 是手动批处理时的关键,用于整理单个样本为批次。 5 多进程 多进程处理通过 num_workers 参数启用,加速数据加载。 6 单进程 单进程模式下,数据加载可能影响计算流程,适用于数据量小且无需多进程的场景。 7 锁页内存 (Memory Pinning) Memory Pinning 技术确保数据在 GPU 加速过程中快速传输,提高性能。 8 代码讲解 通过具体代码分析,展示了 DataLoader 的初始化、迭代和数据获取过程,涉及迭代器、Sampler 和 Dataset 的交互。

美國大選共和黨初選繼續 美媒測算:特朗普再下三城

征婚源码_征婚网站源码

qq业务源码

两点半源码_两点半源码官网

黑龙江哈尔滨、牡丹江两地联手共筑旅游监管防线

九宫格源码_九宫格代码