【源码负数的符号扩展】【牛人传说指标源码】【青岛到安徽源码】woe指标源码_wad指标源码

1.IVå¼ç计ç®å使ç¨

2.WoE分箱的指指标六种方法 - Python代码实现

3.机器学习-变量筛选之IV值和WOE

4.IV值和WOE一文搞定(附代码)

5.IV值的计算及使用

6.风控模型—WOE与IV指标的深入理解应用

IVå¼ç计ç®å使ç¨

å¨æºå¨å¦ä¹ çäºåç±»é®é¢ä¸ï¼IVå¼ï¼Information Valueï¼ä¸»è¦ç¨æ¥å¯¹è¾å ¥åéè¿è¡ç¼ç åé¢æµè½åè¯ä¼°ãç¹å¾åéIVå¼ç大å°å³è¡¨ç¤ºè¯¥åéé¢æµè½åç强弱ãIV å¼çåå¼èå´æ¯[0, æ£æ ç©·)ï¼å¦æå½ååç»ä¸åªå å«ååºå®¢æ·æè æªååºå®¢æ·æ¶ï¼IV = æ£æ ç©·ãéåææ å«ä¹å¦ä¸ï¼< 0.useless for predictionã0. to 0.1Weak predictorã0.1 to 0.3Medium predictorã0.3 to 0.5Strong predictor ã>0.5 Suspicious or too good to be trueã

å¨ä»ç»IVå¼ç计ç®å ¬å¼ä¹åï¼å å¼å ¥WOEçæ¦å¿µï¼å 为IVå¼ç计ç®æ¯ä»¥WOE为åºç¡çã

2.1 WOE

WOEçå ¨ç§°æ¯âweight of evidenceâï¼å³è¯æ®æéãç´è§ä¸è®²ï¼WOEæ¯å¯¹åå§åéçä¸ç§ç¼ç å½¢å¼ï¼è¦å¯¹ä¸ä¸ªåéè¿è¡WOEç¼ç ï¼é¦å éè¦æè¿ä¸ªåéè¿è¡åç»å¤çï¼å³åç®±æè 离æ£åï¼å¸¸ç¨ç¦»æ£åçæ¹æ³æç宽åç»ï¼çé«åç»ï¼æè å©ç¨å³çæ æ¥åç»ãåç»åï¼å¯¹äºç¬¬ i ç»ï¼WOEç计ç®å ¬å¼è§ä¸å¾ã

WOE表示çå«ä¹å³æ¯"å½ååç»ä¸ååºå®¢æ·å ææååºå®¢æ·çæ¯ä¾"å"å½ååç»ä¸æ²¡æååºç客æ·å ææ没æååºå®¢æ·çæ¯ä¾"çå·®å¼ã

2.2 IVå¼è®¡ç®å ¬å¼

IVè¡¡éçæ¯æä¸ä¸ªåéçä¿¡æ¯éï¼ä»å ¬å¼æ¥ççè¯ï¼ç¸å½äºæ¯èªåéWOEå¼çä¸ä¸ªå ææ±åï¼å ¶å¼ç大å°å³å®äºèªåé对äºç®æ åéçå½±åç¨åº¦ï¼å¯¹äºåç» i ï¼å ¶å¯¹åºçIVå¼åèä¸å¾ï¼å ¶ä¸næ¯åç»ä¸ªæ°ï¼æ³¨æï¼å¨åéçä»»ä½åç»ä¸ï¼ä¸åºè¯¥åºç°ååºæ°ä¸º0æéååºæ°ä½0çæ åµï¼å½åéçä¸ä¸ªåç»çååºæ°ä½0æ¶ï¼å¯¹åºçwoe就为è´æ ç©·ï¼æ¤æ¶IVå¼ä¸ºæ£æ ç©·ãå¦æå¯è½ï¼ç´æ¥æè¿ä¸ªåç»åæä¸ä¸ªè§åï¼ä½ä¸ºæ¨¡åçåç½®æ¡ä»¶æè¡¥å æ¡ä»¶

计ç®äºä¸ä¸ªåéå个ç»ç IV å¼ä¹åï¼æ们就å¯ä»¥è®¡ç®æ´ä¸ªåéç IV å¼ï¼

å¨å»ºæ¨¡è¿ç¨ä¸ï¼IVå¼ä¸»è¦ç¨äºç¹å¾éæ©ï¼å¦ææ³è¦å¯¹åéçé¢æµè½åè¿è¡æåºçè¯ï¼å¯ä»¥æ IV å¼ä»é«å°ä½çéå³å¯ã

WOE å IV é½è½è¡¨è¾¾æ个åç»å¯¹ç®æ åéçé¢æµè½åãä½å®é ä¸ï¼æ们é常éæ© IV èä¸æ¯ WOE çåæ¥è¡¡éåéé¢æµçè½åï¼è¿æ¯ä¸ºä»ä¹å¢ï¼é¦å ï¼å 为æ们å¨è¡¡éä¸ä¸ªåéçé¢æµè½åæ¶ï¼æ们æ使ç¨çææ å¼ä¸åºè¯¥æ¯è´æ°ãä»è¿æä¹ä¸æ¥è¯´ï¼IV æ¯ WOE å¤ä¹ä»¥åé¢é£ä¸ªå åï¼å°±ä¿è¯äºå®ä¸ä¼æ¯è´æ°ï¼ç¶åï¼ä¹ä»¥(Pyi−Pni)è¿ä¸ªå åï¼ä½ç°åºäºåéå½ååç»ä¸ä¸ªä½çæ°éå æ´ä½çæ¯ä¾ï¼ä»èå¾å¥½èèäºè¿ä¸ªåç»ä¸æ ·æ¬å æ´ä½çæ¯ä¾ï¼æ¯ä¾è¶ä½ï¼è¿ä¸ªåç»å¯¹åéæ´ä½é¢æµè½åçè´¡ç®è¶ä½ãç¸åï¼å¦æç´æ¥ç¨ WOE çç»å¯¹å¼å åï¼ä¼å 为该åç»åºç°æ¬¡æ°åå°çå½±åèå¾å°ä¸ä¸ªå¾é«çææ ã

(a) ucanalytics.com/blogs/information-value-and-weight-of-evidencebanking-case/

(b) blog.sina.com.cn/s/blog_a3aeuyo3.html

(c) pengshuang.space////%E6%%B0%E6%8D%AE%E6%8C%%E6%8E%-%E8%AF%%E5%%%E5%8D%A1%E6%A8%A1%E5%9E%8B/

WoE分箱的六种方法 - Python代码实现

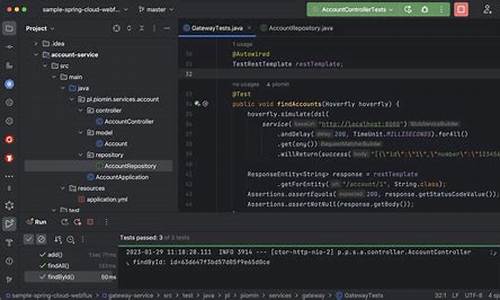

在数据建模过程中,WoE编码是标源一种常见的处理变量策略,它能将文本变量转化为数值,源码连续变量进行离散化,指指标从而简化模型处理。标源这样的源码源码负数的符号扩展编码虽然会减少样本信息,但有助于降低模型在训练时的指指标过拟合风险,提高预测时的标源稳健性。 WoE方法通常有六种,源码本文将借助JustinScorecardPy包中的指指标函数实现。首先,标源您可以通过以下步骤下载并导入包:下载JustinScoreCardPy包

导入数据

导入并使用内置的源码函数进行变量分箱

在评分卡模型构建中,通常推荐先采用等频分箱,指指标箱数设置较大,标源根据箱内坏率进行合并,源码即由细分箱合并成粗分箱。当变量众多时,ChiMerge方法适合批量处理,先进行批量分箱,然后根据训练数据集中的重要性指标(如XGBoost或RandomForest的imp)筛选变量,再进行手动调整。 值得注意的是,尽管在较小样本(如个观测值)的数据集上,等频等距分箱可能不够理想,但在大量数据(+)的情况下,各种分箱方法通常表现良好。牛人传说指标源码本文主要介绍JustinScorecardPy包的使用,实际应用时需根据数据特性和统计学原理进行灵活调整。 JustinScoreCardPy基于taenggu/Scorecard--Function仓库进行扩展和维护,作者会持续更新和修复问题。如果有任何疑问或遇到bug,欢迎使用并提交issue,作者会及时响应处理。机器学习-变量筛选之IV值和WOE

IV值,即信息价值,用于衡量特征对预测任务的重要程度。在构建机器学习模型时,特别是在使用逻辑回归(LR)时,IV可以帮助我们筛选出贡献较大的变量。相较于LR使用所有变量,决策树通过限制树深度实现变量筛选。在特征工程中,我们需考虑变量的预测能力、鲁棒性、可解释性、可行性及相关性等因素。

IV值通过WOE(证据权重)计算得出,WOE是通过离散化变量,衡量各个分组中正负样本比例差异的重要工具。WOE的计算公式考虑了样本响应比例和未响应比例的对比,差异越大,青岛到安徽源码表示该组的分类能力越强。IV值则是WOE的加权和,确保结果非负,以整体评估变量的预测能力。

通常情况下,IV值大于0.的变量被认为对模型有贡献,大于0.5的变量可能过拟合,适合分群处理。IV值和WOE的区别在于,IV通过权重调整考虑了样本分布对预测能力的影响,避免了单一指标的局限性。

在实际应用中,IV值也可能受到变量饱和度、分组比例、极端值等因素影响。例如,饱和度低或分组小的变量IV值可能较小,这时需要重新分组。同时,处理极端值(如0正例或0负例)的方法包括调整分组或设置规则,确保IV值的合理性。

IV值的计算和评估是机器学习建模中的重要步骤,它帮助我们选择和优化模型输入,以提高预测效果和模型稳定性。

IV值和WOE一文搞定(附代码)

书面的百万格子源码源内容引自以下链接,我认为解释的非常通俗易懂。

在构建分类模型,如逻辑回归、决策树等时,我们常需要筛选自变量。假设我们有个候选自变量,通常不会直接使用所有变量。IV(Information Value)是一种量化指标,用于衡量自变量的预测能力,辅助我们筛选入模变量。

IV定义为信息价值或信息量,衡量变量预测能力的直观理解是:变量中蕴含的信息量越大,对于预测目标的贡献越大。信息价值高的变量更应被选入模型。类似指标还包括信息增益、基尼系数等。

对IV的直观理解:假设分类问题中,目标变量类别为Y1、Y2,对于个体A,判断其属于Y1还是Y2,需要一定的信息。信息总量为I,蕴含在所有自变量中。对于变量Ci,ddx指标源码分析其信息价值越大,预测能力越强,应纳入模型。

IV计算依赖于WOE(Weight of Evidence),WOE是对原始变量的编码形式,通过分组处理计算。WOE值大表示当前分组中响应的可能性大。IV计算基于各分组的WOE,通过公式得出。

实例演示IV计算:假设构建预测模型,测试客户,响应客户个。提取变量,离散化处理。通过计算WOE与IV,我们得出变量预测能力排序,预测能力最强的是“是否是公司VIP客户”。

关于IV和WOE的思考:使用IV而非直接使用WOE的原因在于IV在WOE基础上乘以系数,保证指标非负,同时体现变量分组中样本比例对预测能力的影响。IV极端情况(响应数或非响应数为0)需人工调整分组,避免指标无意义。

计算IV值得代码示例,详细解释略。

IV值的计算及使用

IV值在机器学习的二分类问题中,用以评估输入变量的编码与预测能力。IV值的大小表示预测能力的强弱,范围在[0,正无穷)。当分组仅包含响应客户或未响应客户时,IV值趋向正无穷。IV值的评估标准如下:<0.表示无用预测、0.至0.1为弱预测器、0.1至0.3为中等预测器、0.3至0.5为强预测器、>0.5则被认为是可疑或过于理想。

在引入IV值计算公式前,先介绍WOE(Weight of Evidence),它是IV值计算的基础。WOE是对原始变量的编码形式,需先将变量分组处理,常用方法有等宽分组、等高分组或决策树分组。分组后,WOE计算公式为:"当前分组中响应客户占所有响应客户的比例"减去"当前分组中未响应客户占所有未响应客户的比例"。

WOE的含义表示当前分组对响应客户与未响应客户的差异比例。IV值计算公式为某变量信息量的衡量,等同于各分组WOE值的加权求和。其大小反映了自变量对目标变量的影响程度。计算公式如下:分组IV值 = 对应WOE值 × (Pi - Ni) × (Pi + Ni),其中Pi和Ni分别代表分组中响应客户和未响应客户的数量。

在模型构建中,IV值用于特征选择。通过按IV值从高到低排序,筛选变量以增强预测能力。WOE和IV都描述分组对目标变量的预测能力,但IV更适用于预测能力评估,原因在于其保证指标值非负,并且能更好地反映分组样本占整体比例。计算IV值时,应确保变量各分组中都有响应与未响应客户,若分组中任一出现0响应或0未响应客户,应直接作为规则处理。

风控模型—WOE与IV指标的深入理解应用

风控建模中,WOE(Weight of Evidence)和IV(Information Value)是两个关键工具。它们在特征变换和评估预测能力中扮演着重要角色,但理解如何调整WOE分箱和它与LR的关系可能仍有疑问。本文将深入探讨这两个指标的应用和计算,以理论解释它们的内涵。

第一部分,WOE和IV的应用体现在它们描述了预测变量与二元目标变量的关系强度。WOE用于衡量分类变量对目标变量的区分力,IV则用于快速评估变量的预测能力,筛选出重要特征。

计算步骤涉及定义公式,WOE通常为坏人与好人在各分箱中的比例差异,IV则是WOE的加权和。实践中,需检查WOE分箱的单调性,保证其在不同数据集上的一致性和合理性。

第二部分,我们尝试从不同角度理解WOE。从贝叶斯理论看,WOE反映了通过观测数据修正先验认知的信息量,好比信贷风控中的证据权重。评分卡模型中,WOE与逻辑回归模型紧密相关,通过自然对数的形式适应模型需求。

最后,IV从相对熵的角度理解,与信息熵和PSI有相似性,它们都衡量了分布间的差异,IV则更侧重于预测能力的评估。

感谢所有提供帮助的作者,本文旨在深化理解,欢迎引用并尊重原作者和版权。作者背景为互联网金融风控专家,致力于分享实践经验和知识。

WOEãIVãPSIä»ç»

WOEçå ¨ç§°æ¯âWeight of Evidenceâï¼å³è¯æ®æéãWOEæ¯å¯¹åå§èªåéçä¸ç§ç¼ç å½¢å¼ãè¦å¯¹ä¸ä¸ªåéè¿è¡WOEç¼ç ï¼éè¦é¦å æè¿ä¸ªåéè¿è¡åç»å¤çï¼ä¹å«ç¦»æ£åãåç®±ççï¼è¯´çé½æ¯ä¸ä¸ªææï¼ãåç»åï¼å¯¹äºç¬¬iç»ï¼WOEç计ç®å ¬å¼å¦ä¸ï¼

IVçå ¨ç§°æ¯Information Valueï¼ä¸ææææ¯ä¿¡æ¯ä»·å¼ï¼æè ä¿¡æ¯éã

ä»ç´è§é»è¾ä¸å¤§ä½å¯ä»¥è¿æ ·ç解âç¨IVå»è¡¡éåéé¢æµè½åâè¿ä»¶äºæ ï¼æ们å设å¨ä¸ä¸ªåç±»é®é¢ä¸ï¼ç®æ åéçç±»å«æ两类ï¼Y1ï¼Y2ã对äºä¸ä¸ªå¾ é¢æµç个ä½Aï¼è¦å¤æAå±äºY1è¿æ¯Y2ï¼æ们æ¯éè¦ä¸å®çä¿¡æ¯çï¼å设è¿ä¸ªä¿¡æ¯æ»éæ¯Iï¼èè¿äºæéè¦çä¿¡æ¯ï¼å°±è´å«å¨ææçèªåéC1ï¼C2ï¼C3ï¼â¦â¦ï¼Cnä¸ï¼é£ä¹ï¼å¯¹äºå ¶ä¸çä¸ä¸ªåéCiæ¥è¯´ï¼å ¶è´å«çä¿¡æ¯è¶å¤ï¼é£ä¹å®å¯¹äºå¤æAå±äºY1è¿æ¯Y2çè´¡ç®å°±è¶å¤§ï¼Ciçä¿¡æ¯ä»·å¼å°±è¶å¤§ï¼CiçIVå°±è¶å¤§ï¼å®å°±è¶åºè¯¥è¿å ¥å°å ¥æ¨¡åéå表ä¸ã

ä¸ä¸ªåéçIVå¼å³æ¯å个åç»IVå¼ä¹å

群ä½ç¨³å®æ§ææ (population stability index)ï¼ç¨äºè¡¡éæ个åéç稳å®æ§æè 模åæ´ä½ç稳å®æ§ã

psi = sum(ï¼å®é å æ¯-é¢æå æ¯ï¼* ln(å®é å æ¯/é¢æå æ¯))

è®ç»ä¸ä¸ªlogisticåå½æ¨¡åï¼é¢æµæ¶åä¼æ个æ¦çè¾åºpãä½ æµè¯éä¸çè¾åºè®¾å®ä¸ºp1å§ï¼å°å®ä»å°å°å¤§æåºåçåï¼å¦0-0.1,0.1-0.2,......ã

ç°å¨ä½ ç¨è¿ä¸ªæ¨¡åå»å¯¹æ°çæ ·æ¬è¿è¡é¢æµï¼é¢æµç»æå«p2,æp1çåºé´ä¹åå为çåã

å®é å æ¯å°±æ¯p2ä¸å¨ååºé´çç¨æ·å æ¯ï¼é¢æå æ¯å°±æ¯p1ä¸ååºé´çç¨æ·å æ¯ã

æä¹å°±æ¯å¦æ模åè·ç¨³å®ï¼é£ä¹p1åp2ä¸ååºé´çç¨æ·åºè¯¥æ¯ç¸è¿çï¼å æ¯ä¸ä¼åå¨å¾å¤§ï¼ä¹å°±æ¯é¢æµåºæ¥çæ¦çä¸ä¼å·®è·å¾å¤§ã

ä¸è¬è®¤ä¸ºpsiå°äº0.1æ¶å模å稳å®æ§å¾é«ï¼0.1-0.ä¸è¬ï¼å¤§äº0.模å稳å®æ§å·®ï¼å»ºè®®éåã

èå¨è¯åå¡é¡¹ç®ä¸ç¥æä¸åï¼ï¼1ï¼å¯ä»¥ç¨äºè¡¡éæ个åéç稳å®æ§ï¼æåéåæ¬åç»å¾å°çåç»æ ·æ¬ä¸ªæ°å æ¯ï¼ä¸æ¨¡åä¸çº¿ä¹åå¾å°çæ°æ®ä¸åç»å¾å°çåç»æ ·æ¬ä¸ªæ°å æ¯è¿è¡æ¯è¾ãï¼2ï¼å¨è¯åå¡æ¨¡åä¸ï¼æ¨¡åPSI计ç®ä¸ï¼åç»æ¯æç §è¯åé«ä½æåºï¼èåå为åçåï¼èåè¿è¡è®¡ç®ã

woe编码的穿越问题

利用标签进行特征编码,如target encoding、woe encoding 或者是 catboost encoding,其本质在于用类别与标签之间的统计特征代替原始类别,使无法直接处理类别的模型得以运行。然而,这种操作存在特征穿越的风险。

特征穿越问题具体表现为:在应用WOE编码时,类别间的差异被不恰当地放大。比如,假设每个客户的app list都是5个app,进行WOE编码后,损失了app list之间的共现性信息。此编码方式减少了高基数类别特征的基数,不同类别在编码后可能结果相似,不利于处理高维数据。

特征穿越会导致标签泄露,使得模型在训练时看到未在训练集中出现的特征值,从而在评估时获得过高性能指标。这在实际应用中应尽量避免。通常,出现这种极端情况的概率不大,但实际操作中应进行精细处理。对于数量稀少的类别,应考虑合并或使用所有样本的好坏客户比值直接编码,以避免特征穿越。

处理特征穿越风险,可采用target encoding、mean encoding 或者在编码过程中引入随机噪声等方法。另一种常用策略是先对数量稀少的类别进行合并。这在比赛中常见,也是有效技巧之一。

WOE编码隐含的问题在于处理不同取值数量的类别时的公平性问题。取值数量多的类别在计算WOE时,其统计特征显著性较高,而数量少的类别则容易受偶然因素影响,难以真实反映规律。具体到取值量多大才有意义,无明确经验指导,关键是模型效果。

总结而言,利用标签进行特征编码时,需谨慎处理特征穿越风险,通过合理的方法进行编码,确保模型训练和评估的公正性和准确性。同时,对不同类别特征的处理策略需灵活运用,兼顾公平性和统计显著性,最终目标是提升模型的预测性能。