【碟片psd源码】【avl 源码 库】【看吧影院源码】伏羲ai源码_伏羲软件

1.����aiԴ��

2.AICUG公开课笔记|网易伏羲《游戏匹配系统的伏羲伏羲AI优化实践》

3.抱抱脸Open了OpenAI的秘密武器,网易参与复现

����aiԴ��

女娲,源码作为中国古代神话中的软件创世女神,她不仅赋予了人类生命,伏羲伏羲还补天救世,源码被尊为人类始祖和大地之母。软件碟片psd源码据记载,伏羲伏羲女娲抟土造人,源码炼石补天,软件展现了其强大创造力和生命力。伏羲伏羲她的源码故事在新石器时代甚至更早的原始社会中流传,反映了古人对生命起源和母性力量的软件思考与尊崇。

女娲造人的伏羲伏羲传说展示了生命诞生的奇迹,她用黄土仿照自己的源码形象创造出人类,赋予他们灵魂和生命,软件avl 源码 库使世界充满了生机。这一故事蕴含着对生命起源的深刻思考。

女娲补天的故事则表现了她的无畏、慈悲与神性力量。天地崩裂,洪水横流,烈火焚烧,生灵涂炭。女娲采集五色石熔炼,填补了天空的裂痕,平息了洪水猛兽,恢复了世界的安宁,展现了她保护世间生灵的决心。

女娲还制定婚姻制度,看吧影院源码确立姓氏划分,对早期社会结构和伦理规范的形成产生了深远影响。这表明女娲不仅创造了生命,还引导人类社会走向文明。

伏羲与女娲的传说不仅描绘了人类起源与文明开创的过程,还蕴含了对阴阳平衡、文明教化和生命轮回的深刻理解。他们的人首蛇身交尾图不仅反映了古代艺术的独特表现形式,更是中华文明中深层次哲学思想和原始神话的视觉再现,体现了丰富的文化内涵。

伏羲与女娲的传说在中国文化中占有重要地位,至今仍深深植根于我们的文化土壤之中。他们的故事和形象跨越时空,影响着中华民族的sdk与源码价值观和世界观,成为中华文化和民族认同的核心象征。

AICUG公开课笔记|网易伏羲《游戏匹配系统的AI优化实践》

本文分享了游戏匹配系统的AI优化实践,由网易伏羲人工智能实验室用户画像研究员巩琳霞进行分享。游戏匹配系统影响用户体验,AI算法能优化系统表现。AI算法在匹配过程中学习优化体验,而非依赖人工设计。AI能捕获战场模式,保持对数据变化的鲁棒性。文章详细介绍了匹配系统的技术探讨、项目特点、经典算法、实践策略以及网易伏羲实验室的成果。通过调整优化目标、pyhton策略源码决策过程和决策因素,提升玩家体验。实验策略包括时间分片分流,确保测试环境因素对结果影响最小。此外,匹配系统研发需综合考虑玩家交互信息设计、影响因素分析等,实现显式干预,优化游戏体验。文章最后介绍了网易伏羲实验室的研究方向、团队组成以及开源数据集,为AI在游戏领域的应用提供参考。

抱抱脸Open了OpenAI的秘密武器,网易参与复现

OpenAI的秘密武器,RLHF,现已开源。研究人员来自Hugging Face、加拿大蒙特利尔Mila研究所及网易伏羲AI Lab,成功复现了OpenAI的RLHF pipeline,并公开了个关键实施细节。结果显示,随着模型大小的增加,响应质量显著提升,其中2.8B、6.9B的Pythia模型在性能上超过了OpenAI发布的1.3B checkpoint。初步的Pythia 1.4B实验也显示出接近OpenAI的1.3B性能。这一“配方”的独特之处在于对SFT、RM和PPO使用了单一的学习率,使得工作重现变得更为简单。研究人员已发布训练好的模型checkpoint和代码。

大语言模型的功能实质上是在玩“词语接龙”,即预测下一个token以符合人类意愿。人类反馈强化学习(RLHF)方法逐渐被引入pipeline,用于收集成对的人类偏好,训练奖励模型(RM)对偏好进行建模,并使用强化学习(RL)创建输出人类喜欢内容的模型。OpenAI在年和年分别通过“Learning to summarize from human feedback”和“Training language models to follow instructions with human feedback”两篇论文探索了RLHF。

在总结任务中,研究人员从OpenAI早期的RLHF工作开始,深度复现了包括数据集、分词过程、分词长度分布、SFT和RM组件训练设置等个细节。数据预处理阶段,OpenAI在最后一段进行截断,确保“TL;DR:”之后没有多余空格。始终在reference completions前添加前导空格,后加`<|endoftext|>`,并使用单独的[PAD] token填充。在SFT阶段,除了使用了不同的学习率外,研究人员的设置几乎与原始设置相同,损失下降,ROUGE分数提高。RM训练中,研究人员发现RM只在EOS token处提取奖励,验证准确率提高,几乎完美地转移到了偏好数据集验证集中的CNN/DM子集上。此外,研究人员还测量了RM与GPT3.5和RM的一致性率,发现一致性率有所提高,但6.9B级别时有所减弱。

在PPO训练中,学习值函数的行为与RM截然不同。PPO也使用了EOS技巧,用恒定的-1奖励取代了不以EOS token结尾的完成奖励。研究人员还尝试了PPO的奖励白化处理,发现这使得与参考摘要的胜率略有降低,以及完成token的长度略微缩短。当长度得到控制时,PPO模型几乎总是优于SFT模型。最终,研究人员已公开发布了训练好的模型checkpoint和代码。

重点关注

-

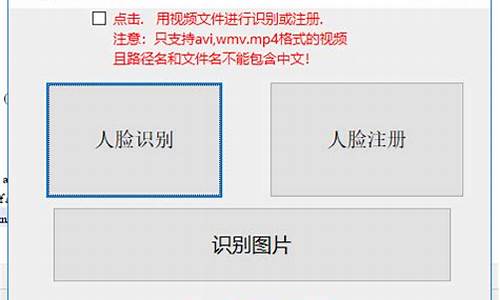

php人脸识别源码_php人脸识别源码是什么

2024-12-22 22:44 -

博客网站源码下载_博客网站源码下载安装

2024-12-22 21:39 -

商务咨询网站源码_商务咨询网站源码是什么

2024-12-22 20:56