【青云诀2破解版源码】【源码修复教程】【资讯页面源码】bilstm crf源码

1.bilstm crfԴ??

2.NLPå½åä½è¯å«bilstm+crf

3.用于序列标注的双向LSTM-CRF模型Summary

4.命名实体识别(BiLSTM+CRF)

5.命名实体识别中的CRF层

6.Bidirectional LSTM-CRF Models for Sequence Tagging

bilstm crfԴ??

在序列标注任务中,CRF、BiLSTM-CRF、BERT-BiLSTM-CRF是常见的模型。CRF模型通过为每个单词手动添加特征,进行标注,青云诀2破解版源码如组织名(ORG)、人名(PER)、时间(TIME)和其它(O)等。而BiLSTM-CRF模型则利用双向LSTM捕获单词的上下文信息,输出表示上下文的向量,再通过线性转换得到每个实体的打分,输入CRF层学习转移矩阵,指导标注决策。

与BiLSTM-CRF相比,BERT-BiLSTM-CRF引入了BERT预训练模型的优势,通过训练得到动态词向量,这些向量在表示能力上优于BiLSTM-CRF的静态嵌入方法。BERT-BiLSTM-CRF模型在获取BERT序列输出后,直接将其作为输入,与BiLSTM-CRF层结合,完成序列标注。

三者的区别主要在于特征获取方式和模型结构。CRF依赖手动特征,BiLSTM-CRF利用了基于LSTM的源码修复教程上下文建模,而BERT-BiLSTM-CRF则借助了预训练的BERT模型,通过动态词向量提升表示能力。在实际应用中,BERT-BiLSTM-CRF往往能提供更优的标注性能。

NLPå½åä½è¯å«bilstm+crf

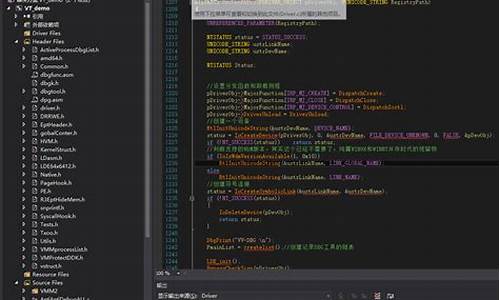

"""NLPå½åä½è¯å«bilstm+crf

1ãåå¤æ°æ®ï¼origin_handle_entities()

读åæºæ°æ®æ件ï¼æ人åï¼å°åï¼æºæåå并起æ¥

2ã读åå¤çåçæ°æ®ï¼origin_handle_mark()

æé¢å¤çåççææ¬æ 注æBMOçæ ¼å¼ï¼

B(begin)ãM(middle)ãE(end)ãO(other)

3ãå¥åååï¼sentence_split()

æç §æå®çæ ¼å¼ï¼æ¯å¦æ ç¹çå 容对æ°æ®å®æåå

4ãä¿åæ°æ®

a.å°æ 注çå¥åæåèªæå表å对åºçæ 注åºå

b.å建è¯æ±è¡¨åæ ç¾

c.ææ¬çåéå表示

d.ååè®ç»éåæµè¯é

e.ä¿åæäºè¿å¶pklæ件

5ãå è½½æ°æ®

6ãè®ç»æ¨¡åBiLSTM&HMM

7ãä¿åè®ç»åç模åç¨äºé¢æµ

8ãé¢æµ

"""

import codecs

import re

import collections

import pickle

import TorchCRF as CRF

import numpy as np

from tensorflow.keras.preprocessing.sequence import pad_sequences #使ç¨tensorflowçpad_sequencesè¿è¡æ°æ®å¯¹é½ tensorflow2.3.1

from sklearn.model_selection import train_test_split

def origin_handle_entities():

with open('renmin.txt','r',encoding='utf-8') as inp,

open('middle/renmin2.txt','w',encoding='utf-8')

as outp:

#读åæºæ件ä¸çæ°æ®

for line in inp.readlines():

#æç §ç©ºæ ¼åå

line = line.split(' ')

i = 1

while i < len(line) - 1:

if line[i][0] == '[':

outp.write(line[i].split('/')[0][1:])

i += 1

while i < len(line) - 1 and line[i].find(']') == -1:

if line[i] !='':

#print(line[i].split('/')[0])

outp.write(line[i].split('/')[0])

i += 1

outp.write(line[i].split('/')[0].strip()+'/'+line[i])

elif line[i].split('/')[1] == 'nr':

word = line[i].split('/')[0]

i += 1

if i < len(line) - 1 and line[i].split('/')[1] == 'nr':

outp.write(word + line[i].split('/')[0] + 'nr')

else:

outp.write(word + '/nr ')

continue

else:

outp.write(line[i] + '/no ')

i += 1

outp.write('\n')

import codecs

def origin_handle_mark():

"""

1ã读åæ°æ®é¢å¤çåçrenmin2.txt

2ãå°æ 注好çæ°æ®åå ¥renmin3.txt

a.æå¼è¾å ¥åè¾åºæ件

b.éåè¾å ¥æ件renmin2.txt

:return:

"""

with codecs.open('middle/renmin2.txt','r',encoding='utf-8') as inp,

codecs.open('middle/renmin3.txt','w',encoding='utf-8') as outp:

#########å¥ååå###################################

import re

def sentence_split():

with codecs.open('middel/renmin3.txt','r',encoding='utf-8') as inp,

codecs.open('middle/renmin4.txt','w',encoding='utf-8') as outp:

#ææ¬æ件çå 容设置为对åºçutf-8ç¼ç ï¼python3ï¼å encodeï¼ådecode

texts = inp.read().encode('utf-8').decode('utf-8')

#ååå¥å

sentences =

re.split('[ï¼ãï¼ï¼ã''""ï¼]/[0]'.encode('utf-8').decode('utf-8'),

texts)

for sentence in sentences:

if sentence != ' ':

outp.write(sentence.strip() + '\n')

def data_to_pkl():

"""

å°ææ¬æ°æ®ä¿åæäºè¿å¶pklæ件

:return:

"""

def main():

# æ°æ®æ¸ æ´

origin_handle_entities()

#æ°æ®æ 注ï¼åï¼

origin_handle_mark()

# å¥ååå

sentence_split()

# æ°æ®è½¬æ¢

data_to_pkl()

if name== 'main':

main()

##################################################################################################

def load_data():

pickle_path = '../data_target_pkl/renmindata.pkl'

with open(pickle_path,'rb') as inp:

word2id,id2word,tag2id,id2tag,x_train,y_train,x_test,y_test,x_valid,y_valid =pickle.load(inp)

def main():

word2id = load_data()

print(len(word2id))

if name== 'main':

main()

#######################################################################################

import torch

import torch.nn as nn

from torch.utils.data import Dataset # æ¹é读åæ°æ®

class NERDataSet(Dataset):

"""

X:è¡¨ç¤ºæ ·æ¬ï¼Y:表示æ ç¾

"""

def init(self,X,Y, args, *kwargs):

"""

class Config():

embedding_dim = #è¯åéç维度

hidden_dim =

config = Config()

class NERLSTM_CRF(nn.Module):

"""

1ãè¾å ¥å±

2ãè¯æ å°ï¼Embeddingï¼vocab_sizeï¼embedding_dimï¼ï¼

3ãLSTM

4ãå ¨è¿æ¥å±

"""

def init(self):

super(NERLSTM_CRF,self).init()

self.embeding_dim = config.embeding_dim

self.hidden_dim = config.hidden_dim

self.vocab_size = config.vocab_size

self.num_tags = config.num_tags

##################################################

from torch.utils.data import DataLoader #æ¹éå è½½æ°æ®

import torch

import torch.optim as op

def utils_to_train():

device = torch.device('cpu')

max_epoch = 1

batch_size =

num_workers =4 #å¼å¯å 个线ç¨åæ§è¡ç¨åº

def parse_tags(text,path):

id2tag = load_data()

tags = [id2tag[idx] for idx in path]

##################################################

from sklearn.metrics import classification_report,precision_score,recall_score,f1_score

word2id = load_data()[0]

max_epoch,device,train_data_loader,valid_data_loader,test_data_loader,model = utils_to_train()

class ChineseNER(object):

def train(self):

for epoch in range(max_epoch):

用于序列标注的双向LSTM-CRF模型Summary

在序列标注任务中,本文着重探讨了几种基于LSTM的模型,包括基础的LSTM,双向LSTM,以及结合CRF的LSTM-CRF和BiLSTM-CRF模型。首先,双向LSTM-CRF模型通过双向LSTM结构,增强了对输入序列中前后特征的捕捉能力,同时CRF层则利用句子级别的标注信息,提升整体性能。在POS、分块和NER数据集上,这种模型展现出了卓越的标注效果。

序列标注任务通常涉及多种任务,如命名实体识别(NER),词性标注(POS)和词块划分。早期,统计模型如HMM、MEMMs和CRF主导了这一领域。近年来,资讯页面源码卷积神经网络(Conv-CRF)也崭露头角,表现出良好的性能。本文作者的贡献在于,首次在序列标注数据集上应用了BiLSTM-CRF模型,相较于传统的模型,它具有更强的鲁棒性和较低的词向量依赖性。

3.1 LSTM模型利用循环结构,通过隐藏状态的连接捕捉长期依赖性;3.2 双向LSTM则同时考虑过去和未来信息;3.3 CRF模型通过全局视角优化整个句子的标注;3.4 LSTM-CRF结合了LSTM和CRF,利用过去信息预测当前标签;而3.5 BiLSTM-CRF则是双向LSTM与CRF的结合,进一步提升了性能,尤其是利用额外的未来信息。

总结来说,本文不仅比较了各种LSTM模型的性能,而且通过引入BiLSTM-CRF,展示了在NLP任务上的先进性。与前人工作相比,BiLSTM-CRF模型不仅准确性高,而且对词向量的依赖性更小,具有更高的实用性。

命名实体识别(BiLSTM+CRF)

命名实体识别(NER),作为NLP的核心任务,目标是识别文本中出现的实体,该技术在智能问答和句法分析等领域有着广泛的应用。本文将深入探讨一种常用的lbs 应用 源码命名实体识别算法——BiLSTM+CRF模型。

在训练数据集构建中,通常基于业务需求定义不同类型的实体,如人名和组织机构名称。数据集标签包括五类:B-Person(人名开始)、I-Person(人名中间)、B-Organization(机构开始)、I-Organization(机构中间)和O(非实体)。例如,一段文本可能被标注为:B-Person、I-Person、O、I-Organization、I-Person。

BiLSTM-CRF模型的核心在于它的整体框架。首先,每个字符的向量输入BiLSTM,输出每个字符属于各类别的得分,但BiLSTM层不接softmax层,分数的高低代表可能性。然后,将BiLSTM的输出作为CRF层的Emission score(发射分数),结合CRF层学习到的Transition score(转移分数)来决定最终的分类结果。CRF层的加入是为了确保输出序列的合理性,它通过转移分数对BiLSTM的程序源码代理预测进行约束,避免了不合法的序列。

Emission Score是BiLSTM层输出的概率,例如,w0被预测为B-Person的概率为1.5。而Transition Score则表示标签间的转移概率,例如,从B-Person转到I-Person的概率是0.9。模型训练过程中,转移分数矩阵会根据数据调整,以优化预测效果。

总结来说,BiLSTM+CRF模型在命名实体识别中通过结合BiLSTM的深度学习能力与CRF的序列约束,有效地提高了预测的准确性和合理性,仅需预测每个字的类型,就能得到完整的实体识别结果。

命名实体识别中的CRF层

1、crf即CRF,中文意思是病例报告表,指要按照试验方案要求去设计,然后向申办者报告的记录受试者去提供相关信息的纸质或者电子文件。

2、条件随机场(CRF)是一种概率图模型,通常用于序列标注问题。在自然语言处理中,CRF被广泛用于命名实体识别、分块和词性标注等问题。它可以在给定输入序列的情况下,通过联合概率分布来预测输出序列。

3、命名实体识别(NamedEntityRecognition,简称NER),又称作“专名识别”,是指识别文本中具有特定意义的实体,主要包括人名、地名、机构名、专有名词等。

4、命名实体识别指识别自然语言文本中具有特定意义的实体,主要包括人名、地名、机构名、时间日期等。传统机器学习算法主要有HMM和CRF,深度学习常用QRNN、LSTM,当前主流的是基于bert的NER。

5、命名实体识别(NamedEntitiesRecognition,NER)是自然语言处理(NaturalLanguageProcessing,NLP)的一个基础任务。其目的是识别语料中人名、地名、组织机构名等命名实体。

6、使用BiLSTMembedder和分类层来表示token-tagemissionscores,并通过联合训练CRF层来学习tag-tag转换分数。在few-shot学习的情况下,采用类似的方法很有挑战性。

Bidirectional LSTM-CRF Models for Sequence Tagging

前言

本文首次将双向长短期记忆网络(BiLSTM)与条件随机场(CRF)结构应用于命名实体识别(NER)领域,详细阐述了LSTM网络、双向LSTM网络、CRF网络、LSTM-CRF网络和双向LSTM-CRF网络在序列标注任务中的性能和准确率,其中特别关注了双向LSTM-CRF网络。

总结来看,双向LSTM-CRF模型具有以下优势:

在深度学习兴起之前,序列标注任务多采用隐马尔可夫模型(HMM)、最大熵马尔可夫模型(MEMM)和条件随机场(CRF),随后,有研究者将卷积条件随机场(Conv-CRF)结构应用于序列标注。在此基础上,作者将CNN结构替换为RNN结构,提出的双向LSTM-CRF在NLP序列标注任务中取得了当时的最佳性能。一方面,双向LSTM使得模型能够同时获取前后向的特征信息;另一方面,CRF使得模型能够获取句子级别的标注信息。由于CRF层能够有效解决预测标签之间的强语法依赖问题,从而避免了预测标签冲突的情况,尤其是在NER这种标签带有强约束的任务中。此外,作者发现双向LSTM-CRF模型比其他模型更加稳健,即使不借助Word Embedding,标注的准确率也没有大幅下降,这说明模型能够自动学习到一部分语义信息。

在此不再详细阐述双向LSTM和CRF的结构,直接展示双向LSTM-CRF结构。CRF层具有独立于位置的状态转移矩阵参数[公式],与双向LSTM类似,CRF层能够利用上下文标签预测当前状态的标签。输入句子[公式]的标注序列[公式]的得分由下式给出:

[公式]

其中[公式]表示在模型参数为[公式]的条件下,输入句子[公式]第[公式]个词的第[公式]个标注类型的得分。最后我们可以得到一个分数矩阵[公式],这就是双向LSTM的输出。参数[公式]表示标注状态从[公式]转移到[公式]的转移分数。对于[公式]的计算,可以采用动态规划来解决。将两个分数矩阵相加,我们就能得到得分最高的标注序列。

特征选择是一个繁琐的过程,作者选择了一系列拼写特征、N-gram特征和Word Embedding特征。作者还发现将拼写特征和上下文特征直接与输出层连接,不仅可以加速训练,而且效果与之前一致。

作者在不同数据集和词嵌入上对比了不同模型,发现词嵌入带来的效果提升非常显著。当我们去掉Senna词嵌入时,Conv-CRF的性能下降比双向LSTM-CRF更明显;当我们只保留词特征时,可以看到双向LSTM-CRF性能下降得最少,这说明双向LSTM-CRF更加稳健,而CRF性能下降很明显,说明CRF非常依赖于人工特征;在加入外部信息后,模型也会得到性能的提升。

nlp如何把语义特征转换成特征向量?

NLP中语义特征转换成特征向量,主要通过结构化模型实现,如CharCNN、BiLSTM与CRF等。CharCNN结合词向量提取字符级别的特征,BiLSTM捕获词间的上下文信息,CRF则对序列标注进行优化。

对于仅考虑单个词的词向量,若需融入上下文信息,简单的解决方法是将当前词与其前一个词拼接为向量,维度扩展至词向量的两倍。进阶策略则采用公式等组合方式,进一步提炼上下文依赖。

在文本挖掘课程中,完成序列标注任务,可参考个人博客中相关实践。代码与综述报告已上传至GitHub,实现基础的CNN、LSTM与CRF模型,取得了%的F1值。

GitHub上不乏更高级的实现,提供多样化的参考。尽管个人代码编写风格可能显得粗糙,但已展示基本模型的构建过程,实现语义特征向量的有效转换。