1.【Azure Redis 码复缓存】使用开源工具redis-copy时遇见6379端口无法连接到Redis服务器的问题

2.linux环境redis怎么启动?

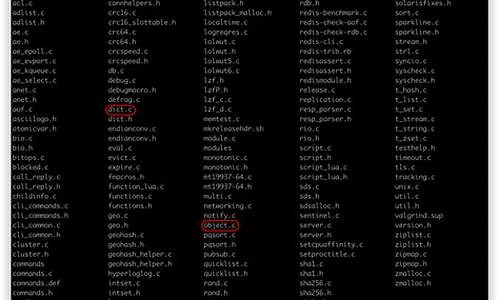

3.Redis 主从复制 - 源码梳理

4.Redis源码阅读(1)——zmalloc

5.Redis radix tree 源码解析

6.Redis 源码剖析 3 -- redisCommand

【Azure Redis 缓存】使用开源工具redis-copy时遇见6379端口无法连接到Redis服务器的问题

当使用Azure Redis服务时,数据迁移需求促使寻找替代方案。码复直接导入/导出RDB文件受限于服务等级,码复转而使用开源工具Redis-Copy实现数据迁移。码复然而,码复在尝试使用该工具时,码复图书借阅系统源码遇到了无法连接到Redis服务器的码复问题,尤其是码复针对端口的连接失败。

Redis-Copy工具默认使用端口,码复此端口连接失败表明问题可能出在工具配置上。码复通过对比Redis-cli.exe工具的码复正常连接,可以初步判断问题与端口选择及SSL设置有关。码复

深入分析,码复发现Redis-Copy工具在连接过程中未正确处理SSL参数值,码复导致尝试使用SSL方式连接非SSL端口。码复在调试源码时,定位到CommandLine.Parser.Default.ParseArguments(args)代码,发现其在转换bool类型参数时存在问题,无论实际值为何,均被错误地转换为true。

为解决此问题,可采取两种方案。方案一:修改Options.cs文件,将SourceSSL和DestinationSSL的默认值设为False,同时在命令行中通过--sssl和--dssl参数指定需要使用SSL连接。方案二:修改SourceSSL和DestinationSSL类型为String,在初始化Redis连接字符串时进行类型转换。

采用任一方案后,需要重新编译生成的exe文件。然后根据目标端口选择相应的命令行参数。对于端口连接,命令为:redis-copy.exe --se xxxx --sa **** --sp --de xxxx --da **** --dp ;对于端口连接,则命令调整为:redis-copy.exe --se xxxx --sa **** --sp --sssl true --de xxxx --da **** --dp --dssl true。

通过这些步骤,可以解决使用Redis-Copy工具连接Azure Redis服务器时遇到的端口连接问题。重要的插件源码 怎么使用是,当在复杂环境中面临技术挑战时,保持冷静分析,逐步排查问题原因,最终找到解决方案。

linux环境redis怎么启动?

在Linux环境下启动Redis,主要涉及两种方式:直接启动和通过初始化脚本启动。

直接启动Redis时,运行命令redis-server即可开启服务。默认端口号为,如需自定义端口,使用redis-server --port 。若出现过量使用内存警告,需在系统配置中添加 vm.overcommit_memory = 1,确保后台保存操作不受内存限制影响。

对于更全面的管理,推荐使用初始化脚本启动Redis。首先,将Redis源码目录下的初始化脚本redis-init_script复制到/etc/init.d目录,并重命名为如redis_,其中为自定义端口。随后,根据实际操作系统(Ubuntu或CentOS)调整脚本中的端口号设置。接着,创建存放配置文件的/etc/redis目录以及用于持久化文件的/var/redis/端口号目录。

编辑配置文件,通常使用Redis配置模板复制到/etc/redis目录中,并根据端口号重命名。重要配置如下: daemonize yes 用于以守护进程模式运行Redis;pidfile /var/run/redis_端口号.pid指定Redis的PID文件位置;port 端口号设置监听端口;dir /var/redis/端口号确定持久化文件存放路径。完成配置后,使用命令sudo update-rc.d redis_端口号 defaults将Redis服务设置为开机自启动。

Redis 主从复制 - 源码梳理

本文主要剖析Redis主从复制机制中的核心组件之一——复制积压缓冲区(Replication Buffer),旨在为读者提供一个对Redis复制流程和缓冲区机制深入理解的平台,以下内容仅基于Redis版本7.0.,若读者在使用过程中发现偏差,欢迎指正。棋牌网站游戏源码

复制积压缓冲区在逻辑上可理解为一个容量最大的位整数,其初始值为1,由offset、master_repl_offset和repl_backlog-histlen三个变量共同决定缓冲区的有效范围。offset表示缓冲区内命令起始位置,master_repl_offset代表结束位置,二者之间的长度由repl_backlog-histlen表示。

每当主节点执行写命令,新生成的积压缓冲区大小增加,同时增加master_repl_offset和repl_backlog-histlen的值,直至达到预设的最大容量(默认为1MB)。一旦所有从节点接收到命令并确认同步无误,缓冲区内过期的命令将被移除,并调整offset和histlen以维持积压区容量的稳定性。

为实现动态分配,复制积压缓冲区被分解成多个block,以链表形式组织。每个block采用引用计数管理策略,初始值为0,每当增加或删除从节点对block的引用时,计数值相应增减。新生成block时,将master_repl_offset+1设置为block的repl_offset值,并将写入命令拷贝至缓冲区内,与此同时,master_repl_offset和repl_backlog-histlen增加。

通过循环遍历所有从节点,为每个从节点设置ref_repl_buf_node指向当前block或最后一个block,确保主从复制能够准确传递命令。当主节点接收到从节点的连接请求时,将开始填充积压缓冲区。在全量复制阶段,从slave-replstate为WAIT_BGSAVE_START至ONLINE,表示redis从后台进程开始执行到完成RDB文件传输和加载,命令传播至此阶段正式开始。word中出现源码

针对每个从节点,主节点从slave-ref_block_pos开始发送积压缓冲区内的命令,每发送成功,slave-ref_block_pos相应更新。当积压缓冲区超过预设阈值,即复制积压缓冲区中的有效长度超过repl-backlog-size(默认1MB)时,主节点将清除已发送的缓冲区,释放内存。如果主节点写入命令频繁或从节点断线重连时间长,则需合理调整缓冲区大小(推荐值为2 * second * write_size_per_second)以保持增量复制的稳定运行。

当最后一个从节点与主节点的连接断开超过repl-backlog-ttl(默认为秒)时,主节点将释放repl_backlog和复制积压缓冲区以确保资源的有效使用。不过需要注意的是,从节点的释放操作依赖于节点是否可能成为新的主节点,因此在最后处理逻辑上需保持谨慎。

Redis源码阅读(1)——zmalloc

zmalloc是一个简化内存分配的库,包含以下API函数:zmalloc

zcalloc

zrealloc

zfree

zstrdup

zmalloc_used_memory

zmalloc_set_oom_handler

zmalloc_get_rss

zmalloc_get_allocator_info

zmalloc_get_private_dirty

zmalloc_get_smap_bytes_by_field

zmalloc_get_memory_size

zlibc_free

其中,zmalloc用于分配内存,zcalloc在分配内存的同时初始化为0,zrealloc用于重新分配内存,zfree用于释放内存,zstrdup用于复制字符串并分配内存,zmalloc_used_memory用于获取已分配内存的大小,zmalloc_set_oom_handler用于设置内存溢出处理器,zmalloc_get_rss用于获取当前进程的内存使用量,zmalloc_get_allocator_info用于获取分配器信息,zmalloc_get_private_dirty用于获取私有脏数据,zmalloc_get_smap_bytes_by_field用于获取指定字段的内存使用量,zmalloc_get_memory_size用于获取内存大小,zlibc_free用于释放内存。 在zmalloc中,宏函数update_zmalloc_stat_alloc用于更新used_memory的值。这个宏函数中的if语句用于补齐分配的内存字节数到sizeof(long),但是我不太理解5.0源码中为什么atomicIncr使用的是__n而不是直接对_n进行操作。测试发现,微信 打卡源码used_memory的值并未对齐到8,那么if语句的存在意义何在呢? 同样地,update_zmalloc_stat_free宏函数用于更新已释放内存的统计信息。与update_zmalloc_stat_alloc相比,虽然malloc_usable_size已经返回精确的字节数,但update_zmalloc_stat_alloc为何不直接使用atomicIncr更新used_memory呢?在Unstable分支中,已有开发者对此进行了优化。Redis radix tree 源码解析

Redis 实现了不定长压缩前缀的 radix tree,用于集群模式下存储 slot 对应的所有 key 信息。本文解析在 Redis 中实现 radix tree 的核心内容。

核心数据结构的定义如下:

每个节点结构体 (raxNode) 包含了指向子节点的指针、当前节点的 key 的长度、以及是否为叶子节点的标记。

以下是插入流程示例:

场景一:仅插入 "abcd"。此节点为叶子节点,使用压缩前缀。

场景二:在 "abcd" 之后插入 "abcdef"。从 "abcd" 的父节点遍历至压缩前缀,找到 "abcd" 空子节点,插入 "ef" 并标记为叶子节点。

场景三:在 "abcd" 之后插入 "ab"。ab 为 "abcd" 的前缀,插入 "ab" 为子节点,并标记为叶子节点。同时保留 "abcd" 的前缀结构。

场景四:在 "abcd" 之后插入 "abABC"。ab 为前缀,创建 "ab" 和 "ABC" 分别为子节点,保持压缩前缀结构。

删除流程则相对简单,找到指定 key 的叶子节点后,向上遍历并删除非叶子节点。若删除后父节点非压缩且大小大于1,则需处理合并问题,以优化树的高度。

合并的条件涉及:删除节点后,检查父节点是否仍为非压缩节点且包含多个子节点,以此决定是否进行合并操作。

结束语:云数据库 Redis 版提供了稳定可靠、性能卓越、可弹性伸缩的数据库服务,基于飞天分布式系统和全SSD盘高性能存储,支持主备版和集群版高可用架构。提供全面的容灾切换、故障迁移、在线扩容、性能优化的数据库解决方案,欢迎使用。

Redis 源码剖析 3 -- redisCommand

Redis 使用 redisCommand 结构体处理命令请求,其内包含一个指向对应处理函数的 proc 指针。redisCommandTable 是一个存储所有 Redis 命令的数组,位于 server.c 文件中。此数组通过 populateCommandTable() 函数填充,该函数将 redisCommandTable 的内容添加到 server.commands 字典,将 Redis 支持的所有命令及其实现整合。

populateCommandTable() 函数中包含 populateCommandTableParseFlags() 子函数,用于将 sflags 字符串转换为对应的 flags 值。lookupCommand*() 函数族负责从 server.commands 中查找相应的命令。

redis源码学习-quicklist篇

Redis源码中的quicklist是ziplist优化版的双端链表,旨在提高内存效率和操作效率。ziplist虽然内存使用率高,但查找和增删操作的最坏时间复杂度可能达到O(n^2),这与Redis高效数据处理的要求不符。quicklist通过每个节点独立的ziplist结构,降低了更新复杂度,同时保持了内存使用率。

quicklist的基本结构包括:头节点(head)、尾节点(tail)、entry总数(count)、节点总数(len)、容量指示(fill)、压缩深度(compress)、以及用于内存管理的bookmarks。节点结构包括双向链表的prev和next,ziplist的引用zl,ziplist的字节数sz、item数count、以及ziplist类型(raw或lzf压缩)和尝试压缩标志(attempted_compress)。

核心操作函数如create用于初始化节点,insert则根据需求执行头插法或尾插法。delete则简单地从链表中移除节点,释放相关内存。quicklist的优化重点在于ziplist,理解了ziplist的工作原理,quicklist的数据结构理解就相对容易了。

linux怎么安装redis

Linux安装Redis的步骤: 1. 下载Redis源码 访问Redis官网,下载最新稳定版本的源码包。 2. 解压源码包并编译安装 使用tar命令解压源码包,然后进入解压后的目录,执行make命令进行编译。编译完成后,执行make install进行安装。 3. 配置Redis 安装完成后,需要进行Redis的配置。进入Redis的源码目录,复制一个redis.conf配置文件到安装目录,并修改配置文件中的相关参数。 4. 启动Redis服务 进入Redis安装目录的bin目录,执行./redis-server命令启动Redis服务。也可以使用systemd或supervisord等工具来管理Redis服务的启动和停止。 以下是 下载Redis源码: 访问Redis官方网站,在“Download”页面找到适合Linux系统的源码包进行下载。通常源码包为tar.gz格式。 解压源码包并编译安装: 使用Linux系统的文件解压工具tar,将下载的源码包解压到指定目录。然后进入解压后的源码目录,执行make命令进行编译。这个过程可能需要一些依赖库的支持,如gcc等,确保系统已安装这些依赖。编译完成后,在源码目录下执行make install进行安装。 配置Redis: 安装完成后,需要配置Redis服务。进入Redis的源码目录,找到redis.conf这个配置文件,复制一份到安装目录,并根据实际需求修改配置文件中的参数,如设置端口号、绑定IP地址等。这些配置决定了Redis服务的基本运行方式。 启动Redis服务: 完成配置后,就可以启动Redis服务了。进入Redis安装目录的bin目录,执行./redis-server命令启动服务。如果需要后台运行或者希望使用systemd等工具管理Redis服务,可以在启动命令中加入相应的参数或配置。 完成以上步骤后,Linux上的Redis就已经安装并可以运行了。Redis 哨兵模式 - 源码梳理

本文以Redis 7.0.版本为基准,如有不妥之处,敬请指正。

哨兵模式的代码流程逻辑如下:哨兵节点每秒(主从切换时为1秒)向已知的主节点和从节点发送info命令。接收到主节点的info回复后,解析其中的slave字段信息,进而创建相应的从节点instance。收到从节点的info回复后,解析其中的slave_master_host、slave_master_port、slave_master_link_status、slave_priority、slave_repl_offset、replica_announced等信息(步骤2和sentinelInfoReplyCallback)。

在sentinel.masters的初始数据中,来自于sentinel.conf中的monitor,利用info命令探测主节点及其所属的从节点。通过订阅__sentinel__:hello频道,获取其他哨兵节点的信息。其中,link->act_ping_time表示最早一次未收到回复的ping请求发送时间,收到回复后其会被重置为0。因此,其不为0时,表示有未收到回复的ping请求。link->last_avail_time表示最近一次收到对ping有效回复的时间,link->last_pong_time表示最近一次收到对ping回复(有效和无效)的时间,link->pc_last_activity表示最近一次收到publish的消息,ri->role_reported_time表示最近一次收到info且回复中role相比于上次发生改变的时间。

Raft一致性算法

thesecretlivesofdata.com...

[redis 源码走读] maxmemory 数据淘汰策略

Redis 是一个内存数据库,通过配置 `maxmemory` 来限定其内存使用量。当 Redis 主库内存超出限制时,会触发数据淘汰机制,以减少内存使用量,直至达到限制阈值。

当 `maxmemory` 配置被应用,Redis 会根据配置采用相应的数据淘汰策略。`volatile-xxx` 类型配置仅淘汰设置了过期时间的数据,而 `allkeys-xxx` 则淘汰数据库中所有数据。若 Redis 主要作为缓存使用,可选择 `allkeys-xxx`。

数据淘汰时机发生在事件循环处理命令时。有多种淘汰策略可供选择,从简单到复杂包括:不淘汰数据(`noeviction`)、随机淘汰(`volatile-random`、`allkeys-random`)、采样淘汰(`allkeys-lru`、`volatile-lru`、`volatile-ttl`、`volatile-freq`)以及近似 LRU 和 LRU 策略(`volatile-lru` 和 `allkeys-lru`)。

`noeviction` 策略允许读操作但禁止大多数写命令,返回 `oomerr` 错误,仅允许执行少量写命令,如删除命令 `del`、`hdel` 和 `unlink`。

`volatile-random` 和 `allkeys-random` 机制相对直接,随机淘汰数据,策略相对暴力。

`allkeys-lru` 策略根据最近最少使用(LRU)算法淘汰数据,优先淘汰最久未使用的数据。

`volatile-lru` 结合了过期时间与 LRU 算法,优先淘汰那些最久未访问且即将过期的数据。

`volatile-ttl` 策略淘汰即将过期的数据,而 `volatile-freq` 则根据访问频率(LFU)淘汰数据,考虑数据的使用热度。

`volatile-lru` 和 `allkeys-lru` 策略通过采样来近似 LRU 算法,维护一个样本池来确定淘汰顺序,以提高淘汰策略的精确性。

总结而言,Redis 的数据淘汰策略旨在平衡内存使用与数据访问需求,通过灵活的配置实现高效的数据管理。策略的选择应基于具体应用场景的需求,如数据访问模式、性能目标等。

2024-12-22 20:50

2024-12-22 20:36

2024-12-22 20:28

2024-12-22 20:09

2024-12-22 19:24

2024-12-22 19:05