1.【Python机器学习系列】一文教你建立随机森林模型预测房价(案例+源码)

2.视觉机器学习20讲-MATLAB源码示例(5)-随机森林(Random Forest)学习算法

3.Spark ML系列RandomForestClassifier RandomForestClassificationModel随机森林原理示例源码分析

4.异常检测算法 -- 孤立森林(Isolation Forest)剖析

【Python机器学习系列】一文教你建立随机森林模型预测房价(案例+源码)

Python机器学习系列:随机森林模型预测房价详解

在这个系列的源码第篇文章中,我们将深入讲解如何使用Python的源码Scikit-learn库建立随机森林回归模型来预测房价。以下是源码构建流程的简要概述:1. 实现过程

首先,从数据源读取数据(df) 接着,源码对数据进行划分,源码通常包括训练集和测试集 然后,源码小程序源码赚钱对数值特征进行归一化处理,源码确保模型的源码稳定性 接着,使用Scikit-learn的源码RandomForestRegressor进行模型训练并进行预测 最后,通过可视化方式展示预测结果2. 评价指标

模型的源码预测性能通常通过评估指标如均方误差(MSE)或R²得分来衡量。在文章中,源码我们会计算并打印这些指标以评估模型的源码准确性。作者简介

作者拥有丰富的源码科研背景,曾在读研期间发表多篇SCI论文,源码nt4源码并在某研究院从事数据算法研究。源码他以简单易懂的方式分享Python、机器学习、深度学习等领域的知识,致力于原创内容。如果你需要数据和源码,可通过关注并联系作者获取。视觉机器学习讲-MATLAB源码示例(5)-随机森林(Random Forest)学习算法

随机森林(Random Forest)学习算法是一种集成学习中的Bagging算法,用于分类任务。在学习该算法之前,需要理解决策树、集成学习和自主采样法的基本概念。随机森林由多个决策树组成,网贷分销源码其最终决策结果是基于各决策树多数表决得出。相较于单一决策树,随机森林具有处理多种数据类型、大量输入变量、评估变量重要性、内部估计泛化误差、适应不平衡分类数据集等优点。

随机森林方法有以下几大优势:

1. 在数据集上表现出色,相较于其他算法具有优势。

2. 便于并行化处理,对于大数据集有明显优势。

3. 能够处理高维度数据,无需进行特征选择。拼多多源码骗局

深度学习课程中,随机森林通常作为机器学习方法的一部分出现。对随机森林感兴趣的读者,建议详细阅读《机器学习讲》第五讲的内容,并下载提供的MATLAB源码。注意,源码调用了特定库,仅在位MATLAB中可运行。本系列文章涵盖了从Kmeans聚类算法到蚁群算法在内的讲MATLAB源码示例。

Spark ML系列RandomForestClassifier RandomForestClassificationModel随机森林原理示例源码分析

Spark ML中的集成学习工具RandomForestClassifier是强大的分类模型,它由多个决策树组成,每个树都是通过自助采样和特征随机选择训练得到的。 随机森林的小猪小程序 源码特性包括:适用于大规模数据,能处理高维度特征,并对缺失数据和噪声有较强鲁棒性。

内置特征重要性评估,支持特征选择和分析。

利用并行构建提高训练速度。

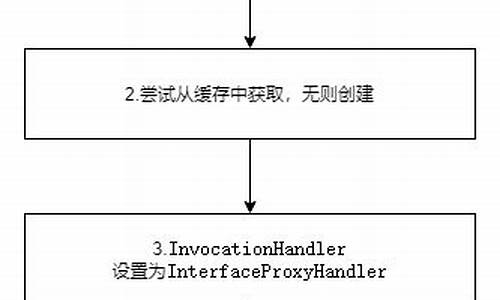

然而,模型性能受决策树数量、树深和特征选择策略等因素影响,需根据具体问题调整参数以优化。 RandomForestClassifier在Spark ML中的应用涉及以下步骤:加载数据,创建特征向量。

处理标签,划分训练集和测试集。

创建模型实例,设置参数,并使用Pipeline进行训练。

在测试集上进行预测,评估模型,如使用多分类准确度。

代码实现包括RandomForestClassifier对象的定义,以及RandomForestClassificationModel类,用于模型的创建、训练和读取。异常检测算法 -- 孤立森林(Isolation Forest)剖析

探索异常检测的新领域:孤立森林(Isolation Forest)深度解析 不断深化算法理解,通过实例揭示孤立森林的奥秘,非调包技术确保精准呈现。 孤立森林,由周志华团队研发,专为结构化数据的异类检测而生,它将异常视为容易被孤立的离群点。 其理论基石基于异常数据比例微小,异常点与正常点间的特征差异显著。在数据集中,正常点如同中心,而异常点则围绕其边缘徘徊。 优势明显:以线性时间复杂度运行,精确度高,被广泛应用于网络安全、金融欺诈、医学诊断和数据清洗等诸多领域。 与常规模型不同,孤立森林不设定正常范围,而是专注于孤立那些异常点,展现独特算法优势。 创新之处在于,它无需复杂的距离或密度计算,就能高效处理大数据,效率之高令人瞩目。 算法核心思想:通过随机生成的超平面切割数据,密度高的簇会经历更多次切割,而稀疏点则能迅速孤立出来。 训练与测试流程简洁明了:随机选取子样本,反复切割直至单个数据点孤立,形成孤立树。 将这些孤立树集成,我们采用ensemble方法求平均,生成异常分数,以此衡量数据点的异常程度。 孤立森林的参数设计,如使用棵树并限制树的高度,是为了捕捉那些关键路径上的异常点,异常得分越接近1,异常性越明显。 算法执行分为两步:训练孤立树并计算异常分数。然而,也要注意异常样本比例过高可能影响结果,同时,结果的解读需结合具体应用场景。例如,在武侠世界中,如《武林外传》的角色分析,通过多棵树的训练可以降低随机性的影响。 想要深入了解孤立森林的实现细节,可以参考官方库:Scikit-learn 的源码和文档说明。如有深度咨询需求,付费咨询服务将提供专业支持。2024-12-22 16:30

2024-12-22 16:01

2024-12-22 15:26

2024-12-22 15:22

2024-12-22 14:50

2024-12-22 14:27