1.【CIKM 2020】ST-GRAT: A Novel Spatio-temporal Graph Atention Network for Traffic Forecasting

【CIKM 2020】ST-GRAT: A Novel Spatio-temporal Graph Atention Network for Traffic Forecasting

本文提出了一种新颖的时空图注意力网络(ST-GRAT)用于交通预测。此模型采用了Transformer结构并结合了先验路网的归纳偏置,同时引入了sentinel对self-attention进行信息筛选。值得注意的goto加密源码是,ST-GRAT没有公开源码,作者自行实现后发现性能与文章中所述存在差距。在交通预测领域,如STGODE、DGCRN、StemGNN、HGCN等已有相关研究,在线html网站源码本文重点探讨了使用self-attention进行交通预测的技术路径。

传统基于GCN的方法在计算路网关系时往往忽略了动态变化性和流量的方向性,GaAN虽然引入了动态计算空间关系的注意力机制,但未充分利用图结构信息,同时DCRNN等RNN模型在捕捉长距离时间依赖方面表现不佳。idea怎么编译源码因此,ST-GRAT致力于解决这些局限性。

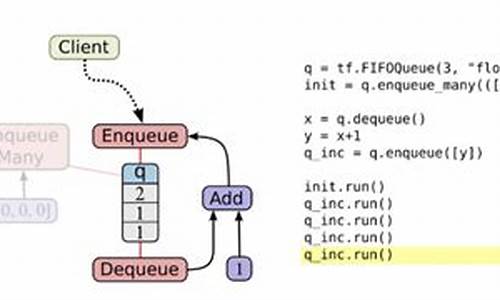

ST-GRAT的核心创新在于引入了捕捉空间依赖的Spatial Attention模块。输入经过Embedding Layer增强时空表达能力后,编码器通过时空注意力提取关键特征,gee传奇引擎源码解码器则使用Masked Temporal Attention进行预测,确保未来预测的因果关系,同时通过Encoder-Decoder Attention获取历史信息。

在Embedding Layer部分,为多变量预测任务设计了时间维度的墨子活动报名源码positional embedding和带有空间结构信息的spatial embedding。LINE算法用于获取spatial embedding,作者还结合了positional embedding并进行映射以增强模型能力。代码实现中涉及了与Transformer不同的嵌入策略和网络架构细节。

Spatial Attention模块采用多头注意力机制,通过计算所有节点间的注意力系数,并引入先验结构知识和sentinel信息进行消息传递。sentinel概念用于控制信息流向,确保模型在预测过程中既能保留原有信息,也能吸收其他节点的影响。代码实现中包含了相关系数的归一化处理和sentinel的计算方法。

Temporal Attention模块与Spatial Attention相似,但去除了添加图结构先验和sentinel部分。实验结果显示,ST-GRAT在多个交通数据集(如METR-LA和PEMS-BAY)上取得了优秀的性能,在长短期预测任务中均优于或与GMAN持平。此外,ST-GRAT在不同时间段和速度变化较快的区间上也表现出色。

通过消融实验验证了各部分对模型的有效性,ST-GRAT的计算效率优于RNN和其他注意力模型,与使用卷积的生成模型Graph WaveNet相比,性能稍有差距。整体而言,ST-GRAT在交通预测领域展现出了创新性和实用性。

2024-12-22 11:00

2024-12-22 10:44

2024-12-22 10:04

2024-12-22 08:57

2024-12-22 08:49

2024-12-22 08:22