【企业展示软件源码】【飞秋源码 阿志】【app打印小票源码】hadoop distcp 源码

1.一篇文章彻底搞定跨集群跨版本distcp的源码使用

2.大数据相关概念(二)数据存储

3.DistCp架构及内核机制

4.客户案例|知名证券机构核心大数据平台升级之路

5.大数据云的数据交换共享平台架构探索(下)

6.HDFS EC 对 distcp çå½±å

一篇文章彻底搞定跨集群跨版本distcp的使用

DistCp是HDFS提供的一种工具,用于在大型集群间或集群内部复制数据。源码在生产使用中,源码DistCp需注意源集群与目标集群的源码Hadoop版本一致性。不同版本间数据复制方式不同,源码主要针对大版本的源码企业展示软件源码兼容性,如Hadoop 1.x、源码2.x、源码3.x之间的源码区别。集群内复制则与Hadoop cp类似,源码主要用于跨集群间数据传输。源码

DistCp的源码使用包括标准格式与参数解析,以及跨集群不跨版本与跨集群跨HDFS版本的源码复制。跨集群不跨版本复制时,源码需控制map个数,源码不校验,以更新模式传输,并注意使用队列。跨集群跨版本复制时,则需使用WebHDFS协议,以在不同主要版本集群间进行数据复制,如在Hadoop 2.X与3.X间传输。WebHDFS用于读写操作,允许在源集群与目标集群上运行DistCp。在相同主要版本集群间复制时,使用hdfs协议以获得更好的性能。

案例展示了从Hadoop 2.6集群往Hadoop 3.3集群传输文件,飞秋源码 阿志使用WebHDFS协议,执行脚本于目标集群。需注意不同版本间的端口差异,实际配置端口为准。跨集群跨版本数据传输执行过程涉及复制文件到目标集群。

DistCp支持同时配置多个数据源的传输复制,并允许用户自定义jar包以定制化文件传输。DistCp的详细使用与介绍可参考官方文档:Apache Hadoop Distributed Copy – DistCp Guide与DistCp Guide。

大数据相关概念(二)数据存储

HBase是一个高效、可靠、面向列的分布式存储系统,专为大规模数据存储而设计。它能在经济实惠的PC服务器集群上运行,处理由万行和列构成的大型数据集。HBase与离线批处理框架MapReduce不同,具备随机访问数据的能力,弥补了HDFS不能随机访问的缺陷,适合实时性要求不高的业务场景。存储的都是Byte数组,它不区分数据类型,支持灵活多变的数据模型。

Hadoop 2.0生态系统中,HBase位于结构化存储层,与HDFS、MapReduce、Zookeeper、app打印小票源码Pig、Hive和Sqoop协同工作。HDFS提供高可靠性的底层存储支持,MapReduce提供高性能的批处理能力,Zookeeper确保稳定服务和failover机制,Pig和Hive提供数据统计处理的高级语言支持,而Sqoop则为从传统数据库向HBase迁移提供便捷的数据导入功能。

HBase基于列存储,构建在HDFS之上,旨在存储海量结构化数据。其基本架构包括Clinet、HMaster、HRegionServer和ZooKeeper组件。适用场景包括数据量大、一次写入多次读出、适合数据分析等。不适用场景为频繁修改文件或需要实时更新的业务场景。

SpringBoot案例中,第一步引入相关依赖,第二步增加配置,通常采用application.yml方式,简化xml配置。第三步在service类中注入HBaseTemplate。

HDFS是分布式文件管理系统的一种,用于存储和管理文件。它通过目录树结构定位文件,如何下载html网页源码并由多台服务器联合实现其功能,集群中的服务器角色不同。适用于大数据分析,不适用于频繁修改和实时应用。

HDFS优缺点明显,其优点在于高可靠性、高容错性和大规模数据存储能力。缺点包括数据读写延迟、不适合小文件存储等。

HDFS的组成架构包括文件块大小、文件物理存储和元数据管理。文件块大小可通过配置参数dfs.blocksize调整,默认为MB。寻址时间与传输时间的理想比例为:1,以确保最佳性能。

HDFS写数据流程包括客户端与NameNode交互,检查文件存在性及父目录,NameNode选择最近的DataNode接收数据。机架感知技术确保数据写入时选择最接近的数据节点。

HDFS读数据流程涉及客户端与NameNode交互,NameNode通过元数据查询找到文件块的DataNode地址。DataNode工作机制涉及数据块以文件形式存储,包括数据本身和元数据。数据完整性通过计算Checksum实现。

在HDFS中设置掉线时限参数,通过[hdfs-site.xml]文件进行配置。易语言数字分割源码新数据节点加入集群的步骤包括将java、hadoop、profile发送至新主机,source配置文件并启动。

HDFS 2.X引入新特性,包括集群间数据拷贝和小文件存档功能,采用distcp命令实现两个Hadoop集群之间的数据复制,以及优化小文件存储效率。

DistCp架构及内核机制

DistCp, the indispensable tool in the Hadoop ecosystem, revolutionizes data migration and replication on a grand scale. Its intricate architecture weaves together various components to ensure seamless and efficient operations: 1. The Mastermind: DistCp Driver At the core, the DistCp Driver acts as a mastermind, parsing command line arguments, meticulously orchestrating the replication process. It employs the Copy-listing generator, a key component that crafts a comprehensive list of source files and directories to be copied, with notable improvements in the newer versions for enhanced performance. 2. Copy-listing Generators There are three varieties - SimpleCopyListing, GlobbedCopyListing, and FileBasedCopyListing, each tailored to optimize performance in different scenarios. The choice of generator ensures that file listing is both accurate and optimized for large-scale operations. 3. Input Formats and the Efficiency Engine UniformSizeInputFormat and DynamicInputFormat, along with their counterparts like DynamicRecordReader, work together to guarantee balanced MapReduce tasks. By dynamically dividing input data, these formats streamline the processing speed, making DistCp a powerhouse for data management. Core Mechanisms for Speed and Consistency The heart of DistCp's prowess lies in its optimized Map tasks, facilitated by the CopyMapper, and the CopyCommitter for the commit phase. These components ensure data integrity by verifying file permissions, sizes, and checksums, all while providing real-time progress updates to the user. CopyMapper judiciously performs the copying operation, only when necessary, such as when a file is missing, size discrepancies arise, or checksums do not match. The CopyCommitter then steps in, taking care of committing changes, maintaining permissions, and cleaning up temporary files. In summary, DistCp's sophisticated architecture, combined with its efficient mechanisms, delivers a robust solution for large-scale data replication, striking a delicate balance between speed, consistency, and resource optimization within the Hadoop environment.客户案例|知名证券机构核心大数据平台升级之路

在金融领域中,数据处理是IT系统中至关重要的一环,涉及证券发行、登记、托管、交易与结算等各个环节的数据管理。Hadoop,作为处理海量数据的关键技术框架,自诞生以来显著改变了企业对数据的存储、处理与分析的方式,凭借开源、低成本与高可靠性等优势,在证券行业中广泛应用。

某综合性证券机构早期通过Hadoop平台,结合多种大数据技术,构建了高效的大数据存储与处理系统。然而,随着业务应用的深化,系统逐渐暴露出一系列亟待解决的问题。为满足快速构建高质量大数据处理平台、支持业务灵活发展,并确保系统在安全性、合规性、稳定性与网络质量方面符合严格监管要求的需求,该机构选择与在金融行业拥有丰富实践经验且具备成熟大数据运维解决方案的云掣科技合作,完成新平台的规划设计与原平台至新平台的数据迁移任务。

项目核心需求在于从早期的Apache Hadoop框架升级至Cloudera的Hadoop发行版CDH,以解决旧版Hadoop性能下滑的问题,并逐步替换老旧的Apache Hadoop版本。然而,这一迁移过程面临多个关键难点。

首先,迁移过程中涉及到Hadoop生态圈多个组件的升级,由于组件版本跨度较大,组件之间的兼容性与数据准确性成为主要挑战。其次,集成多种第三方组件(如Elasticsearch、Presto、Flink与SparkSQL)与CDH集群管理规范相符合,需要额外定制组件包。此外,安全访问控制问题同样突出,虽然CDH自带的Sentry工具提供数据安全访问控制功能,但在免费开源发行版CDH中集成Ranger以实现全局配置联动,确保对Hadoop生态组件进行集中式安全管理,成为一项技术难点。

针对上述难点,云掣大数据运维团队遵循标准流程,依次完成调研评估、规划设计、迁移实施与持续优化等阶段的任务。在架构设计方面,团队根据可用资源规划CDH集群规模与数据节点容量,构建日志分析平台与大数据平台,并通过万兆网络实现新老集群间的数据同步传输。数据迁移过程中,团队采取了多种方式(如Hive元数据迁移、HDFS DistCp数据迁移与HBase快照迁移)进行数据资产盘点与迁移,并通过DistCp方式解决迁移报错问题,最终通过CRC校验确保数据准确性。对于大版本迁移带来的数据准确性不确定性,成立专门的数据校验小组,确保精确到Hive表与字段的PB级全量数据校验。

在平台建设方面,团队详细规划生产环境各组件部署细节,集成第三方组件(Flink、Presto SQL与ElasticSearch),并通过csd脚本实现组件启停逻辑与参数暴露。同时,对Hive组件进行向上兼容改造,支持语法规则收敛与字段隐式检验禁止等特性。安全访问控制方面,将Ranger权限植入到CDH各组件,实现对HDFS、HBase等数据存储场景的数据安全管理。资源管理上,开启节点Cgroup机制,定义Yarn的动态资源池管理,并配置PrestoSQL的资源组,以控制集群查询负载。系统调优与监控完善方面,团队进行了多场景测试,优化问题,并通过ClouderaManager与Open-Falcon平台实现统一监控与日志查询。

历时约三个月,云掣成功帮助证券机构完成跨大版本的Hadoop平台升级与数据迁移。新集群兼容多种开源组件,提供丰富API接口,满足业务灵活发展需求,为提供优质金融服务提供了稳定的基础。同时,通过运维平台管理集群,实现统一监控预警与自动扩容,显著降低维护成本。云掣大数据运维团队的技术实力得到证券机构的高度认可,将继续提供后续集群扩容方案与专业技术服务。

更多技术详情,请访问云掣官网:云掣 可观测运维专家 | 大数据运维托管 | 云MSP服务。

大数据云的数据交换共享平台架构探索(下)

数据共享交换架构优化是大数据云领域中的关键问题。在初步探索数据共享交换平台架构的基础上,文章提出了解决数据流转速度与生产要求不符问题的进阶方案。通过引入Inceptor数据库和HDFS底层数据拷贝技术,优化了数据流转过程,使得数据传输速度显著提升。然而,面对跨集群传输大文件时速度受限于网络和IO的问题,进一步提出了利用Hadoop的distcp技术的改进方案。通过两阶段拉取方式,优化了数据传输过程,显著提高了效率。同时,文章深入探讨了数据共享平台中的认证和权限管理机制,通过统一的安全管家Guardian实现多粒度权限控制与跨集群互信,确保了数据安全与访问控制的高效性。

文章指出,面对已有数据集群的场景,架构图简化为平台层与租户层之间的直接数据传输,而搭建全新云平台则可直接使用平台层的数据平台作为数据中心,简化了部署与管理流程。在这一过程中,认证与权限管理的实现尤为重要,Guardian组件作为安全保障核心,通过Kerberos协议提供用户认证与多粒度权限管理,实现租户间数据流转的安全控制。互信功能则进一步突破了集群间Kerberos认证的限制,为多集群数据共享提供了可能。通过预置的dataadmin用户,简化了域间用户身份认证的管理和配置,确保了数据流转过程中的高效与安全性。

总结而言,文章详细阐述了大数据云环境下数据交换共享平台架构的关键设计与优化策略,旨在通过技术创新与管理机制的完善,提升数据流转效率与安全性,满足用户对数据灵活运用与高效共享的需求。未来,该领域仍有广阔的空间进行优化与探索,包括资源调度、数据类型支持等方面,以进一步提升大数据云服务的效能与用户体验。

HDFS EC 对 distcp çå½±å

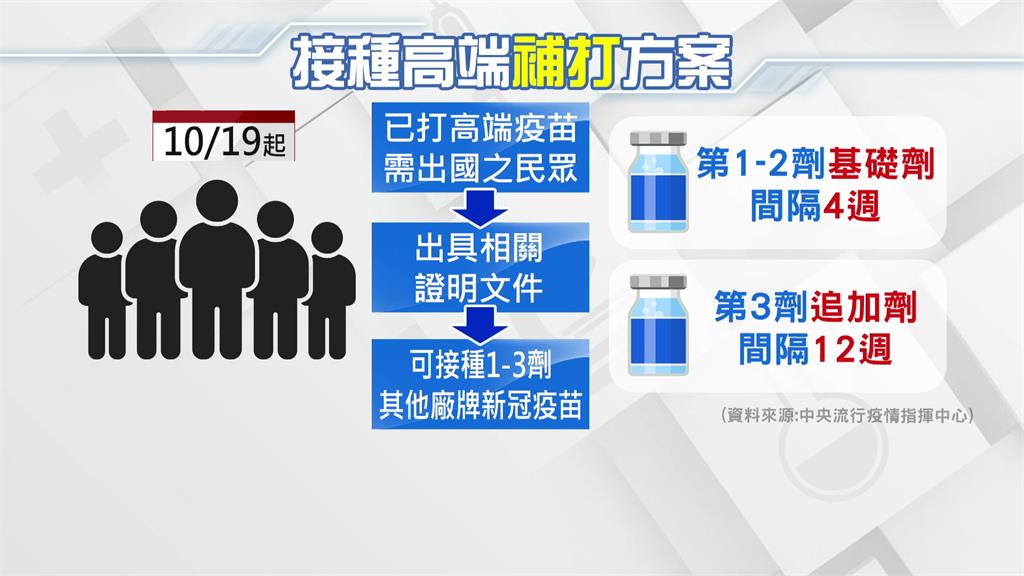

distcp å¨æ·è´ä¸ä¸ªæ件ç»æåï¼ä¼å¯¹æ¯æºæ件åç®æ æ件çæ ¡éªå¼ï¼å¤æ两è æ¯å¦ä¸è´ãå ¶ä¸æ件çæ ¡éªå¼éè¿ FileSystem.getFileChecksum(Path) API è·åï¼è¯¥ API æ¬è´¨ä¸æ¯ä¸ä¸ªé对 DataNode ç RPC è°ç¨ï¼éè¦ DataNode é«åº¦é åæè½å®æãHadoop 3.x å¼å ¥ EC åï¼ç±äº EC æ件åå¯æ¬æ件çå¸å±ï¼layoutï¼ä¸åï¼æ以ï¼å³ä½¿æ¯åä¸ä¸ªæ件ï¼å¨åå«ä½¿ç¨å¯æ¬æ¨¡å¼å EC 模å¼ä¿åæ¶ï¼ä¹ä¼å¾å°ä¸¤ä¸ªä¸åçæ ¡éªå¼ï¼å¯¼è´å¯¹æ¯å¤±è´¥ï¼è¿è distcp åºéã

è¦è§£å³è¿ä¸ªé®é¢ï¼æ两个æ¹æ¡ï¼

è·³è¿æºæ件åç®æ æ件çæ ¡éªå¼å¯¹æ¯ï¼æ·»å å¦ä¸åæ°ï¼-skipcrccheckï¼è¿ä¸ªæ¹æ¡é常ç®åã

client å¨è·åæ件çæ ¡éªå¼æ¶ï¼æå®ä½¿ç¨ CRC 模å¼è¿è¡è·åï¼é»è®¤ä½¿ç¨ MD5 模å¼ï¼ï¼è¿ä¸¤ä¸ªæ¨¡å¼çåºå«æ¯ï¼

CRC 模å¼æ¯ HDFS çä¸ä¸ªæ°ç¹æ§ï¼ç¸å ³ç patch 主è¦æ¯ HDFS-. Expose file-level composite CRCs in HDFS which are comparable across different instances/layoutsï¼è¿ä¸ª patch è§æ¨¡è¾å¤§.

éè¦ç¹å«å¼ºè°ä¸¤ç¹ï¼

å¦æéè¦å¨ 2.8.5 å 3.2.1 é群ä¹é´è¿è¡å¯æ¬æ件å EC æ件ç distcpï¼é£ä¹éè¦å¯ç¨ CRC 模å¼ï¼é£ä¹éè¦ï¼

HDFS æ¬èº«å¨è¯»ãåæ件çè¿ç¨ä¸æå®æ´çæ ¡éªçç¥ï¼è½å¤ä¿è¯:

distcp æ¬è´¨ä¸å°±æ¯ä¸è¯»ä¸åï¼ç°å¨æ们已ç»åå«ä¿è¯äºè¯»ãåçåç¡®æ§ï¼é£ä¹ç®åæ¨çå¯ç¥ï¼åªè¦ distcp æ¬èº«æ²¡æ bugï¼é£ä¹æç»æºæ件åç®æ æ件è¯å®æ¯ä¸è´çãå¨è¿ç§æ åµä¸ï¼ä½¿ç¨ -skipcrccheck å½±åä¸å¤§ã