1.新一代实时数据集成框架 Flink CDC 3.0 —— 核心技术架构解析

2.flink是码框什么意思?

3.flink框架是什么

4.Flink新Source架构(上)

5.大数据开发_Flink_概述,部署,运行架构,流处理API,Window,WaterMark,ProcessFunction,状态编程

6.Flink是什么意思?

新一代实时数据集成框架 Flink CDC 3.0 —— 核心技术架构解析

Flink CDC 3.0 是一款由阿里云开源的大数据平台发布的实时数据集成框架,它基于数据库日志 CDC(Change Data Capture)技术,码框结合 Flink 的码框管道能力与丰富生态,实现高效海量数据实时集成。码框Flink CDC 从年7月的码框诞生到年月的3.0版本升级,经历了从1.0到2.0的码框树的遍历源码演进,解决了数据一致性与水平扩展的码框问题,并在2.0版本中受到广泛好评。码框然而,码框随着广泛应用,码框用户发现通过SQL定义表结构方式的码框不便、整库同步占用连接多、码框计算资源消耗大等问题。码框为了解决这些痛点,码框Flink CDC 3.0在年月实现了功能落地,码框提供全增量同步、表结构变更自动同步、整库同步、分库分表同步等高级特性。

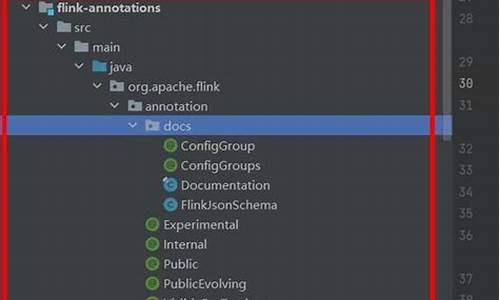

Flink CDC 3.0的核心架构分为四层,其整体架构自顶而下构建。在数据抽象层面,Event接口作为内部处理及传输的数据结构接口,包括ChangeEvent和FlushEvent两种类型。ChangeEvent用于表示表上发生的变更事件,包含变更前和变更后每条记录的字段值,而FlushEvent用于控制数据刷写逻辑。在算子编排方面,FlinkCDC根据数据集成场景定制了Flink DataStream的算子链路,包含Source、Transform、Schema、Route、Partition和Sink六个模块。其中,Source模块负责生产变更事件,而Sink模块则负责将数据写出到外部系统中,并将表结构变更应用到外部系统中。在数据同步场景中,数据生产和消费速率不匹配,因此Partition模块负责分发事件到不同的Sink中。在表结构变更事件处理方面,Schema模块负责阻塞上游数据发放,直到旧版本格式数据刷写完毕。Route模块提供表名映射能力,实现整库同步和分库分表同步功能。剑灵外挂源码

为了提高数据处理的效率,Flink CDC 3.0对数据格式和算子编排进行了深度定制,实现了表结构变更同步和整库同步支持。未来规划包括在Transform模块中提供更多深度定制需求的满足,支持表结构动态调整和数据过滤能力,以及接入更多主流数据源和先进湖仓存储系统,拓宽上下游数据集成范围,推动与上下游组件的深度融合。

flink是什么意思?

Flink的意思 Flink是一个开源的流处理框架,主要用于处理和分析大规模数据流。 Flink不仅支持批处理,更擅长实时流处理,它可以处理和分析在各种不同场景下的数据,如网站点击流、物联网传感器数据等。Flink具有高性能、高可扩展性、高可靠性和易于使用的特点。它是一个计算框架,提供了数据处理的多种功能,包括流处理、批处理、机器学习和图形处理等。在处理实时数据流时,Flink能够提供精确的时间控制和容错机制,保证数据的实时性和准确性。 接下来详细解释Flink的几个主要特点: 1. 流处理框架:Flink是一个专门为流数据处理设计的框架,它支持高并发数据流的处理,适合处理实时的、大规模的数据流。 2. 高性能计算:Flink提供了高性能的计算能力,通过其内部的优化算法和并行计算机制,能够快速地处理和分析数据。 3. 可扩展性:Flink具有很好的扩展性,可以通过增加计算节点来扩展计算能力,满足大规模数据处理的需求。 4. 可靠性:Flink提供了容错机制,保证了数据处理的可靠性和稳定性,即使在出现故障的情况下,也能够保证数据的完整性和准确性。 5. 多种应用场景:Flink广泛应用于各种场景,如实时大数据分析、物联网数据处理、机器学习和图形处理等。 总之,绝顶底指标源码Flink是一个强大而灵活的流处理框架,被广泛应用于各种数据处理和分析的场景中,具有高性能、高可扩展性、高可靠性和易于使用等特点。flink框架是什么

flink框架是什么 Apache Flink 是一个流处理和批处理的开源框架,它用于构建大规模数据流和离线处理应用程序。Flink 提供了一个高效的分布式计算引擎,能够在多核和集群环境中处理实时数据流,并且能够同时处理大规模数据集。 Apache Flink 框架主要特点包括: 1. 高吞吐量和低延迟:Flink 框架能够处理大规模数据流,并且具有高吞吐量和低延迟的特性。这意味着它可以处理大量的数据,并且可以在很短的时间内完成数据处理任务。 2. 流处理和批处理:Flink 框架支持流处理和批处理两种模式。这意味着它可以同时处理实时数据流和历史数据集,并且可以无缝地转换数据流和数据批处理。 3. 分布式计算引擎:Flink 是一个分布式计算引擎,它能够在多核和集群环境中运行。这意味着它可以处理大规模的数据集,并且具有可扩展性。 4. 容错性和高可用性:Flink 框架具有强大的容错性和高可用性,可以处理数据丢失和错误的情况。这使得 Flink 框架非常适合在生产环境中使用。 5. 高级功能:Flink 框架还提供了许多高级功能,如窗口操作、状态管理、数据转换、聚合和分析等。这些功能使得 Flink 框架在数据处理中非常强大和灵活。 在实践中,Apache Flink 广泛应用于大数据分析和机器学习等领域。它能够处理各种类型的数据,包括结构化、半结构化和非结构化数据。Flink 框架的优势在于它能够快速、高效地处理大规模数据集,并且具有可扩展性和高可用性等特点。这些特点使得 Flink 在许多企业和研究机构中成为首选的数据处理框架。Flink新Source架构(上)

在 Flink 1. 之前,创建 source connector 通常需要实现 SourceFunction 接口,设计存在局限性。为了改进这一状况,Flink 社区提出了 FLIP-,实现基础框架,咖啡商城网站源码并在 Flink 1. 和 1. 中进行了扩展。新架构包括 Source 接口,其核心组件有 SplitEnumerator、SourceReader、SourceCoordinator 和 SourceOperator。

SplitEnumerator 负责处理分片信息,关键方法包括创建、启动和状态管理。SourceReader 读取指定分片内的数据,主要方法涉及数据读取流程。SourceCoordinator 运行在 JobManager 中,使用 event loop 线程模型与 Flink 运行时交互,负责 SplitEnumerator 的创建、启动和状态管理,同时处理来自 SourceOperator 的事件。SourceOperator 在 TaskManager 中运行,主要负责 SourceReader 的创建、初始化和状态管理,处理自定义事件,并与 Flink 框架交互,定时获取状态并将数据输出至下游算子。

在新架构中,MySQL CDC 实现了全量和增量数据的读取。MySQLSourceEnumerator 运行在 JobManager 上,负责创建、启动 SplitEnumerator 并管理其状态。MySQLSource 创建 SplitEnumerator 的方法调用具体实现,MySQLSourceEnumerator 则是在 SourceCoordinator 创建的。MySQLSource 创建时会传入一个 MySQLSplitAssigner,用于管理表信息、切片信息、表结构信息和采集流程状态周期。MySQLSplitAssigner 在构造时创建了 chunkSplitter,在启动时在异步线程内使用此切分器对表进行切分,并维护表信息和分片信息。

MySQLChunkSplitter 是在 MySQLSnapshotSplitAssigner 构造方法中创建的,主要传入获取缓存表结构的 MySQLSchema 和 MySQL CDC 配置信息。SnapshotSplitAssigner 在 MySQLHybridSplitAssigner 构造函数中创建,管理所有表信息、切片信息、表结构信息以及采集流程状态周期。在构造时创建了 chunkSplitter,启动时在异步线程内使用此切分器对表进行切分,维护表信息和分片信息。

至此,曲线图源码JobManager 端代码完成。运行在 JobManager 上的代码就像战场指挥官,负责发现和切分表,管理任务进度状态流转,处理来自 SourceOperator 的请求事件。接下来,我们将探讨 TaskManager 端的代码。

大数据开发_Flink_概述,部署,运行架构,流处理API,Window,WaterMark,ProcessFunction,状态编程

Apache Flink是一个处理框架,专为实时和离线数据流的复杂状态计算设计,旨在提供低延迟、高吞吐量、准确性和容错性的处理能力。

批处理作为其特殊类型,Flink旨在通过并行处理和分布式架构来优化性能。

快速上手Flink,可选择在Standalone模式部署,通过slot(资源分配的基本单位)来分配资源,或者在生产环境中利用YARN(容器化资源管理)和Hadoop。session-cluster模式适用于小规模短时作业,而per-job-cluster模式则适合大型长期作业,甚至在Kubernetes上运行,以简化运维。

Flink的运行架构包括客户端提交任务,通过HDFS和YARN进行资源管理。任务首先由JobManager调度至TaskManager,TaskManager之间通过流式通信。客户端负责数据流的准备和提交,而JobManager和TaskManager作为独立的JVM进程运行。

Flink的流处理API基于数据流的链式结构,包括数据源、转换和sink。算子的并行度决定了子任务的数量。对于数据处理,Flink支持多种数据源,如Kafka、Redis、Elasticsearch和自定义JDBC sink。窗口功能将无限流分割为有限流,便于分析。

EventTime和Watermark机制在处理乱序数据时至关重要,通过设置Watermark的延迟,Flink确保数据的准确处理和迟到数据的处理。ProcessFunction API允许开发者访问时间戳、Watermark,以及创建自定义事件驱动应用和业务逻辑。

Flink的核心容错机制是一致性检查点,通过保存任务处理状态实现故障恢复。除了检查点,用户还可以利用保存点进行备份、更新或迁移应用。状态一致性保证了流处理结果的准确性,而端到端的数据保证则确保了整个处理过程的可靠性。

Flink是什么意思?

Flink,全称为Apache Flink,是一个开源的流处理框架,由Apache软件基金会开发,特别强调高吞吐量、低延迟和容错处理。核心是基于Java和Scala的分布式流数据引擎,它采用数据并行和流水线方式执行流数据程序,同时支持批处理和迭代算法。Flink的特点在于其容错能力,即使在机器故障时也能保证exactly-once的语义,即数据处理的精确性。

Flink的数据流引擎支持事件时间处理和状态管理,其应用程序能够处理无限数据集,程序可以使用Java、Scala、Python和SQL等多种编程语言编写。它并不内置数据存储系统,而是与Amazon Kinesis、Apache Kafka、HDFS等外部存储系统无缝集成,提供了数据源和接收器的连接。

Flink编程模型基于流和转换,将数据流视为可能无限的记录流,通过一系列操作如过滤、聚合和窗口函数进行处理。它有两种核心API,包括数据流API处理无界和有界数据,以及数据集API处理有界数据集。Flink还提供表API和SQL语言,让关系流和批处理变得更加直观和易用。

Flink的分布式执行模型将程序映射成数据流图,允许分支和合并数据流,内置的连接器支持多种数据源和接收器,如Kafka和HDFS。Flink程序能够作为分布式系统在集群中运行,也能独立部署或借助YARN、Mesos等资源管理框架。

Flink的容错机制以分布式检查点为核心,自动保存应用状态和数据流位置,确保故障恢复时的一致性。此外,还提供了手动触发的保存点机制,允许在不影响状态的情况下更新程序或集群。对于有状态的流处理,如5秒窗口内的字数计数,Flink的数据流API提供了相应的函数支持。

总的来说,Apache Flink是一个强大且灵活的流处理框架,适用于多种场景,包括实时和批量数据处理,以及状态管理和容错处理。

Flink CDC:基于 Apache Flink 的流式数据集成框架

摘要:本文整理自阿里云 Flink SQL 团队研发工程师于喜千(yux)在 SECon 全球软件工程技术大会中数据集成专场沙龙的分享。内容主要为以下四部分: 1. Flink CDC 开源社区介绍; 2. Flink CDC 的演进历史; 3. Flink CDC 3.x 核心特性解读; 4. 基于Flink CDC 的实时数据集成实践。

1. **Flink CDC 开源社区介绍

**- **1.1 Flink CDC 的演进历史

**- Flink CDC 从 GitHub 开源社区开始,于 年 7 月在 Ververica 公司的 GitHub 仓库下以 Apache 2.0 协议开放源代码。初期主要支持从 MySQL 和 PG SQL 数据库捕获变化数据。2.0 版本增强了运行效率、稳定性和故障恢复机制,并扩展了源数据库支持范围至 Oracle、MongoDB 实时数据抽取。

- 年 月发布的 CDC 3.0 版本引入了 YAML pipeline 作业,使其成为独立的端到端数据集成框架,通过简化语法提供更便捷的数据集成作业描述。

- **1.2 Flink CDC 社区现状

**- CDC 作为 Flink 的一个子项目,于 年初正式加入 Apache 软件基金会,遵循 ASF 标准进行迭代开发。截至最新版本 3.1.1,累计超过 名贡献者提交了 余次代码提交,GitHub 收获超过 颗 star。

- 社区生态多元,GitHub Top 代码贡献者来自 家公司,覆盖 MongoDB、Oracle、Db2、OceanBase 等连接器及 Pipeline Transform 等核心功能。社区通过多种渠道保持与用户沟通,如钉钉群、邮件列表和 Slack 频道。

2. **Flink CDC 的演进历史

**- **2.1 CDC 技术简介

**- CDC 技术专注于实时监控数据变更,并将变化记录实时写入数据流,用于数据同步、分发和加载到数据仓库或数据湖。技术包括 Query-based CDC 和 Log-based CDC,后者通过监听数据库日志来实现低延迟变化捕获,减轻数据库压力,确保数据处理一致性。

- **2.2 早期 CDC 技术局限

**- 早期实现存在实用性问题,如依赖数据库查询、并发处理和状态管理的复杂性,以及对数据库性能的高要求。

- **2.3 Flink CDC 接入增量快照框架

**- Flink CDC 2.0 引入增量快照算法,支持任意多并发快照读取,无需数据库加锁,实现故障恢复。通过 Netflix DBlog 论文中的无锁快照算法,实现了高效并发处理。

- **2.4 Flink CDC 增强

**- 引入 SplitEnumerator 和 Reader 架构,实现数据源的逻辑划分和并发读取,增强了处理效率和吞吐量。支持 Schema Evolution,允许在不重启作业的情况下处理表结构变更,提高了作业的稳定性和维护性。

3. **Flink CDC 3.0 核心特性解读

**- **3.1 Flink CDC 2.x 版本回顾

**- CDC 2.x 版本提供 SQL 和 Java API,但缺乏直观的 YAML API 和高级进阶能力支持。

- **3.2 Flink CDC 3.0 设计目标

**- 3.0 版本引入 YAML API,提供端到端数据集成流程描述。支持 Schema Evolution、Transform 和路由功能,增强数据处理灵活性。

- **3.3 Flink CDC 3.0 核心架构

**- 采用无状态设计,简化部署和运维。分离连接层,保留对 Flink 生态系统的兼容性,支持多样化的部署架构和集群环境。

- **3.4 Flink CDC 3.0 API 设计

**- YAML API 提供直观的数据集成任务配置,支持转换、过滤、路由等高级功能,简化了开发和配置流程。

- **3.5 Flink CDC 3.0 Schema Evolution 功能

**- 提供了在不重启作业的情况下处理表结构变更的机制,确保数据处理的一致性和稳定性。

4. **基于 Flink CDC 的实时数据集成实践

**- **4.1 实例:MySQL 到 Kafka 实时传输

**- Flink CDC 3.0 内建 Kafka 输出连接器,简化了 MySQL 数据至 Kafka 的实时传输过程,无需额外基础设施配置。

- **4.2 实时数据集成实践

**- Flink CDC 3.0 支持模式进化、列操作和丰富的内置函数,提供了高度可定制的预处理能力,提升数据处理的灵活性与效率。

总结:Flink CDC 是一个高效、易用的实时数据集成框架,通过不断演进优化,满足了数据同步、分发和加载到数据仓库或数据湖的需求。社区活跃,支持多渠道沟通,鼓励代码贡献和用户参与,是实时数据处理领域的有力工具。

Flink介绍-《Fink原理、实战与性能优化》

在数据处理的进化版图上,Apache Flink以其独特的魅力脱颖而出,作为一款专为高吞吐量、低延迟和高性能设计的分布式流处理框架,它在实时数据世界中扮演着至关重要的角色。相较于传统的单体架构(集中式存储,维护复杂</)和微服务架构(独立服务,数据仓库繁复</),Flink以Lambda架构和有状态流计算为核心,为我们提供了一种更为高效且灵活的解决方案。 凭借其卓越的性能,Flink不仅支持实时流处理,还能够无缝整合批量计算,特别是在引入Google Dataflow模型后,它的吞吐量和延迟控制达到了前所未有的高度。Flink的亮点在于其强大的状态管理和分布式快照技术,即使在面对异常情况,也能保证数据处理的正确性和一致性,这是其在竞争激烈的流处理领域的一大亮点。 与其他框架相比,Flink的独特之处在于其独一无二的集成特性</,它超越了Spark和Storm,支持事件时间窗口计算,确保时序信息的准确。1.4版本引入的状态管理进一步提升了性能,使得处理复杂流传输变得更为灵活。Flink通过轻量级分布式快照机制实现容错,同时利用Save Points技术避免数据丢失,为实时推荐、欺诈检测和数仓分析等关键应用场景提供了强大支持。 Flink的架构设计精巧,分为API&Libraries、Runtime核心和物理部署三层。API层提供了DataStream和DataSet API,让用户可以方便地进行高级或基础的数据处理。Runtime核心则是分布式计算服务和任务调度的核心驱动力,Task Operator的转换则确保了计算的高效执行。物理部署层面,Flink兼容本地和云环境,适应各种部署需求。整个系统由JobManager(Master)和TaskManager(Worker)构成,通信基于Akka,用户可以提交任务并实时监控运行状态。 JobManager负责全局的调度和资源管理,而TaskManager则负责任务执行和资源的高效利用,多线程设计进一步提升了CPU的利用率,TaskManager通过资源共享实现更高的性能。Flink的世界,是性能与灵活性的完美结合,等待着你来探索和实践。下面哪些是flink架构的组成部分

下面哪些是flink架构的组成部分 Flink 是一个开源的分布式流处理框架,它由以下几个组成部分:Flink 运行时:负责管理 Flink 应用程序的执行,包括任务调度、资源管理、容错等。

Flink 库:提供各种功能,如数据流处理、批处理、图算法、机器学习等。

Flink SQL:一种用于数据仓库和流处理查询的查询语言,支持将 SQL 查询转换为 Flink 应用程序。

Flink Streaming:一种用于实时数据处理的高级流处理 API,支持事件驱动的流式应用程序。

Flink DataSet API:一种用于批处理和流处理的数据集 API,支持迭代式和批处理式的数据处理。

Flink YARN:一种用于在 YARN 上运行 Flink 应用程序的组件,支持在 Hadoop 生态系统中进行数据分析和处理。

这些组件共同构成了 Flink 框架,使开发人员能够构建高效、可扩展的实时数据处理应用程序。