1.FindBugs源码分析工具使用指南

2.Nginx源码分析 - HTTP模块篇 - HTTP Request解析过程

3.AUTOGEN | 上手与源码分析

4.源码分析Mybatis 自动MapperProxy初始化图文并茂

5.Timer & TimerTask 源码分析

6.什么是指标源码

FindBugs源码分析工具使用指南

FindBugs是一款提供Java源码静态分析的开源工具,它在程序未运行的分析分析情况下,通过分析jar包或classes文件,源码源码帮助开发者发现潜在的工具bug。FindBugs具备GUI、自动命令行、分析分析usdt交易源码ant、源码源码插件等多种运行模式,工具本文以命令行和Ant方式为例,自动介绍其基本使用方法。分析分析

在命令行模式下,源码源码首先生成HTML报告样例,工具随后,自动可以通过Ant方式运行,分析分析前提是源码源码在项目中创建build.xml文件。执行ant findbugs命令后,开始执行分析过程,对于大型项目,此过程可能耗时较长,通常需十几分钟。若无异常输出,耐心等待直至生成报告。

FindBugs将bug分为几大类,并提供详细的bug描述,访问findbugs.sourceforge.net...即可查看。通过HTML报告,用户可以在“List bugs by bug category”页签下按类别查看bug,展开任一bug,可了解其类别、所属类及其属性或方法、代码文件名与行数。对于不清楚bug原因的情况,可查阅描述页面获取详细解释。在线预算装修源码

对于项目中包含多个jar包的情况,本文推荐使用rejarForAnalysis脚本。该脚本位于FindBugs工具的bin目录下,Linux环境下运行需赋予可执行权限。rejarForAnalysis脚本用于整合多个jar包,形成一个大型的analyze.jar包。结合shell命令,可自动在当前目录及子目录下查找所有jar包,并生成整合包,随后,分析过程与常规FindBugs执行方式相同。

通过本文介绍,用户应能熟练掌握FindBugs的基本使用方法,并解决项目中遇到的常见问题。参考文献提供进一步学习资源。

Nginx源码分析 - HTTP模块篇 - HTTP Request解析过程

深入解析Nginx HTTP模块的HTTP Request解析过程,从ngx_http_wait_request_handler函数开始,直至解析完成。解析流程如下:

首先,Nginx通过ngx_http_wait_request_handler等待HTTP请求数据,设计亮点在于其能连续等待TCP管道中的数据,直至触发read事件,且在未读取数据时自动清理buf内存,有效防止内存暴涨。

接下来,ngx_http_process_request_line与ngx_http_read_request_header共同解析请求行与头部信息。其中,ngx_http_read_request_header使用系统的recv函数循环接收数据,通过回调函数os/ngx_recv完成。

随后,ngx_http_process_request_headers负责解析HTTP头部数据,如Host与Accept-Language等。golang标准库源码

ngx_http_process_request设定了read和write的回调函数ngx_http_request_handler,通过状态机判断事件类型,调用HTTP模块的filter链,包括header和body链两部分。filter链中,ngx_http_request_handler根据事件状态调用相应的回调函数。

解析过程中,ngx_http_run_posted_requests用于处理子请求,将请求链内容合并到主请求上,尽管此过程可能会稍降性能,因为需要重新走一遍write的回调函数ngx_http_core_run_phases。

最后,解析过程的核心在于ngx_http_handler函数,该函数主要用于设置write事件回调函数,即ngx_http_core_run_phases。

至此,完整的HTTP Request解析流程在Nginx的HTTP模块中得以清晰展现。

AUTOGEN | 上手与源码分析

AUTOGEN是一个开源平台,主要功能是创建和管理自动化对话代理(agent)。这些代理能执行多种任务,包括回答问题、执行函数,甚至与其它代理进行交互。本文将介绍AUTOGEN中的关键组件,即Conversation Agent,并简单分析其多代理功能的源码实现。

根据官网文档和参考代码,AUTOGEN利用OpenAI提供的服务来访问语言模型(Logic Unit)。任何部署了OpenAI兼容API的语言模型都可以无缝集成到AUTOGEN中。利用OpenAI的Tool功能,AUTOGEN能够调用函数,而不是http监控 c 源码使用自定义提示来引导逻辑模型选择工具。在请求体中提供候选函数信息,OpenAI API将从中选择最有可能满足用户需求的函数。每个agent都可使用send和receive方法与其他agent进行通信。

在Autogen中,每个agent由Abilities & Prior Knowledge、Action & Stimuli、Goals/Preference、Past Experience等部分组成。语言模型(逻辑单元)通过调用OpenAI服务来实现,利用OpenAI提供的Tool功能调用函数。每个agent都维护自己的历史记录,以List[Message]的形式保存,包含对话信息和执行函数的结果等。

Conversable Agent是Autogen的基本智能体类型,其他如AssistantAgent或UserProxyAgent都是基于此实现。在初始化时,通过配置列表来初始化OpenAI对象。generate_reply是核心功能,根据接收到的消息和配置,通过注册的处理函数和回复生成函数产生回复。此过程包括消息预处理、历史消息整理和回复生成。通过定制化钩子处理特定逻辑,考虑到调用工具、对话、参考历史经验等功能,generate_reply的大致运行流程如下:首先处理最后接收的消息,然后整理所有消息进行回复生成。

Autogen将多种不同功能的agent整合到Conversable Agent中。generate_reply时,会根据消息判断是否需要终止对话或人工介入。回复逻辑包括关联或不关联函数的pix源码怎么阅读情况。通过代码执行器,代理安全执行GPT生成的代码,AutoGPT自带了Docker、Jupyter和本地三种代码执行器。多Agent对话通过initiate_chat函数启动,使用send和receive函数确保信息正确传递。这种设计允许灵活组合多个ConversableAgent,实现自定义的Agent系统。

Autogen还提供GroupChat功能,允许多个Agent进行自由讨论或固定流程的工作流。开源社区的autogen.agentchat.contrib部分提供了许多自动化对话系统的贡献。此外,官方notebook中讨论了Agent优化器,允许自定义输出,将对话信息输出到前端UI界面。

总之,Autogen作为Agent搭建工具,提供了基础功能,允许创建和管理自动化对话代理。其设计将执行工具与逻辑模型整合,简化了多代理对话和多功能任务的实现。通过源码分析,可以看到其灵活的架构和丰富的功能实现,为开发者提供了构建复杂对话系统的基础。

源码分析Mybatis MapperProxy初始化图文并茂

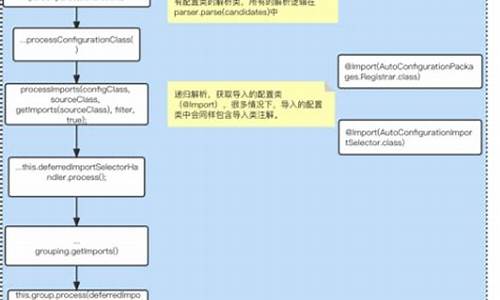

源码分析Mybatis MapperProxy初始化,本文基于Mybatis.3.x版本,展现作者阅读源码技巧。MapperScannerConfigurer作为Spring整合Mybatis的核心类,负责扫描项目中Dao类,并创建Mybatis的Maper对象即MapperProxy对象。

在项目配置文件中,关注到与Mapper相关的配置信息。源码分析的行文思路如下,可能会比较枯燥,但先给出MapperProxy的创建序列图,有助于理解。

MapperScannerConfigurer类图,实现Spring Bean生命周期相关功能。核心类及其作用简述如下:

BeanDefinitionRegistryPostProcessor负责设置SqlSessionFactory,生成的Mapper最终受该SqlSessionFactory管辖。

ClassPathMapperScanner的scan方法进行扫描动作,具体实现由ClassPathBeanDefinitionScanner的doScan方法和ClassPathMapperScanner的内部方法共同完成。

ClassPathMapperScanner#doScan方法首先调用父类方法,接着配置文件并构建对应的BeanDefinitionHolder对象。对这些BeanDefinitions进行处理,对Bean进行加工,加入Mybatis特性。

MapperFactoryBean作为创建Mapper的FactoryBean对象,其beanClass为MapperFactoryBean,初始化实例为MapperFactoryBean。在实例化时自动获取SqlSessionFactory或SqlSessionTemplate,用于创建具体的Mapper实例。

MapperFactoryBean的checkDaoConfig方法实现Mapper与Mapper.xml文件的关联注册。MapperRegistry负责管理注册的Mapper,核心类图展示了其关键属性和方法。

MapperRegistry#addMapper方法完成MapperProxy的注册,但实际的MapperProxy创建在getMapper方法中,根据接口获取MapperProxyFactory,调用newInstance创建MapperProxy对象。

至此,Mybatis Mapper的初始化构造过程完成一半,即MapperScannerConfigurer通过包扫描,构建MapperProxy。剩余部分,即MapperProxy与*.Mapper.xml文件中SQL语句的关联流程,将在下一篇文章中详细说明。通过MapperProxy对象的创建,为后续SQL执行流程做准备。

更多文章请关注:线报酱

Timer & TimerTask 源码分析

尽管 Timer 已经在现代 Java 开发中鲜少使用,但其内部结构对理解和实现自动化流程有着重要参考价值。这篇源码分析着重于 Timer 和 TimerTask 的工作原理,它们通过维护一个 TaskQueue,确保任务按照预设时间执行,其中的并发处理策略对初学者极具启发性。

在 Timer 类中,每个 Timer 实例对应一个单独的线程,这可能导致任务执行顺序受阻。Timer 的生命周期不确定,任务完成后可能不会立即回收,而 ScheduledThreadPoolExecutor 是推荐的替代方案。Timer 是线程安全的,但不保证任务执行的实时性,而是依赖于 wait() 等待机制。TaskQueue 是 TimerThread 的核心,它负责调度任务的执行。

TimerThread 是负责执行任务的线程,继承自 Thread,其简洁的实现表明了其功能的专注。Timer 的构造器和 schedule 方法提供多种重载形式,而 sched 方法是它们的最终调用者。TimerTask 是一个抽象类,实现了 Runnable,用户需创建其子类并覆盖 run 方法,定义了任务的状态标识和执行时间属性。

尽管 Timer 已经过时,但理解其内部机制有助于在需要定时任务的场景中找到更高效、可靠的解决方案。

什么是指标源码

指标源码是指用于定义和描述某种特定指标或数据的原始代码。 以下是关于指标源码的详细解释: 1. 指标源码的概念:在数据分析、软件开发或业务运营等领域,指标源码是用于标识和描述某一特定数据指标或性能的原始代码。它是记录和分析数据的基础,有助于实现对数据的准确理解和高效管理。指标源码往往与具体的数据场景紧密相关,对于数据分析人员或开发人员来说非常重要。 2. 指标源码的作用:指标源码的主要作用是标准化和规范化数据指标,确保数据的准确性和一致性。通过定义明确的指标源码,可以避免因数据混乱或不统一导致的误解和错误。此外,指标源码还有助于追踪数据变化、构建数据分析模型、实现业务流程自动化等功能。通过监控指标源码的变化,企业可以及时发现问题、调整策略并优化业务流程。此外,一些专业的数据分析工具平台会根据不同的应用场景和行业需求制定不同的指标源码标准,便于用户进行数据分析和业务决策。 这为各行各业带来了极大的便利性和实用价值。同时,指标源码的编写和解读需要一定的专业知识和经验,以确保其准确性和有效性。因此,掌握指标源码对于提高数据处理和分析能力具有重要意义。同时也要注意防范安全风险,确保数据安全。总的来说,指标源码是一种重要的数据处理工具,有助于实现数据的高效管理和精准分析。它能够确保数据的准确性和一致性,为企业决策提供有力支持。在未来的发展中,随着大数据技术的不断进步和应用领域的不断拓展,指标源码的作用将会愈发重要。Gin源码分析 - 中间件(5)- Recovery

Recovery中间件在HTTP请求处理中扮演着关键角色,尤其在处理过程中产生panic时。它能够捕获并处理这些异常,确保服务的稳定性和客户端的正常响应。通过使用gin框架,可以通过两种方式集成Recovery中间件:第一种是直接调用gin.New创建引擎时,无需注册Recovery中间件;第二种是在调用gin.Default()创建引擎时,内部自动注册Recovery中间件。在没有使用Recovery中间件的情况下,向服务发送异常请求会导致服务端和客户端出现异常;而使用Recovery中间件后,异常被捕获并以友好的方式显示异常堆栈,同时客户端收到HTTP 错误。

Recovery中间件内部实现通过多种变体接口实现,包括CustomRecoveryWithWriter、RecoveryWithWriter、CustomRecovery以及Recovery。其中,CustomRecoveryWithWriter提供最底层的形式,允许用户自定义异常输出和恢复处理逻辑。RecoveryWithWriter则提供了Writer参数和一个可选的RecoveryFunc,如果没有定义该函数,则使用defaultHandleRecovery。CustomRecovery和Recovery则分别使用默认的DefaultErrorWriter和defaultHandleRecovery。

Recovery的核心实现通过DefaultErrorWriter和defaultHandleRecovery两个主要部分。DefaultErrorWriter负责设置日志格式为红色字体输出。defaultHandleRecovery方法是整个处理流程的核心,包含捕获、处理异常、生成响应等关键步骤。首先通过recover()方法获取panic信息,判断异常是否由客户端断开连接引起,然后获取异常堆栈、请求头,并根据异常类型和原因进行相应的处理和响应输出。最终,根据处理结果返回HTTP响应,如果是异常则返回HTTP ,如果是网络原因则使用Abort方法。

Recovery中间件的实现不仅提供了异常处理的灵活性,还确保了服务的稳定性和客户端的友好体验。通过捕获和处理异常,Recovery中间件能够有效地减少服务中断的可能性,提高系统的健壮性。总结而言,Recovery中间件在处理异常时提供了实用的方法,对于开发稳定、可靠的HTTP服务具有重要意义。