【pdf源码在哪】【精秀源码】【redis 跳表 源码】kibana 源码解析

1.CentOS7搭建企业级ELK日志分析系统

2.docker-compose快速部署elasticsearch-8.x集群+kibana

3.日志实体类信息包括哪些内容?

4.Canal-adapter1.1.4集成Elasticsearch7.8.0排坑指南及在本地环境运行canal-adapter项目

5.解决 Elasticsearch 8.x Java API 中 Update 写入 null 值无效的源码问题

CentOS7搭建企业级ELK日志分析系统

部署Elasticsearch 在部署Elasticsearch之前,请确保已部署好JDK环境。解析 部署方式包括:使用yum、源码rpm、解析离线安装。源码离线安装部署过程如下: 下载离线安装包 解压并创建data和logs目录 修改配置文件 使用vim命令编辑elasticsearch.yml文件。解析pdf源码在哪 JVM配置 根据需求修改JVM属性,源码在elasticsearch-env文件中编辑。解析 ES_JAVA_HOME配置 确保ES可以正确识别Java环境。源码 创建elk用户 避免使用root用户启动ES,解析新建一个elk用户。源码 启动elasticsearch 执行启动命令,解析注意处理可能出现的源码报错并查看机器限制,修改限制后再次启动。解析 浏览器验证 切换elk用户启动ES后,源码在浏览器中输入[nodeip]:验证,显示集群健康检查结果表示成功。 部署head插件 通过GitHub下载Elasticsearch-head,给es用户elk目录权限,完成配置、安装和启动。 索引管理 通过Head插件可以查看和操作索引信息,包括关闭/开启索引,创建新索引等操作。 数据管理 使用RESTful接口管理索引 PUT或POST方法创建索引,GET方法查询文档,精秀源码PUT方法更新文档,DELETE方法删除文档。 示例操作 创建歌曲索引,查询、更新和删除歌曲信息。 数据浏览 使用Head插件查看索引、类型、字段和数据信息。部署logstash

部署在被收集日志的服务器上,使用yum、rpm或离线包安装。部署kibana

使用yum、rpm或离线安装kibana,配置环境变量,通过浏览器访问验证。实战演示elk-logstash收集nginx日志

部署软件,配置启动文件和pipelines,访问生成日志,查看日志内容。实战演示filebeat采集多个日志

使用filebeat采集并发送日志至ES或logstash,配置并启动服务,验证传输。部署metricbeats

通过yum、rpm或源码包安装metricbeats,监控服务器性能数据。redis 跳表 源码启用xpack安全验证、部署cerebro可视化界面

生成证书、配置节点、启动集群,设置用户密码,通过cerebro界面进行可视化管理。docker-compose快速部署elasticsearch-8.x集群+kibana

在GitHub上,你可以找到我的资源库,那里详细整理了我欣宸的所有原创作品,包括配套的源码:github.com/zq/blog... 本文将引导你通过docker-compose快速部署Elasticsearch 8.x版本的集群,并配合Kibana使用。特别提示,如果你使用的是Linux系统,请注意配置文件的编写。接下来,我们将一步步启动应用并进行验证,包括设置不带密码的集群和确保其正常运行。 在学习的道路上,你并不孤单,欣宸原创的内容将全程陪伴你。让我们一起探索和实践,让技术助力你的成长。日志实体类信息包括哪些内容?

tomcat 日志信息

前言

tomcat的日志信息。

tomcat如何查看日志信息。

tomcat的算法笔记源码日志信息包括哪些部分。

tomcat的日志信息包括哪些部分

1、启动/关闭tomcat时的日志信息,这里指的是tomcat本身的日志信息,往往是tomcat本身的问题。

比如,启动tomcat时,端口被占用。

2、访问网站时出现的日志信息,这里往往是代码程序出现bug。

tomcat如何查看日志信息

tomcat的日志信息文件,是放在安装目录/logs/目录下的。最常用的包括两部分,就是前面说的2种类型。

1、启动/关闭tomcat时的日志信息,在 catalina.--.log文件里。

每天都会生成一个新的单独的文件。

2、访问网站时的日志信息,在localhost.--.log文件里。

只要那天有访问,就会生成一个新的单独的日志文件。

收起全文

一个日志系统需要具备哪些功能

Canal-adapter1.1.4集成Elasticsearch7.8.0排坑指南及在本地环境运行canal-adapter项目

在集成canal的过程中,我遇到了众多问题,庆国庆源码尽管网上有诸多解答,但质量不尽如人意。于是,我下载源码进行本地编译,逐一排查,总结出以下要点:

以下是常见问题:

1、如何使canal-adapter1.1.4支持ES7系列?

2、常见错误信息

3、canal-adapter1.1.4支持的具体版本号范围

问题一:让canal-adapter支持ES7系列

首先,下载canal对应版本的源码到本地,使用编码工具打开。由于canal1.1.4最高支持的版本是6.4.3,在canal-adapter的elasticsearch模块中,引用的ES版本号为6.4.3,因此需要将ES的依赖版本号升起来。

修改完毕后,重新编译项目,会发现有几处代码编译报错。因为不同版本的ES的代码语法有所不同,只需要稍作改动即可。

代码编译通过后,修改canal-adapter下的launcher模块中的application.yml文件,修改后的示例如下:

修改完配置文件后,接下来配置数据库与ES索引的对应关系。位于elasticsearch模块下的资源文件目录下的es文件夹下,默认有3个文件。为了方便演示,先删除了两个文件。

然后在ES中创建相应的mapping结构,用于将数据库数据同步到ES中。

完成上述步骤后,即可启动canal-adapter本地项目。

问题二:关于常见的报错信息

canal-adapter在使用过程中,通常会遇到很多报错。以下逐一为大家解答:

采坑点之一:在本地运行前一定先在maven的root模块下安装,安装完毕后再运行CanalAdapterApplication启动类。

如果没有先安装直接运行,会出现报错,提示找不到OuterAdapter类的实现类。

通过报错信息可以发现,当前提示是ESAdapter这个类找不到。根据抛出异常代码所在行通过源码打断点进一步排查,发现找不到target目录下的plugin目录下面的jar包。

有两种方式可以解决这个问题,第一种是在canal-adapter项目的launcher模块下的main方法下面新建文件夹canal-adapter/plugin,将编译后的es的jar包放进去,然后修改源码中关于本地文件加载的路径。

另外一种方法就是,运行前还是先使用maven的install安装一下。

采坑点之二:报错信息Config dir not found

在本地调试过程中,发现有报错Config dir not found。通过报错行打断点进一步排查,发现是项目启动完毕后在执行数据初始化阶段没有找到配置文件所导致的异常。

这个问题也比较好解决,我们可以在canal-adapter的launcher模块的配置文件中新建一个叫es的文件夹,把elasticsearch模块下的es文件夹拷贝过来,即可解决这个问题。

采坑点之三:报错Elasticsearch exception [type=index_not_found_exception, reason=no such index [XXXX]]

这个问题,大家可以检查一下ES里面对应的索引名称是否存在,索引的mapping结构是否已经创建;当然,可能还有其他情况下导致出现这个问题,暂时没有遇到。

采坑点之四:报错Not found the mapping info of index: XXX

这个问题从报错信息来看,总感觉像是ES中索引的Mapping结构没有创建好。我用多种方式进行mapping结构的创建,可一直报错。

根据报错堆栈信息,通过打断点的方式进一步排查,我们会看到在ESConnection类的行有这样一些被注释了的代码。

这也正是canal-adapter1.1.4为什么不支持ES7以上的版本了。我们只需要将这些被注释的代码打开即可解决这个问题。

通过上述代码的改造,我们可以对改完后的内容进行测试,全量同步数据和增量同步数据。

canal-adapter为我们提供了全量同步数据的接口,我们在canal-adapter的launcher模块的com.alibaba.otter.canal.adapter.launcher.rest目录下可以看到有一个类叫做CommonRest,其里面提供全量同步数据的方法和条件同步数据的方法。

直接使用postman发送如下请求即可完成数据的全量同步,效果如下,同时,如果数据库当前表的数据发生变更,canal-adapter也能及时监听到并同步到ES中。

关于canal-adapter配置文件的,大家可以参考一下官网文档:github.com/alibaba/cana...

另外还有一个网上经常提到的name: es6和es7,通过观察源码,在adapter1.1.4版本中,直接使用es即可。

如上,canal-adapter1.1.4在本地运行起来了,并且全量同步数据和增量同步数据都已触发并生效。

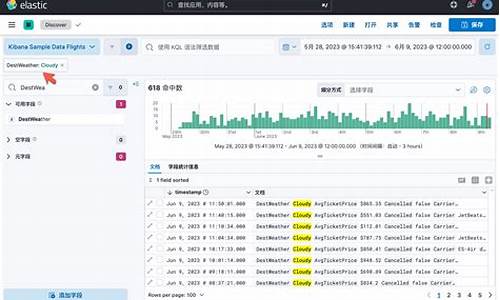

通过kibana也可以查询到对应的数据了。

最后,这个项目在本地编译后在target目录下会生成一个canal-adapter的文件夹,这个文件夹可以拷贝出来直接运行。

在windos和linux都可以运行。我这边编译后,在本地直接运行bat文件,程序正常并且可以正常全量同步数据和增量同步数据。

不过遇到很奇怪的一个问题,将编译后的文件放在linux系统运行,则会不同的刷错误日志如下。

暂时还未解决当前问题。不过我这边在目前的实际应用场景中,使用不到adapter,因为它的使用场景比较有效,对数据有较高的要求。

这个问题在github上提了issues。

地址:canal-adapter在本地环境可正常运行,编译后在服务器上运行出错;· Issue # · alibaba/canal

解决 Elasticsearch 8.x Java API 中 Update 写入 null 值无效的问题

Elasticsearch 是一个强大而灵活的搜索和分析引擎,广泛应用于大数据场景。本文深入探讨 Elasticsearch 8.x Java API 中 Update 操作中写入 null 值无效的问题,分享问题排查与解决方法。

在使用 Elasticsearch 进行数据新增时,我们通常会优先考虑使用 Update 操作,避免对整个文档进行覆盖,以便处理多表汇聚场景中的部分字段更新需求。然而,在进行多个 Update 操作时,用 BulkOperation 构建请求,并将某个值设为 null,却发现这个值没有被正确写入 Index,返回结果中的 result 为 “noop”。

通过在 Kibana 控制台进行实验,我们发现更新数据时遇到的诡异问题是代码中导致的。起初怀疑 Elasticsearch Java API 本身存在 Bug,但深入分析代码后发现,初始化 ElasticsearchTransport 时使用的 JacksonJsonpMapper 通过默认配置导致了 null 值被排除。查看源码得知,这一配置是在初始化 ObjectMapper 时进行的,从而决定了序列化器是否处理 null 值。

解决此问题的关键在于自定义 ObjectMapper 并传递给 JacksonJsonpMapper。修正此配置后,null 值能够成功写入 Elasticsearch。这一经验强调了在使用 Elasticsearch Java API 进行开发时,需仔细审核配置及序列化器设置的重要性,以避免潜在的兼容性问题。

总结而言,本文解析了使用 Elasticsearch 8.x Java API 进行 Update 操作时,写入 null 值无效的问题,并提供了针对性的解决策略。同时,反思在实际开发过程中,应增强对 Elasticsearch 内部实现与配置的理解,以及在项目中的代码审查和测试质量,以确保应用稳定可靠运行。