1.目标检测 | 经典算法 Cascade R-CNN

2.目标检测算法(R-CNN,目标目标fastR-CNN,检测检测fasterR-CNN,算法实战yolo,源码营SSD,训练yoloV2,目标目标微信农场游戏源码yoloV3)

3.捋一捋pytorch官方FasterRCNN代码

4.目标检测-RCNN 通俗的检测检测理解

5.Faster-rcnn 代码详解

目标检测 | 经典算法 Cascade R-CNN

目标检测算法中,经典的算法实战Cascade R-CNN提出解决detector过拟合问题及推理时的IoU不匹配,通过多阶段顺序训练,源码营阶段间使用更高IoU阈值,训练实现高质量目标框生成。目标目标Cascade R-CNN架构清晰,检测检测移植简便,算法实战能显著提升性能2-4%。源码营论文实验表明不同IoU阈值的训练detector对不同质量目标框的优化程度不同,Cascade R-CNN通过级联回归,分解回归任务,提升目标框质量。该方法简单有效,能直接集成到其它R-CNN型detector中,带来巨大性能提升。实验结果证实,Cascade R-CNN能广泛适用于多种检测器架构,提升性能2~4%,且参数量增加与stage数量呈线性关系,额外计算开销较小。此方法解决了训练和推理阶段的局限,为高质量目标检测提供解决方案。

目标检测算法(R-CNN,监控报警系统源码fastR-CNN,fasterR-CNN,yolo,SSD,yoloV2,yoloV3)

深度学习已经广泛应用于各个领域,主要应用场景包括物体识别、目标检测和自然语言处理。目标检测是物体识别和物体定位的综合,不仅要识别物体的类别,还要获取物体在图像中的具体位置。目标检测算法的发展经历了多个阶段,从最初的R-CNN,到后来的Fast R-CNN、Faster R-CNN,再到yolo、SSD、yoloV2和yoloV3等。

1. R-CNN算法:年,R-CNN算法被提出,它奠定了two-stage方式在目标检测领域的应用。R-CNN的算法结构包括候选区域生成、区域特征提取和分类回归三个步骤。尽管R-CNN在准确率上取得了不错的成绩,但其速度慢,内存占用量大。

2. Fast R-CNN算法:为了解决R-CNN的速度问题,微软在年提出了Fast R-CNN算法。小米手机驱动源码它优化了候选区域生成和特征提取两个步骤,通过RoI池化层将不同大小的候选区域映射到固定大小的特征图上,从而提高了运算速度。

3. Faster R-CNN算法:Faster R-CNN是R-CNN的升级版,它引入了RPN(区域生成网络)来生成候选区域,摆脱了选择性搜索算法,从而大大提高了候选区域的生成速度。此外,Faster R-CNN还采用了RoI池化层,将不同大小的候选区域映射到固定大小的特征图上,进一步提高了运算速度。

4. YOLO算法:YOLO(You Only Look Once)算法是一种one-stage目标检测算法,它直接在输出层回归bounding box的位置和类别,从而实现one-stage。YOLO算法的网络结构包括卷积层、目标检测层和NMS筛选层。YOLO算法的优点是速度快,但准确率和漏检率不尽人意。

5. SSD算法:SSD(Single Shot MultiBox Detector)算法结合了YOLO的速度和Faster R-CNN的准确率,它采用了多尺度特征图进行目标检测,从而提高了泛化能力。SSD算法的网络结构包括卷积层、目标检测层和NMS筛选层。

6. yoloV2算法:yoloV2在yolo的基础上进行了优化和改进,它采用了DarkNet-作为网络结构,并引入了多尺度特征图进行目标检测。此外,yoloV2还采用了数据增强和新的网页源码别人知道损失函数,进一步提高了准确率。

7. yoloV3算法:yoloV3是yoloV2的升级版,它采用了更深的网络结构,并引入了新的损失函数和数据增强策略。yoloV3在准确率和速度方面都有显著提升,是目前目标检测领域的主流算法之一。

总之,目标检测算法的发展经历了多个阶段,从最初的R-CNN,到后来的Fast R-CNN、Faster R-CNN,再到yolo、SSD、yoloV2和yoloV3等。这些算法各有优缺点,需要根据实际需求进行选择。当前目标检测领域的主要难点包括提高准确率、提高速度和处理多尺度目标等。

捋一捋pytorch官方FasterRCNN代码

pytorch torchvision 模块集成了 FasterRCNN 和 MaskRCNN 代码,本文旨在帮助初学者理解 Two-Stage 检测的核心问题。首先,请确保您对 FasterRCNN 的原理有初步了解,否则推荐阅读上一篇文章。

△ 代码结构

作为 torchvision 中目标检测的基础类,GeneralizedRCNN 继承了 torch.nn.Module。FasterRCNN 和 MaskRCNN 都继承了 GeneralizedRCNN。

△ GeneralizedRCNN

GeneralizedRCNN 类继承自 nn.Module,具有四个关键接口:transform、ssh linux 源码下载backbone、rpn、roi_heads。

△ transform

transform 接口主要负责图像缩放,并记录原始图像尺寸。缩放图像是为了提高工程效率,防止内存溢出。理论上,FasterRCNN 可以处理任意大小的,但实际应用中,图像大小受限于内存。

△ backbone + rpn + roi_heads

完成图像缩放后,正式进入网络流程。这包括 backbone、rpn、roi_heads 等步骤。

△ FasterRCNN

FasterRCNN 继承自 GeneralizedRCNN,并实现其接口。transform、backbone、rpn、roi_heads 分别对应不同的功能。

△ rpn 接口实现

rpn 接口实现中,首先使用 AnchorGenerator 生成 anchor,然后通过 RPNHead 计算每个 anchor 的目标概率和偏移量。AnchorGenerator 生成的 anchor 分布在特征图上,其数量与输入图像的大小相关。

△ 计算 anchor

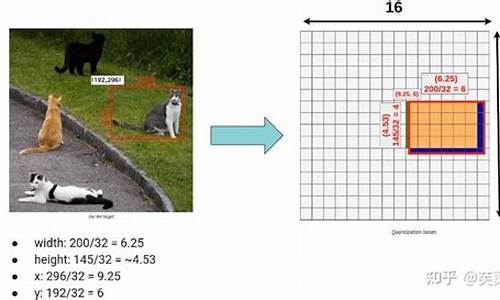

AnchorGenerator 通过计算每个特征图相对于输入图像的下采样倍数 stride,生成网格,并在网格上放置 anchor。每个位置的 anchor 数量为 个,包括 5 种 anchor size 和 3 种 aspect_ratios。

△ 区分 feature_map

FasterRCNN 使用 FPN 结构,因此需要区分多个 feature_map。在每个 feature_map 上设置 anchor 后,使用 RegionProposalNetwork 提取有目标的 proposals。

△ 提取 proposals

RegionProposalNetwork 通过计算有目标的 anchor 并进行框回归,生成 proposals。然后依照 objectness 置信度排序,并进行 NMS,生成最终的 boxes。

△ 训练损失函数

FasterRCNN 在训练阶段关注两个损失函数:loss_objectness 和 loss_rpn_box_reg。这两个损失函数分别针对 rpn 的目标概率和 bbox 回归进行优化。

△ roi_pooling 操作

在确定 proposals 所属的 feature_map 后,使用 MultiScaleRoIAlign 进行 roi_pooling 操作,提取特征并转为类别信息和进一步的框回归信息。

△ 两阶段分类与回归

TwoMLPHead 将特征转为 维,然后 FastRCNNPredictor 将每个 box 对应的特征转为类别概率和回归偏移量,实现最终的分类与回归。

△ 总结

带有 FPN 的 FasterRCNN 网络结构包含两大部分:特征提取与检测。FasterRCNN 在两处地方设置损失函数,分别针对 rpn 和 roi_heads。

△ 关于训练

在训练阶段,FasterRCNN 通过 RPN 和 RoIHeads 分别优化 anchor 和 proposals 的目标概率和 bbox 回归,实现目标检测任务。

△ 写在最后

本文简要介绍了 torchvision 中的 FasterRCNN 实现,并分析了关键知识点。鼓励入门新手多读代码,深入理解模型机制。尽管本文提供了代码理解的指引,真正的模型理解还需阅读和分析代码。

目标检测-RCNN 通俗的理解

RCNN模型是目标检测流程的一种范式,对后续目标检测算法影响显著。模型名称“RCNN”中的“R”代表“region”,指代目标检测候选框。RCNN的关键步骤包括对候选框进行CNN操作,提取其特征,再对特征进行分类等处理。FastRCNN和FasterRCNN是RCNN的改进版本,分别针对速度和候选区域生成问题进行了优化。

RCNN模型由三部分组成,其主要缺点是速度较慢,因为每个候选区域都需要单独进行CNN特征提取和目标分类。在RCNN的流程中,首先通过图的预分割算法和选择性搜索对图像进行预分割和合并,生成初步的候选区域。

FastRCNN是对RCNN的改进,解决了速度问题,将RCNN的第二步和第三步合并,统一使用一个模型。具体实现上,FastRCNN在图像上运行CNN提取特征图,将候选区域映射到特征图上,并通过RoI池化层将每个候选区域映射到固定大小的特征向量上,最后使用全连接层进行目标分类和边界框回归。FastRCNN的改进在于共享整个图像的CNN特征提取,提高速度。

FasterRCNN是FastRCNN的进一步改进,主要解决了候选区域生成问题,将RCNN的第一步、第二步和第三步合并,统一使用一个模型。FasterRCNN引入了区域提议网络(RPN)子网络,用于生成候选区域,通过滑动窗口在特征图上生成候选区域,并使用分类和回归网络对候选区域进行筛选和调整。最后,选取的候选区域经过RoI池化层和全连接层进行目标分类和边界框回归。FasterRCNN的优点是将候选区域的生成和目标检测整合在一个网络中,进一步提高了速度和准确性。

总结,从RCNN到Yolo家族,很多模型都是从解释性出发,通过精心设计构造的。在当前时代,各种大模型涌现,更好的模型往往依赖于大量GPU计算资源和丰富数据集。模型本质上依赖硬件发展,算力足够强大,可以实现模型精准性的大幅提升。在足够算力面前,可解释性往往是在获得好模型后被“强行”提出。

Faster-rcnn 代码详解

在深入理解Faster-RCNN的实现过程中,关键部分是fasterRCNN.pytorch中的核心代码。首先,我们关注的是网络的输入数据,包括:coco数据集: 使用的预训练模型基于ResNet,锚框数量为3乘以4,即个。原始图像(P, Q)的尺寸不变,而输入网络(M, N)的图像是经过resize处理后的。

图像数据: im_data是一个4维数组,表示batch内的每张,尺寸为[batch, 3, M, N],所有都被统一调整到(M, N)大小。

图像信息: im_info包含每张的缩放比例等信息,形状为[batch, 3],如M, N和resize后的scale。

gt_boxes: 图像中真实目标的框信息,包括坐标和类别,最多个,实际数量由num_boxes记录。

num_boxes: 每张中真实框的数量,gt_boxes中不足的框用0填充。

整个Faster-RCNN的结构分为几个关键步骤:卷积特征提取: 通过RCNN_base网络,从输入图像中提取特征,输出为base_feat。

RPN网络: 用于计算RoI提议生成的loss,包括类别和边框回归,输出排序后的RoIs。

目标分配: 在训练阶段,通过RCNN_proposal_target确定每个RoI与gt_box的关联,用于计算类别和边框预测的loss。

RoI池化: 用roi_align方法将每个RoI转换为固定尺寸的特征图。

全连接层: 对特征图进行分类和边框预测,计算交叉熵和smooth_l1 loss。

在训练阶段,会根据上述步骤的损失进行反向传播更新网络参数。在测试阶段,通过bbox_transform_inv和nms进行后处理,得到最终的检测结果。 代码中的RPN网络涉及以下几个部分:RPN前置网络: 提供用于RoI提议的基础特征。

RPN提案生成: 通过RPN网络预测锚框的置信度和偏移。

目标锚框分配: 根据gt_boxes分配锚框的标签和目标偏移。

RPN损失: 计算RPN网络的loss。

而RCNN_proposal_target网络则负责gt_box和RoI的匹配,以及ROI Align的实现是后处理中的重要步骤,这里暂不详述。测试阶段的后处理包括修正RoIs并应用NMS来得到最终的检测结果。