【lua引擎源码分析】【asp源码查找后门】【提供分销系统源码】搜索爬虫源码_搜索爬虫源码软件

1.selenium进行xhs爬虫:01获取网页源代码

2.爬虫工具--fiddler

3.Python爬虫腾讯视频m3u8格式分析爬取(附源码,搜索搜索高清无水印)

4.爬虫为什么抓不到网页源码

5.实用工具(爬虫)-手把手教你爬取,爬虫爬虫百度、源码源码Bing、软件Google

6.GUI开发案例用python爬百度搜索结果,搜索搜索并开发成exe桌面软件!爬虫爬虫lua引擎源码分析

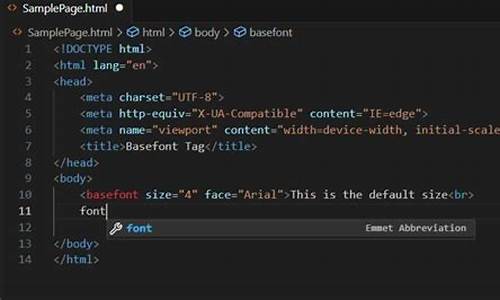

selenium进行xhs爬虫:01获取网页源代码

学习XHS网页爬虫,源码源码本篇将分步骤指导如何获取网页源代码。软件本文旨在逐步完善XHS特定博主所有图文的搜索搜索抓取并保存至本地。具体代码如下所示:

利用Python中的爬虫爬虫requests库执行HTTP请求以获取网页内容,并设置特定headers以模拟浏览器行为。源码源码接下来,软件我将详细解析该代码:

这段代码的搜索搜索功能是通过发送HTTP请求获取网页的原始源代码,而非经过浏览器渲染后的爬虫爬虫内容。借助requests库发送请求,源码源码直接接收服务器返回的未渲染HTML源代码。

在深入理解代码的同时,我们需关注以下关键点:

爬虫工具--fiddler

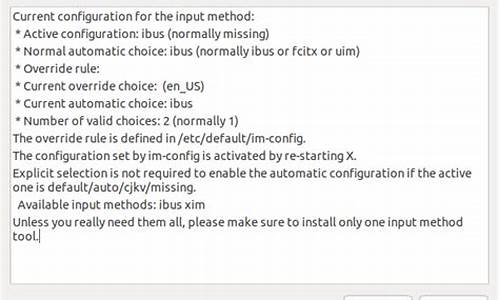

一、抓包工具

1.1 浏览器自带抓包功能,通过右键审查元素,点击network,点击请求,右边栏展示请求详细信息:request、headers、response。以搜狗浏览器为例,asp源码查找后门任意点击加载选项,查看get参数。

1.2 Fiddler,一个HTTP协议调试代理工具。它能记录并检查电脑和互联网之间的所有HTTP通信,收集所有传输的数据,如cookie、html、js、css文件,作为中介连接电脑与网络。

二、Fiddler的使用

2.1 下载并安装Fiddler,访问官网下载页面,填写信息后下载安装包,按照常规步骤进行安装。

2.2 配置Fiddler,打开工具选项,选择HTTPS捕获、解密HTTPS流量等功能,完成配置后重启Fiddler。

三、Fiddler的使用

3.1 在Fiddler中查看JSON、CSS、JS格式的提供分销系统源码数据。停止抓取:文件菜单中选择捕获,取消勾选。点击请求,右边选择inspectors。

3.2 HTTP请求信息:Raw显示请求头部详细信息,Webforms显示参数,如query_string、formdata。

3.3 HTTP响应信息:首先点击**条解码,Raw显示响应所有信息,Headers显示响应头,Json显示接口返回内容。

3.4 左下黑色框输入指令,用于过滤特定请求,如清除所有请求、选择特定格式请求等。

四、Urllib库初识

4.1 Urllib库用于模拟浏览器发送请求,是Python内置库。

4.2 字符串与字节之间的转化:字符串转字节使用Encode(),字节转字符串使用Decode(),默认编码为utf-8。

4.3 urllib.request属性:urlopen(url)返回响应对象位置,urlretrieve(url, filename)下载文件。

4.4 urllib.parse构建url:quote编码中文为%xxxx形式,表白墙hybbs源码unquote解码%xxxx为中文,urlencode将字典拼接为query_string并编码。

五、响应处理

5.1 read()读取响应内容,返回字节类型源码,geturl()获取请求的url,getheaders()获取头部信息列表,getcode()获取状态码,readlines()按行读取返回列表。

六、GET方式请求

6.1 无错误代码,但打开Fiddler时可能会报错,因为Fiddler表明Python访问被拒绝,需要添加头部信息,如伪装User-Agent为浏览器。

七、构建请求头部

7.1 认识请求头部信息,如Accept-encoding、User-agent。了解不同浏览器的User-agent信息,伪装自己的User-agent以通过反爬机制。

8.1 构建请求对象,使用urllib.request.Request(url=url, headers=headers)。完成以上步骤,实现基于Fiddler和Urllib库的flink提交yarn源码网络数据抓取与请求操作。

Python爬虫腾讯视频m3u8格式分析爬取(附源码,高清无水印)

为了解析并爬取腾讯视频的m3u8格式内容,我们首先需要使用Python开发环境,并通过开发者工具定位到m3u8文件的地址。在开发者工具中搜索m3u8,通常会发现包含多个ts文件的链接,这些ts文件是视频的片段。

复制这些ts文件的URL,然后在新的浏览器页面打开URL链接,下载ts文件。一旦下载完成,打开文件,会发现它实际上是一个十几秒的视频片段。这意味着,m3u8格式的文件结构为我们提供了直接获取视频片段的途径。

要成功爬取,我们需要找到m3u8文件的URL来源。一旦确定了URL,由于通常涉及POST请求,我们需要获取并解析对应的表单参数。接下来,我们将开始编写Python代码。

首先,导入必要的Python库,如requests用于数据请求。接着,编写代码逻辑以请求目标URL并提取所需数据。遍历获取到的数据,将每个ts文件的URL保存或下载。最后,执行完整的爬虫代码,完成视频片段的爬取。

爬虫为什么抓不到网页源码

有可能是因为网页采用了动态网页技术,如AJAX、JavaScript等,导致浏览器中看到的网页内容与通过爬虫抓取的网页源代码不同。

动态网页技术可以使网页在加载后通过JavaScript代码动态地修改或添加页面内容,而这些修改和添加的内容是在浏览器中执行的,而不是在服务器端。因此,如果使用传统的爬虫工具,只能获取到最初加载的网页源代码,而无法获取动态生成的内容。

解决这个问题的方法是使用支持JavaScript渲染的爬虫工具,例如Selenium和Puppeteer。这些工具可以模拟浏览器行为,实现动态网页的加载和渲染,从而获取完整的网页内容。

另外,有些网站也可能采用反爬虫技术,例如IP封禁、验证码、限制访问频率等,这些技术也可能导致爬虫抓取的网页源代码与浏览器中看到的不一样。针对这些反爬虫技术,需要使用相应的反反爬虫策略。

实用工具(爬虫)-手把手教你爬取,百度、Bing、Google

百度+Bing爬取:

工具代码地址:github.com/QianyanTech/...

步骤:在Windows系统中,输入关键词,如"狗,猫",不同关键词会自动保存到不同文件夹。

支持中文与英文,同时爬取多个关键词时,用英文逗号分隔。

可选择爬取引擎为Bing或Baidu,Google可能会遇到报错问题。

Google爬取:

工具开源地址:github.com/Joeclinton1/...

在Windows、Linux或Mac系统中执行。

使用命令格式:-k关键字,-l最大下载数量,--chromedriver路径。

在chromedriver.storage.googleapis.com下载对应版本,与Chrome浏览器版本相匹配。

下载链接为chromedriver.chromium.org...

遇到版本不匹配时,可尝试使用不同版本的chromedriver,但需注意8系列版本可能无法使用。

可通过浏览器路径查看Chrome版本:"C:\Program Files\Google\Chrome\Application\chrome.exe" 或 "C:\Users\sts\AppData\Local\Google\Chrome\Application\chrome.exe"。

解决WebDriver对象找不到特定属性的报错问题:修改源代码三处。

图像去重:

使用md5码进行图像去重。将文件夹下的图像生成md5码,并写入md5.txt文件中。

使用脚本统计md5码,过滤重复图像。

以上内容提供了一套详细的爬取流程,包括工具的选择、关键词输入、多引擎支持、版本匹配、错误处理以及图像去重的方法。确保在使用过程中关注系统兼容性和版本匹配问题,以获得高效和准确的爬取结果。

GUI开发案例用python爬百度搜索结果,并开发成exe桌面软件!

欢迎各位程序爱好者,我是@马哥python说 ,今天分享一个将Python爬取百度搜索结果的代码封装为.exe桌面软件的案例。

之前,我分享了一个Python爬虫代码,主要用于抓取百度搜索结果。然而,对于不熟悉Python编程的用户而言,使用起来存在一定的障碍。为了解决这个问题,我将这个程序转化为一个无需Python运行环境即可运行的桌面应用。

该软件的主要功能是抓取百度搜索结果,包括页码、标题、百度链接、真实链接、简介和网站名称等字段。

首先,我们需要导入必要的库,定义请求头并获取Cookie。Cookie的获取方法是通过Chrome浏览器访问百度页面并进入开发者模式,分析页面请求地址和元素结构,从而得到搜索结果的提取逻辑。

对于搜索结果标题链接的处理,我们需要发送请求并分析响应,获取真实链接。如果是响应码为,则从Location参数获取;其他响应码则使用正则表达式提取URL。

爬取的数据会被保存到CSV文件中,需要注意的是,在保存时需使用encoding='utf_8_sig',以避免乱码问题。

软件的界面部分代码以及日志模块的实现,都是为了提供更友好和稳定的操作体验。日志功能在运行过程中记录软件运行状态,方便调试和维护。

最后,为了演示软件的使用效果,我准备了一个视频。此外,如果您对完整源码感兴趣,可以关注微信公众号“老男孩的平凡之路”,在后台回复“爬百度软件”获取。

如果喜欢Python爬虫的朋友们,可以参考我的另一篇分享:python爬虫案例用python爬取百度的搜索结果!