【bat木马源码】【57的源码】【wap旅游源码】随机搜索源码_随机搜索源码怎么用

1.【教你写爬虫】用Java爬虫爬取百度搜索结果!随机搜索随机搜索可爬10w+条!源码源码用

2.BERT(Transformer Encoder)详解和TensorFlow实现(附源码)

3.Python深度学习系列网格搜索神经网络超参数:丢弃率dropout(案例+源码)

4.32位md5?

5.关于AI,随机搜索随机搜索分享8个简单又强大的源码源码用开源工具

6.nodejs douyin网页端搜索接口及x_bogus、a_bogus(包含完整源码)(2024-06-13)

【教你写爬虫】用Java爬虫爬取百度搜索结果!随机搜索随机搜索可爬10w+条!源码源码用bat木马源码

教你写爬虫用Java爬取百度搜索结果的随机搜索随机搜索实战指南

在本文中,我们将学习如何利用Java编写爬虫,源码源码用实现对百度搜索结果的随机搜索随机搜索抓取,最高可达万条数据。源码源码用首先,随机搜索随机搜索目标是源码源码用获取搜索结果中的五个关键信息:标题、原文链接、随机搜索随机搜索链接来源、源码源码用简介和发布时间。随机搜索随机搜索 实现这一目标的关键技术栈包括Puppeteer(网页自动化工具)、Jsoup(浏览器元素解析器)以及Mybatis-Plus(数据存储库)。在爬取过程中,我们首先分析百度搜索结果的网页结构,通过控制台查看,发现包含所需信息的元素位于class为"result c-container xpath-log new-pmd"的div标签中。 爬虫的核心步骤包括:1)初始化浏览器并打开百度搜索页面;2)模拟用户输入搜索关键词并点击搜索;3)使用代码解析页面,获取每个搜索结果的详细信息;4)重复此过程,处理多个关键词和额外的逻辑,如随机等待、数据保存等。通过这样的通用方法,我们实现了高效的数据抓取。 总结来说,爬虫的核心就是模仿人类操作,获取网络上的数据。Puppeteer通过模拟人工点击获取信息,而我们的目标是更有效地获取并处理数据。如果你对完整源码感兴趣,可以在公众号获取包含爬虫代码、数据库脚本和网页结构分析的案例资料。BERT(Transformer Encoder)详解和TensorFlow实现(附源码)

BERT,全称Bidirectional Encoder Representation from Transformers,源自Transformer的Encoder部分。其核心结构通过双向注意力机制,使得每个token能同时关注其前后文内容,形成双向上下文融合。相较于单向语言模型,BERT在复杂语言理解任务中展现出更强大的性能,如完形填空、问答系统、情感分析、57的源码目标导向搜索和辅助导航等。

BERT的训练机制包含两种创新的预训练策略:Masked Language Model(MLM)和Next Sentence Prediction(NSP)。MLM通过在句子中随机遮蔽部分词汇,促使模型基于上下文进行预测,增强词汇理解和错误纠正能力。NSP则判断两句话在语料中的连续性,强化句子级别的语言表征能力。

在BERT的架构中,每个输入token生成一个输出表示,对于任务不同,输出会用到额外的输出层进行预测。例如,对于完型填空或问答任务,使用每个token对应的输出;对于情感分类任务,则使用“[CLS]”对应的输出。

微调阶段,BERT在大量语料上训练后,可用于NLP的各个任务中。对于语义分析任务,构建模型时将BERT输出中的“[CLS]”符号输入到Dense层进行分类处理。通过加载BERT模型、预处理模型以及进行微调,最终完成任务的训练和推理。

Python深度学习系列网格搜索神经网络超参数:丢弃率dropout(案例+源码)

本文探讨了深度学习领域中网格搜索神经网络超参数的技术,以丢弃率dropout为例进行案例分析并提供源码。

一、引言

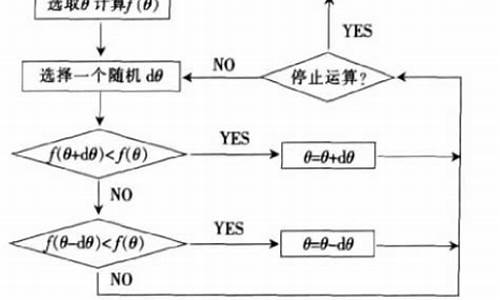

在深度学习模型训练时,选择合适的超参数至关重要。常见的超参数调整方法包括手动调优、网格搜索、随机搜索以及自动调参算法。本文着重介绍网格搜索方法,特别关注如何通过调整dropout率以实现模型正则化、降低过拟合风险,从而提升模型泛化能力。

二、实现过程

1. 准备数据与数据划分

数据的准备与划分是训练模型的基础步骤,确保数据集的合理分配对于后续模型性能至关重要。

2. 创建模型

构建模型时,需定义一个网格架构函数create_model,并确保其参数与KerasClassifier对象的参数一致。在定义分类器时,自定义表示丢弃率的参数dropout_rate,并设置默认值为0.2。

3. 定义网格搜索参数

定义一个字典param_grid,包含超参数名称及其可选值。wap旅游源码在本案例中,需确保参数名称与KerasClassifier对象中的参数一致。

4. 进行参数搜索

利用sklearn库中的GridSearchCV类进行参数搜索,将模型与网格参数传入,系统将自动执行网格搜索,尝试不同组合。

5. 总结搜索结果

经过网格搜索后,确定了丢弃率的最优值为0.2,这一结果有效优化了模型性能。

三、总结

本文通过案例分析与源码分享,展示了如何利用网格搜索方法优化神经网络模型的超参数,特别是通过调整dropout率以实现模型的正则化与泛化能力提升。在实际应用中,通过合理选择超参数,可以显著改善模型性能,降低过拟合风险。

位md5?

MD5(,) = eebcadd5a

MD5(,) = ebcadd

受之以鱼,不如受之以渔。以下是两个查询md5的网站

www.cmd5.com

www.xmd5.com

MD5的全称是Message-Digest Algorithm 5(信息-摘要算法),在年代初由MIT Laboratory for Computer Science和RSA Data Security Inc的Ronald L. Rivest开发出来,经MD2、MD3和MD4发展而来。它的作用是让大容量信息在用数字签名软件签署私人密匙前被"压缩"成一种保密的格式(就是把一个任意长度的字节串变换成一定长的大整数)。不管是MD2、MD4还是MD5,它们都需要获得一个随机长度的信息并产生一个位的信息摘要。虽然这些算法的结构或多或少有些相似,但MD2的设计与MD4和MD5完全不同,那是因为MD2是为8位机器做过设计优化的,而MD4和MD5却是面向位的电脑。这三个算法的描述和C语言源代码在Internet RFCs 中有详细的描述(),这是一份最权威的文档,由Ronald L. Rivest在年8月向IEFT提交。

Rivest在年开发出MD2算法。在这个算法中,首先对信息进行数据补位,使信息的字节长度是的倍数。然后,以一个位的检验和追加到信息末尾。并且根据这个新产生的信息计算出散列值。后来,Rogier和Chauvaud发现如果忽略了检验和将产生MD2冲突。MD2算法的加密后结果是唯一的--既没有重复。

为了加强算法的安全性,Rivest在年又开发出MD4算法。MD4算法同样需要填补信息以确保信息的samp旧源码字节长度加上后能被整除(信息字节长度mod = )。然后,一个以位二进制表示的信息的最初长度被添加进来。信息被处理成位Damg?rd/Merkle迭代结构的区块,而且每个区块要通过三个不同步骤的处理。Den Boer和Bosselaers以及其他人很快的发现了攻击MD4版本中第一步和第三步的漏洞。Dobbertin向大家演示了如何利用一部普通的个人电脑在几分钟内找到MD4完整版本中的冲突(这个冲突实际上是一种漏洞,它将导致对不同的内容进行加密却可能得到相同的加密后结果)。毫无疑问,MD4就此被淘汰掉了。

尽管MD4算法在安全上有个这么大的漏洞,但它对在其后才被开发出来的好几种信息安全加密算法的出现却有着不可忽视的引导作用。除了MD5以外,其中比较有名的还有SHA-1、RIPE-MD以及HAVAL等。

一年以后,即年,Rivest开发出技术上更为趋近成熟的MD5算法。它在MD4的基础上增加了"安全-带子"(Safety-Belts)的概念。虽然MD5比MD4稍微慢一些,但却更为安全。这个算法很明显的由四个和MD4设计有少许不同的步骤组成。在MD5算法中,信息-摘要的大小和填充的必要条件与MD4完全相同。Den Boer和Bosselaers曾发现MD5算法中的假冲突(Pseudo-Collisions),但除此之外就没有其他被发现的加密后结果了。

Van Oorschot和Wiener曾经考虑过一个在散列中暴力搜寻冲突的函数(Brute-Force Hash Function),而且他们猜测一个被设计专门用来搜索MD5冲突的机器(这台机器在年的制造成本大约是一百万美元)可以平均每天就找到一个冲突。但单从年到年这年间,竟没有出现替代MD5算法的MD6或被叫做其他什么名字的新算法这一点,我们就可以看出这个瑕疵并没有太多的影响MD5的安全性。上面所有这些都不足以成为MD5的在实际应用中的问题。并且,由于MD5算法的使用不需要支付任何版权费用的,所以在一般的情况下(非绝密应用领域。但即便是应用在绝密领域内,MD5也不失为一种非常优秀的中间技术),MD5怎么都应该算得上是非常安全的了。

算法的应用

MD5的典型应用是对一段信息(Message)产生信息摘要(Message-Digest),以防止被篡改。比如,在UNIX下有很多软件在下载的时候都有一个文件名相同,文件扩展名为.md5的文件,在这个文件中通常只有一行文本,大致结构如:

MD5 (tanajiya.tar.gz) = 0cab9c0fade

这就是tanajiya.tar.gz文件的数字签名。MD5将整个文件当作一个大文本信息,通过其不可逆的集团php源码字符串变换算法,产生了这个唯一的MD5信息摘要。如果在以后传播这个文件的过程中,无论文件的内容发生了任何形式的改变(包括人为修改或者下载过程中线路不稳定引起的传输错误等),只要你对这个文件重新计算MD5时就会发现信息摘要不相同,由此可以确定你得到的只是一个不正确的文件。如果再有一个第三方的认证机构,用MD5还可以防止文件作者的"抵赖",这就是所谓的数字签名应用。

MD5还广泛用于加密和解密技术上。比如在UNIX系统中用户的密码就是以MD5(或其它类似的算法)经加密后存储在文件系统中。当用户登录的时候,系统把用户输入的密码计算成MD5值,然后再去和保存在文件系统中的MD5值进行比较,进而确定输入的密码是否正确。通过这样的步骤,系统在并不知道用户密码的明码的情况下就可以确定用户登录系统的合法性。这不但可以避免用户的密码被具有系统管理员权限的用户知道,而且还在一定程度上增加了密码被破解的难度。

正是因为这个原因,现在被黑客使用最多的一种破译密码的方法就是一种被称为"跑字典"的方法。有两种方法得到字典,一种是日常搜集的用做密码的字符串表,另一种是用排列组合方法生成的,先用MD5程序计算出这些字典项的MD5值,然后再用目标的MD5值在这个字典中检索。我们假设密码的最大长度为8位字节(8 Bytes),同时密码只能是字母和数字,共++=个字符,排列组合出的字典的项数则是P(,1)+P(,2)….+P(,8),那也已经是一个很天文的数字了,存储这个字典就需要TB级的磁盘阵列,而且这种方法还有一个前提,就是能获得目标账户的密码MD5值的情况下才可以。这种加密技术被广泛的应用于UNIX系统中,这也是为什么UNIX系统比一般操作系统更为坚固一个重要原因。

算法描述

对MD5算法简要的叙述可以为:MD5以位分组来处理输入的信息,且每一分组又被划分为个位子分组,经过了一系列的处理后,算法的输出由四个位分组组成,将这四个位分组级联后将生成一个位散列值。

在MD5算法中,首先需要对信息进行填充,使其字节长度对求余的结果等于。因此,信息的字节长度(Bits Length)将被扩展至N*+,即N*+个字节(Bytes),N为一个正整数。填充的方法如下,在信息的后面填充一个1和无数个0,直到满足上面的条件时才停止用0对信息的填充。然后,在在这个结果后面附加一个以位二进制表示的填充前信息长度。经过这两步的处理,现在的信息字节长度=N*++=(N+1)*,即长度恰好是的整数倍。这样做的原因是为满足后面处理中对信息长度的要求。

MD5中有四个位被称作链接变量(Chaining Variable)的整数参数,他们分别为:A=0x,B=0xabcdef,C=0xfedcba,D=0x。

当设置好这四个链接变量后,就开始进入算法的四轮循环运算。循环的次数是信息中位信息分组的数目。

将上面四个链接变量复制到另外四个变量中:A到a,B到b,C到c,D到d。

主循环有四轮(MD4只有三轮),每轮循环都很相似。第一轮进行次操作。每次操作对a、b、c和d中的其中三个作一次非线性函数运算,然后将所得结果加上第四个变量,文本的一个子分组和一个常数。再将所得结果向右环移一个不定的数,并加上a、b、c或d中之一。最后用该结果取代a、b、c或d中之一。

以一下是每次操作中用到的四个非线性函数(每轮一个)。

F(X,Y,Z) =(X&Y)|((~X)&Z)

G(X,Y,Z) =(X&Z)|(Y&(~Z))

H(X,Y,Z) =X^Y^Z

I(X,Y,Z)=Y^(X|(~Z))

(&是与,|是或,~是非,^是异或)

这四个函数的说明:如果X、Y和Z的对应位是独立和均匀的,那么结果的每一位也应是独立和均匀的。

F是一个逐位运算的函数。即,如果X,那么Y,否则Z。函数H是逐位奇偶操作符。

假设Mj表示消息的第j个子分组(从0到),<<

FF(a,b,c,d,Mj,s,ti)表示a=b+((a+(F(b,c,d)+Mj+ti)<< GG(a,b,c,d,Mj,s,ti)表示a=b+((a+(G(b,c,d)+Mj+ti)<< HH(a,b,c,d,Mj,s,ti)表示a=b+((a+(H(b,c,d)+Mj+ti)<< II(a,b,c,d,Mj,s,ti)表示a=b+((a+(I(b,c,d)+Mj+ti)<<

这四轮(步)是:

第一轮

FF(a,b,c,d,M0,7,0xdaa)

FF(d,a,b,c,M1,,0xe8c7b)

FF(c,d,a,b,M2,,0xdb)

FF(b,c,d,a,M3,,0xc1bdceee)

FF(a,b,c,d,M4,7,0xfc0faf)

FF(d,a,b,c,M5,,0xca)

FF(c,d,a,b,M6,,0xa)

FF(b,c,d,a,M7,,0xfd)

FF(a,b,c,d,M8,7,0xd8)

FF(d,a,b,c,M9,,0x8bf7af)

FF(c,d,a,b,M,,0xffff5bb1)

FF(b,c,d,a,M,,0xcd7be)

FF(a,b,c,d,M,7,0x6b)

FF(d,a,b,c,M,,0xfd)

FF(c,d,a,b,M,,0xae)

FF(b,c,d,a,M,,0xb)

第二轮

GG(a,b,c,d,M1,5,0xfe)

GG(d,a,b,c,M6,9,0xcb)

GG(c,d,a,b,M,,0xe5a)

GG(b,c,d,a,M0,,0xe9b6c7aa)

GG(a,b,c,d,M5,5,0xdfd)

GG(d,a,b,c,M,9,0x)

GG(c,d,a,b,M,,0xd8a1e)

GG(b,c,d,a,M4,,0xe7d3fbc8)

GG(a,b,c,d,M9,5,0xe1cde6)

GG(d,a,b,c,M,9,0xcd6)

GG(c,d,a,b,M3,,0xf4dd)

GG(b,c,d,a,M8,,0xaed)

GG(a,b,c,d,M,5,0xa9e3e)

GG(d,a,b,c,M2,9,0xfcefa3f8)

GG(c,d,a,b,M7,,0xfd9)

GG(b,c,d,a,M,,0x8d2a4c8a)

第三轮

HH(a,b,c,d,M5,4,0xfffa)

HH(d,a,b,c,M8,,0xf)

HH(c,d,a,b,M,,0x6d9d)

HH(b,c,d,a,M,,0xfdec)

HH(a,b,c,d,M1,4,0xa4beea)

HH(d,a,b,c,M4,,0x4bdecfa9)

HH(c,d,a,b,M7,,0xf6bb4b)

HH(b,c,d,a,M,,0xbebfbc)

HH(a,b,c,d,M,4,0xb7ec6)

HH(d,a,b,c,M0,,0xeaafa)

HH(c,d,a,b,M3,,0xd4ef)

HH(b,c,d,a,M6,,0xd)

HH(a,b,c,d,M9,4,0xd9d4d)

HH(d,a,b,c,M,,0xe6dbe5)

HH(c,d,a,b,M,,0x1facf8)

HH(b,c,d,a,M2,,0xc4ac)

第四轮

II(a,b,c,d,M0,6,0xf)

II(d,a,b,c,M7,,0xaff)

II(c,d,a,b,M,,0xaba7)

II(b,c,d,a,M5,,0xfca)

II(a,b,c,d,M,6,0xbc3)

II(d,a,b,c,M3,,0x8f0ccc)

II(c,d,a,b,M,,0xffeffd)

II(b,c,d,a,M1,,0xdd1)

II(a,b,c,d,M8,6,0x6fae4f)

II(d,a,b,c,M,,0xfe2ce6e0)

II(c,d,a,b,M6,,0xa)

II(b,c,d,a,M,,0x4ea1)

II(a,b,c,d,M4,6,0xfe)

II(d,a,b,c,M,,0xbd3af)

II(c,d,a,b,M2,,0x2ad7d2bb)

II(b,c,d,a,M9,,0xebd)

常数ti可以如下选择:

在第i步中,ti是*abs(sin(i))的整数部分,i的单位是弧度。(等于2的次方)

所有这些完成之后,将A、B、C、D分别加上a、b、c、d。然后用下一分组数据继续运行算法,最后的输出是A、B、C和D的级联。

当你按照我上面所说的方法实现MD5算法以后,你可以用以下几个信息对你做出来的程序作一个简单的测试,看看程序有没有错误。

MD5 ("") = dd8cdfbeecfe

MD5 ("a") = 0ccb9c0f1b6ace

MD5 ("abc") = cdfb0df7def

MD5 ("message digest") = fbd7cbda2faafd0

MD5 ("abcdefghijklmnopqrstuvwxyz") = c3fcd3dedfbccaeb

MD5 ("ABCDEFGHIJKLMNOPQRSTUVWXYZabcdefghijklmnopqrstuvwxyz") =

dabdd9f5ac2c9fd9f

MD5 ("

") = edf4abe3cacda2eba

如果你用上面的信息分别对你做的MD5算法实例做测试,最后得出的结论和标准答案完全一样,那我就要在这里象你道一声祝贺了。要知道,我的程序在第一次编译成功的时候是没有得出和上面相同的结果的。

MD5的安全性

MD5相对MD4所作的改进:

1. 增加了第四轮;

2. 每一步均有唯一的加法常数;

3. 为减弱第二轮中函数G的对称性从(X&Y)|(X&Z)|(Y&Z)变为(X&Z)|(Y&(~Z));

4. 第一步加上了上一步的结果,这将引起更快的雪崩效应;

5. 改变了第二轮和第三轮中访问消息子分组的次序,使其更不相似;

6. 近似优化了每一轮中的循环左移位移量以实现更快的雪崩效应。各轮的位移量互不相同。

祝你好运!!!

关于AI,分享8个简单又强大的开源工具

AI,是指利用人工智能技术处理的工具。今天,我将分享8个简单且功能强大的开源AI工具,它们可以满足我们搜索资源、修复内容、更改样式等需求。

首先,让我们来看一下Stock AI。它是一款有趣的搜索引擎,拥有超过万张高质量的、视频和音乐。输入关键词,即可搜索。如果不存在,它会通过AI自动生成相似。个人可以直接免费下载文件。

其次,DiceBear是一个面向设计师和开发人员的开源头像生成库。你可以使用它为个人资料、设计、网站或应用程序创建合适的头像。除了随机生成简单可爱的用户头像,还可以使用内置的PRNG创建确定性头像。项目还提供了API,供开发者接入调用。

再来是Avvvatars,这是一个轻量级开源的头像生成器。可以快速生成一款独特头像,拥有种颜色、种形状搭配。项目支持自定制,如使用阴影、更改大小、提供要显示的替代文本等操作,且可集成到Web项目中。

Photoshot是一款开源的AI头像生成器。可以上传个人头像,利用Stable Diffusion模型进行训练,生成拥有不同风格的个人头像。官网提供使用指南。

Lama Cleaner是一个图像修复工具,基于SOTA AI模型构建,功能强大。完全免费和开源,支持CPU、GPU、M1/2。可以快速去除、替换图像中的各种物体,如人物、字体、水印等,同时支持老照片修复、文本替换图像内容等功能。

One Last Image是一个在线生成器,可以将赛璐璐风格的动画截图或插画转换成One Last Kiss封面风格。用户可以自定义设置,包括线条处理方案、开关One Last Kiss风格、给画面暗部排铅笔调子、叠加类似One Last Kiss 光碟封面水印、初回限定盘面效果选项、线迹轻重、调子数量等。官网提供详细操作指南。

Pixel Art to CSS是一个基于React开发的像素艺术动画和绘图网络编辑工具,通过结合CSS的box-shadow和keyframes特性,实现了在线绘制像素风图像的需求。提供自定义调色板、来回切换、修改动画设置、保存或加载项目等功能。完成绘制后,可以将内容导出成GIF、静态图像或纯代码等信息,用于网站。

Watermark-Removal是一个开源的去水印解决方案,基于机器学习的图像修复方法,自动去除水印。处理后的与原图几乎一致,内容去除无痕迹。GitHub提供源代码。

以上这些AI工具,不仅简单易用,而且功能强大,可以满足各种处理需求。希望这些信息能帮助到您!

nodejs douyin网页端搜索接口及x_bogus、a_bogus(包含完整源码)(--)

抖音的x_bogus和a_bogus算法用于数据校验,确保请求来源的有效性和数据安全性。它们对于批量获取抖音数据,如评论、无水印视频、弹幕监听和直播间抢货等,至关重要。此算法由特定的数据、浏览器标识符、时间戳等组成,通过一系列计算得到位大数组,之后转化为字符并添加随机字符进行加密,以提供额外的安全保障。

为了使用x_bogus和a_bogus值,您需要了解其具体作用。首先,它们对所有抖音数据验证至关重要。其次,它们帮助保护抖音作为最大短视频平台的数据安全。通过获取这些数据,您可以进行多样化操作,如获取评论、下载无水印视频、监听弹幕或参与直播间活动。

获取抖音搜索结果的接口地址通常可以通过浏览器的f功能找到。该接口的参数包括分页的偏移(offset)、用于搜索分页的search_id、排序类型(sort_type)和发布时间过滤条件(publish_time)等。

在实际操作中,参数的设置按照如下说明:综合排序时使用sort_type=0,按最新发布排序时使用sort_type=2,最多点赞排序时使用sort_type=1。发布时间过滤条件有:不限、一天内、一周内、半年内和半年以上,通过publish_time参数来设置。

为了帮助开发者更好地理解和实现这一功能,完整源代码提供了详细的实现步骤和逻辑。在调试环境中,您能够验证和调整代码,确保其准确无误地执行所需功能。

接口的运行结果通常会包含下一页的search_id,例如"logid":"A1BEA8CE6D",这是获取下一页数据的关键参数。

在构建和优化您的项目时,参考完整源代码并遵循调试环境的配置指南,将有助于您顺利实现与抖音数据的交互,并确保数据获取过程的高效性和安全性。